In meinem letzten Artikel Robots Exclusion Protocol und das Geheimnis des X-Robots-Tag gibt es eine kurze Passage zum Thema Suchmaschinen, in der ich bereits flüchtig auf deren Funktionsweise eingehe. Daran möchte ich heute gerne anknüpfen und erläutern, wie Suchmaschinen funktionieren.

Wie funktioniert eine Suchmaschine?

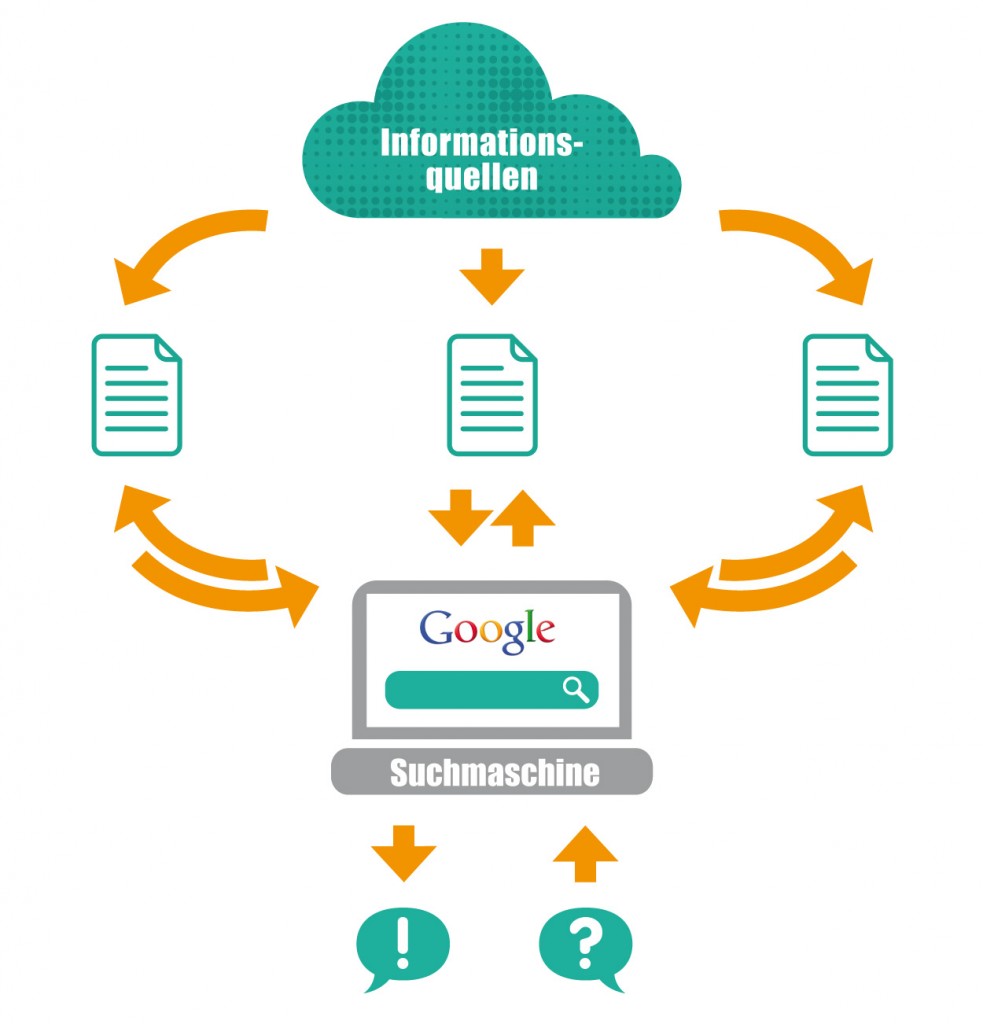

Die Funktionsweise von Suchmaschinen besteht aus den Schritten Crawling und Indexierung. Zunächst ruft der Crawler (auch Spider oder Bot genannt) Webseiten auf und speichert diese in einer Datenbank ab. Anschließend werden diese Daten gesammelt und indexiert. Wird eine Suchanfrage gestellt, schaut die Suchmaschine im Index nach, auf welchen Internetseiten der gesuchte Begriff vorkommt. Ein Algorithmus entscheidet letztendlich, welches Ranking die Seite in den SERPs erzielt.

Volltext- und Metasuchmaschinen

Vertikale Suchmaschinen, Föderierte Suchmaschinen, Enterprise Search – wie soll man bei der Vielzahl an Kategorisierungsmöglichkeiten für Suchmaschinen den Überblick behalten? Ich halte es an dieser Stelle ganz einfach und unterteile Suchmaschinen in zwei wesentliche Arten: Metasuchmaschinen und Volltextsuchmaschinen. Letztere, zu denen u. a. Google und Bing zählen, durchsuchen und indizieren den gesamten Text einer Webseite bzw. eines Dokumentes. Das heißt, Suchmaschinen, die auf einer Volltextsuche basieren, verweisen bei der Abfrage nach einem beliebigen Begriff oder einer Wortgruppe auf alle relevanten Dokumente, die sie durchsucht haben und in denen der gesuchte Begriff enthalten ist.

Metasuchmaschinen wie MetaGer oder die „diskreteste Suchmaschine der Welt“ ixquick hingegen sammeln gar nicht selber, sondern übergeben eine Suchanfrage an mehrere andere Suchmaschinen, greifen deren Ergebnisse ab und verarbeiten die Informationen zu einer eigenen Trefferliste (SERPs).

Arbeitsweise von Suchmaschinen

Leider ist es so, dass die einzelnen Suchdienste unterschiedliche Algorithmen für den Suchprozess verwenden und weil diese mindestens genauso gut behütet sind wie die Kronjuwelen von Queen Elizabeth, kann man nicht exakt sagen, wie Suchmaschinen funktionieren – jedoch sind die allgemeinen Funktionen gleich.

Crawler

Um die Funktionsweise von Suchmaschinen zu verstehen, ist es wichtig zu wissen, dass Suchmaschinen bei einer Suchanfrage (Query Processing) nicht das gesamte World Wide Web durchsuchen, sondern immer nur die Seiten, die sie in ihrem Index haben – demnach beginnt die Arbeit einer Suchmaschine weit vor der eigentlichen Suche.

An erster Stelle steht der Crawler, auch Spider, Robot oder Bot genannt. Er ist ein vollautomatischer Informationssammler, der für die Erfassung von Dokumenten im Web zuständig ist. Dafür ruft er eine Webseite nach der anderen auf und speichert diese in einer Datenbank (Repository) ab, beginnend mit den Websites und URLs, die von den Webmastern angemeldet wurden. Bei Google geht das ganz einfach mithilfe der Webmaster Tools.

Beim Crawlen stehen ganz klar HTML-Dokumente im Fokus, aber auch die Indexierung von Texten aus .ppt- oder .pdf-Dateien ist möglich. Der Crawler durchsucht aber nicht nur den Content einer Website sondern auch deren Meta-Tags. Außerdem folgt er den Links auf der Seite (Harvesting) und entdeckt mitunter Seiten, die sich noch nicht in der Datenbank befinden.

Weitere Keyfacts im Überblick:

- Crawler nehmen nur eine bestimmte Anzahl an Seiten einer Domain in die Datenbank auf

- Domains mit einer hohen Popularität (z. B. hoher PageRank) werden gründlicher erfasst

- Die Anzahl der Linkebenen, die ein Crawler in einer Site hinuntersteigt, unterscheidet sich von Suchmaschine zu Suchmaschine

- Die Zyklen, in denen Crawler zu einer Domain zurückkehren, variieren; wenn eine Site häufig aktualisiert wird, kommt z. B. der Googlebot täglich vorbei

- Meistens sind mehrere Crawler auf einmal unterwegs – 7% des gesamten Netzverkehrs wird durch Robots verursacht

Sollte der Crawler auf einer Seite unerwünscht sein, kann dieser mittels robots.txt ausgeschlossen werden.

Indexer

Der Indexer bereitet die vom Crawler gesammelten Daten, die er sich aus dem Repository abholt, auf und erstellt damit einen Index. Für jedes Wort wird ein Eintrag mit der genauen Position im Datenbestand erstellt (Invertierte Datei). Dadurch wird der Index schnell und effizient durchsuchbar gemacht. Wenn nun eine Suchanfrage gestellt wird, schaut die Suchmaschine zuerst im Index nach, auf welchen Internetseiten der gesuchte Begriff vorkommt. Danach holt sie sich aus dem Repository Informationen zu jeder Seite wie z. B. Title und Description und stellt diese in den SERPs dar – sollten keine vorhanden sein, generiert die Suchmaschine diese automatisch.

Um die Auswahl aus den mitunter Tausenden von Suchergebnissen zu erleichtern, wird von den Suchmaschinen eine automatische Bewertung des Index bzw. der Relevanz eines Suchtreffers vorgenommen (Ranking). Jede Suchmaschine setzt dabei andere Mechanismen ein, weshalb die einzelnen Suchmaschinen trotz gleicher Dokumente im Index unterschiedliche Ergebnisse liefern. Aspekte, die in diese Evaluation mit einbezogen werden, sind u. a. die Anzahl der übereinstimmenden Wörter, die Häufigkeit des Vorkommens von Suchbegriffen (URL, Title, Description, Hauptüberschrift) sowie deren Position oder die Verlinkung von anderen Websites.

Searcher

Der Searcher ist die einzig sichtbare Funktion einer Suchmaschine. Von ihm wird die Suchanfrage des Internetnutzers ausgewertet. Während einer Suchanfrage gleicht diese Systemkomponente die eingegebenen Begriffe mit den im Index gespeicherten Informationen ab und gibt die entsprechenden Ergebnisse als SERPs aus.

Puh, alles verstanden? Solltet ihr noch Fragen haben, stellt diese gerne in den Kommentaren.

Sandra und die SEO Trainees.

26 Antworten

Wirklich sehr gut geschrieben, jedoch schätze ich den Robot Traffic selber auch sehr viel höher ein. Ansonsten Top Artikel!

Liebe Sandra,

ich habe viel gelernt, aber meine (womöglich dumme) Frage bleibt offen. Ich wollte dies herausfinden: wenn eine Suchmaschine neu in einen Blog gestellte Bilder oder Dokumente aufnimmt, ist das Finden der Bilder/Dokumente nur dann möglich, wenn der Blog aktiv (online) ist, oder findet die Suchmaschine auch diese Dokumente, wenn der Blog passiv (offline) ist?

Viele Grüsse von Dirk

Dumme Fragen gibt es nicht, Dirk. Eine Suchmaschine kann Bilder und Dokumente in einem Blog nur finden, wenn sie von dessen Existenz weiß, d. h. entweder zeigen Links auf den Blog und stoßen die Suchmaschine quasi mit der Nase auf die vorhandene Website oder du zeigst das Vorhandensein deines Blogs bei den Google Webmaster Tools an – dieses Vorgehen würde ich jedem Webmaster empfehlen.

Zur Veranschaulichung: Szenario 1.) Wenn du also einen neuen Blog hast, auf diesen aber noch keine Links verweisen und du ihn auch noch nicht bei den Webmaster Tools eingereicht hast, dann wird die Suchmaschine den Blog und die sich darauf enthaltenen Bilder und Dokumente nicht finden. Szenario 2.) Wenn du die letzten drei Jahre einen Blog betrieben hast und in der Zeit auch ein paar Links eingesammelt wurden, der Blog dann aber offline geschaltet wird, besteht die Möglichkeit, dass der Blog und dessen Inhalte weiterhin gefunden und indexiert werden. Die Entfernung von Blog-Inhalten aus dem Index einer Suchmaschine ist mitunter schwierig, aber nicht unmöglich wie ich aus eigener Erfahrung weiß. WordPress hat das in der Vergangenheit für mich super gelöst.

Herzlichen Dank, das beantwortet meine Fragen erschöpfend ! Dirk

Prima, das freut mich! 🙂

Bin grad am stöbern gewesen und habe diesen Artikel entdeckt. der gefällt mir sehr gut. und ist auch wunderbar verständlich

Danke ffür den Beitrag und die erläuterung

Es war mir eine Freude! 😀

Ich glaube, so versteht es jeder! 😉

Danke fuer die gute Erklaerung 🙂

Gerne! Freut mich, dass dir der Artikel gefallen hat! 🙂

Ich klebe an deinen Worten. Dieser Blog ist einer der besten, der die SEO / Arbeitsweise der Suchmaschinen – Zusammenhänge auch VERSTÄNDLICH beschreibt. Klasse!

Ich freue mich sehr, dass du das so siehst Mario! 😀 Vielleicht kannst du das bis Freitag auch nochmal den Jungs von SEO United mitteilen… *hüstle* http://www.seo-united.de/blog/seo/seo-wahlen-2012-nominierung.htm 😉

Sehr schön geschriebener Artikel. Jeder der sich mit SEO auseinandersetzt, sollte sich vorher zuerst mit der Funktionsweise der Suchmaschinen im Allgemeinen beschäftigen. Dazu bietet euer Artikel einen sehr guten Einstieg.

Da stimme ich dir zu, Michael. Aber ich musste feststellen, das lange nicht alle SEOs wissen, wie eine Suchmaschine genau funktioniert. Schade, dabei ist das Thema sehr spannend und wichtig, um Suchmaschinenoptimierung (richtig) betreiben zu können.

Toller Artikel. Sehr verständlich und „rischtisch“ gut geschrieben.

Mission erfüllt! 😀

Super Erklärt und tolle Grafiken!!!

Manchmal möchte man den Leuten wirklich sagen „Geht nach Hause und lernt die Basics“ – nun kann man auf diesen Artikel verweisen! 🙂

Nur zu! 🙂

Danke für den tollen Artikel, trotzdem möchte ich jetzt noch was zu den Ponys wissen ;-).

Ich freue mich, dass dir der Artikel gefallen hat! Über die Ponys gibt dir übrigens das YouTube-Video Aufschluss, also einfach mal reinschauen! 😉

Die Grafiken verdichten die Zusammenhänge sehr gut. Danke für den Artikel!

Matthias, Lisa,

es freut mich das euch der Artikel gefallen hat. Die Grafiken sind in der Tat wunderbar gelungen. Da hat unsere Grafikabteilung wirklich sehr gute Arbeit geleistet! Großes Lob von mir an dieser Stelle! 🙂

Eine sehr veranschaulische Grafik und tolle Erklärung mit den Suchmaschinen.

Auch toll ist das Video 😀

Hallo Sandra,

danke für den super Artikel. Ich finde das anschaulich erklärt und sehr gut dargestellt. Ich bezweifle allerdings, dass der durch Bots und Spider verursachte Traffic lediglich bei 7% liegen soll. Unter der angegebenen Quelle kann man leider nicht qualifizieren von wann die Daten stammen und auch nicht woher sie stammen. Anfang des Jahres hab ich gelesen, dass ca. 50% der Traffics nicht von Menschen stammen (http://www.at-web.de/blog/20120316/nur-49-der-besucher-einer-website-sind-menschen.htm). Das erscheint mir plausibler. Ich glaube aber über Bots und Spider etc. könnte man alleine einen Artikel schreiben 😉

BG

Dom

Lieber Dominik,

vielen Dank für die zusätzlichen Infos. Bezüglich des von Crawlern verursachten Traffics scheint es wirklich keine eindeutigen Zahlen zu geben.

Hm, vielleicht bedarf es aber auch nur mehr Recherchezeit. Ein Artikel über Suchmaschinen-Robots erscheint mir eine gute Idee, ist notiert! 🙂