Vergangenen Monat haben wir einen einleitenden Artikel zu den Google Webmaster Tools veröffentlicht. In diesem haben wir euch das Tool zunächst vorgestellt und darüber hinaus gezeigt, wie ihr eure Seite anlegt und die nötigen Konfigurationen vornehmt. In dem heutigen Artikel möchten wir tiefer in die Funktionen des Tools eintauchen und euch zeigen, welche Möglichkeiten die Google Webmaster Tools bieten, eure Domain zu optimieren und zu überwachen.

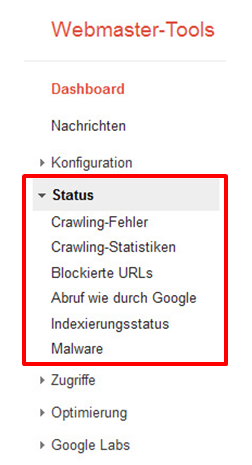

Im Prinzip hangeln wir uns im Laufe dieser Artikelserie an den Navigationspunkten der Webmaster Tools entlang, behandeln jedoch nicht jeden Punkt mit derselben Ausführlichkeit und Sorgfalt, sondern setzen Akzente bei Funktionen, die wir als besonders wichtig und/oder hilfreich erachten. Im ersten Teil haben wir uns mit dem Menüpunkt „Konfiguration“ befasst, heute widmen wir uns dem „Status“.

Status

Status

Hinter dem Menüpunkt „Status“ verbergen sich vielerlei Informationen dazu, wie Google eure Domain sieht und behandelt. Hier könnt ihr sehen, wie viele Seiten eurer Domain von Google gecrawlt und indexiert werden und ob es diesbezüglich Fehler gibt.

Crawling-Fehler

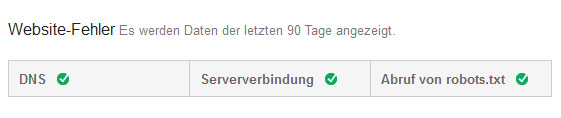

Bei Crawling-Fehlern unterscheidet Google Website-Fehler und URL-Fehler. Website-Fehler sind solche, die die gesamte Domain betreffen. Hierbei handelt es sich grob gesagt um Server-Kommunikation, das Vorhandensein einer Robots.txt sowie gesperrte Inhalte durch die Robots.txt. In der Regel treten in dieser Rubrik eher selten Fehler auf. Sind in den vergangenen 90 Tagen keine Website-Fehler aufgetreten, signalisiert Google dies mit einem grünen Häkchen.

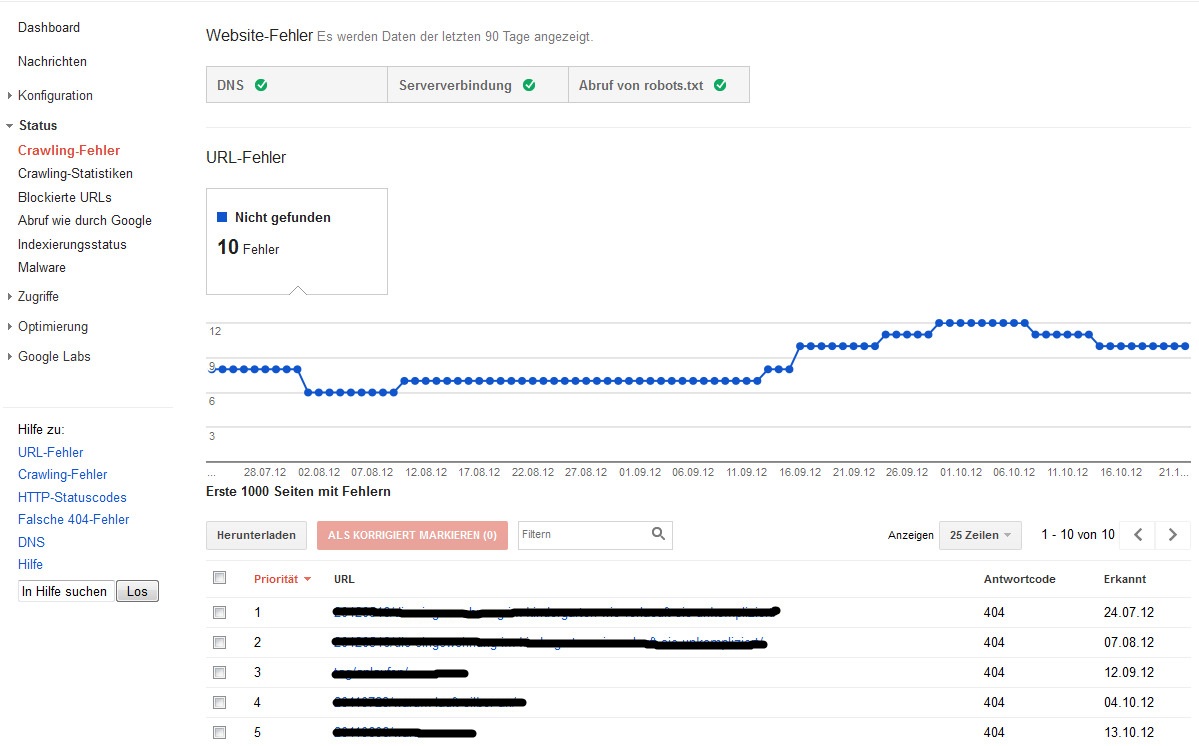

URL-Fehler hingegen betreffen einzelne URLs und sind in verschiedene Kategorien eingeteilt. Abhängig davon, welche Fehler auf eurer Domain auftreten, wird hier auch nur die entsprechende Kategorie angezeigt. Die wohl am häufigsten auftretende Fehler-Kategorie ist „Nicht gefunden“. Hier listet Google alle URLs eurer Domain auf, die den Statuscode 404, also eine Fehlerseite ausliefern. Das passiert immer dann, wenn eine URL, die nicht mehr existiert (gelöscht, umgezogen, umbenannt), von mindestens einer anderen Seite (intern oder extern) verlinkt wird.

Klickt ihr nun in der Auflistung auf die URL, öffnet sich ein Detailfenster, in dem ihr zusätzliche Informationen bekommt. Interessant ist hier der Reiter „Verlinkt über“. Hier könnt ihr sehen, von welchen Seiten die fehlerhafte URL verlinkt wird. Falls ihr bestehende Fehler bereits korrigiert habt, diese jedoch in den Webmaster Tools noch nicht aktualisiert worden sind und somit nach wie vor als Fehler aufgeführt werden, habt ihr über die Schaltfläche „Als korrigiert markieren“ die Möglichkeit, berichtigte Fehler als solche zu kennzeichnen und damit euren Report zu aktualisieren.

Weitere Kategorien der Crawling-Fehler sind:

- Serverfehler: Server-seitig kann die URL nicht aufgerufen werden (5xx-Server-Fehler).

- Soft-404-Fehler: Seiten, die zwar einen Hinweis ausgeben, dass es sich hierbei um eine 404-Fehlerseite handelt, jedoch den Statuscode 200 (OK) ausliefern.

- Zugriff verweigert: Seiten können ohne eine Authentifizierung nicht aufgerufen werden.

- Nicht gefolgt: Seiten, deren Pfad der Googlebot nicht folgen konnte. Mögliche Ursachen: Verwendung von JavaScript, Flash, Cookies, Sitzungs-IDs sowie fehlerhafte Weiterleitungen.

Crawling-Statistiken

Hier seht ihr die Crawling-Aktivitäten des Googlebots auf eurer Domain im zeitlichen Verlauf. Angezeigt werden hier: pro Tag gecrawlte Seiten, pro Tag heruntergeladene Kilobyte sowie die Dauer des Herunterladens einer Seite.

Blockierte URLs

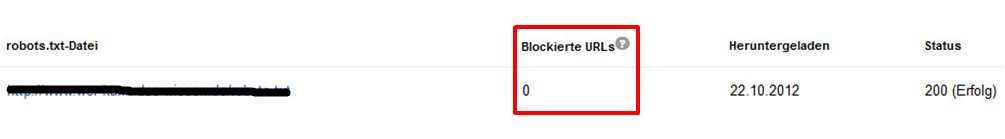

Diese Funktion der Webmaster Tools bietet euch die Möglichkeit, durch die Robots.txt für den Googlebot blockierte URLs zu überprüfen. Schnell könnt ihr der Übersicht entnehmen, ob auch wirklich diejenigen URLs/Verzeichnisse blockiert sind, die ihr auch tatsächlich ausschließen möchtet. Diese Funktion ist recht hilfreich, da es durchaus vorkommen kann, dass man durch falsche Angaben in der Robots.txt versehentlich URLs oder sogar ganze Verzeichnisse vom Crawling ausschließt, die man eigentlich indexiert haben möchte.

Solltet ihr keine Robots.txt-Datei angelegt oder in einer vorhandenen Robots.txt keine Pfade bzw. Verzeichnisse gesperrt haben, werden natürlich auch keine URLs blockiert, wie es im Beispiel der Fall ist.

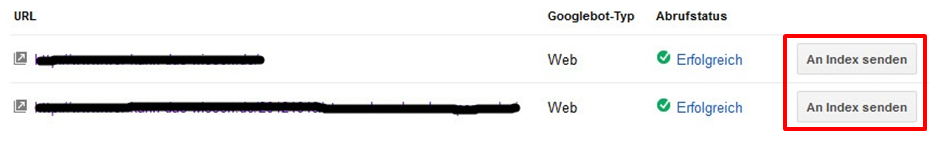

Abruf wie durch Google

Diese nützliche Funktion bietet gleich mehrere Möglichkeiten. Zum einen könnt ihr hier Google mitteilen, dass ihr neue Seiten oder aber Seiten mit aktualisierten Inhalten habt, und Google anweisen, diese Seiten in den Index aufzunehmen. Dazu müsst ihr zunächst die entsprechende URL in das Eingabefeld eintragen und anschließend auf den Button „An Index senden“ klicken. Zu beachten ist, dass diese Funktion auf 500 URLs pro Woche begrenzt ist. Natürlich muss Google diese Anweisungen, die eher Empfehlungen oder Hinweise sind, nicht strikt befolgen. Die Wahrscheinlichkeit, dass eure Inhalte schnell indexiert werden, ist auf diese Weise jedoch höher als zu warten, bis der Googlebot auf seiner nächsten Patrouille auf die neuen Inhalte stößt.

Des Weiteren habt ihr mit der Funktion „Abruf wie durch Google“ die Möglichkeit, genau den Quelltext zu sehen, den auch der Googlebot beim Crawlen analysiert. Nützlich ist dies besonders im Hinblick auf Malware. Sollte eure Seite Opfer eines Hacker-Angriffs werden, so kann es passieren, dass Inhalte auf eurer Seite eingepflanzt werden, die mittels Cloaking nur dem Googlebot präsentiert werden, nicht aber dem normalen User. Durch einen Klick auf „Erfolgreich“ unter Abrufstatus lassen sich betroffene Seiten identifizieren, denn hier sieht man, welchen Quelltext der Googlebot zu Gesicht bekommt.

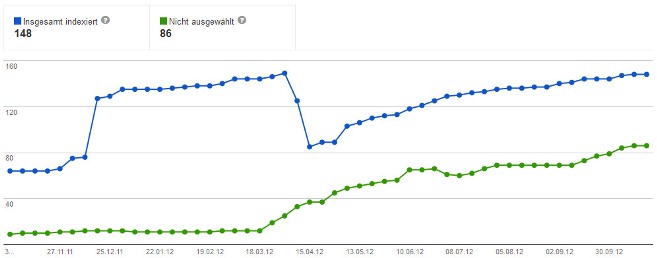

Indexierungsstatus

In Form eines Graphen seht ihr hier die Anzahl der indexierten Seiten eurer Domain im zeitlichen Verlauf eines Jahres.

Die angezeigten Informationen könnt ihr um sinnvolle Daten ergänzen, indem ihr auf „Erweitert“ klickt. Hier könnt ihr euch neben der Anzahl indexierter Seiten wahlweise auch alle jemals gecrawlten, nicht ausgewählten, durch die Robots.txt blockierten oder entfernten URLs anzeigen lassen. Besonders die nicht ausgewählten URLs können interessant sein. Dies sind nämlich URLs, welche zwar gecrawlt, jedoch nicht indexiert worden sind. Gründe dafür können sein, dass die URLs durch das Meta Robots Tag „Noindex, Follow“ von der Indexierung ausgeschlossen sind oder dass identische Inhalte unter mehreren URLs aufgeführt sind (Duplicate Content), von denen Google verständlicherweise im Idealfall nur eine URL in den Index aufnimmt. Diese Übersicht eignet sich demnach sehr gut, um Duplicate Content auf die Spur zu kommen. Wünschenswert, jedoch leider (noch) nicht vorhanden, wäre eine Auflistung aller URLs und nicht bloß die Angabe der Anzahl.

Malware

Hat Google eine Infizierung eurer Website durch Malware entdeckt, bekommt ihr unter diesem Menüpunkt einen entsprechenden Warnhinweis und habt damit die Möglichkeit, die entsprechende Seite zu analysieren (Abruf wie durch Google) und den schädlichen Code zu entfernen. Sollte Google tatsächlich Malware auf eurer Domain entdeckt haben, bekommt ihr zusätzlich eine Benachrichtigung in den Webmaster Tools. Die Infizierung der eigenen Website durch Malware ist ein durchaus ernstzunehmendes Thema, denn ein solcher Befall kann sich nicht nur negativ auf das Ranking sowie die Usability eurer Seite auswirken, sondern führt in krassen Fällen sogar zum Ausschluss der Seite aus dem Index.

Sämtliche Berichte in den Webmaster Tools lassen sich als CSV oder Google Doc exportieren, sind jedoch immer jeweils auf 1.000 Datensätze beschränkt.

Fazit

Der „Status“-Bereich der Google Webmaster Tools bietet einen guten Überblick darüber, wie Google eure Domain wahrnimmt und behandelt. Schnell könnt ihr hier einsehen, ob Google auf Probleme beim Crawlen der Seiten gestoßen ist, ob die Robots.txt sinnvoll und zielführend ausgezeichnet ist und in welchem Umfang Google die Inhalte eurer Domain indexiert. Darüber hinaus könnt ihr Google hier auf neue Inhalte aufmerksam machen, den Quelltext mit den Augen des Googlebots sehen und werdet informiert, falls eure Seite mit Malware infiziert worden ist. Gerade den Crawling- und Indexierungsstatus der eigenen Domain solltet ihr stets im Auge behalten, denn diese Werte stellen einen verlässlichen Indikator für die „Gesundheit“ der Domain dar.

In einem dritten und letzten Teil dieser Artikelserie werden wir die übrigen Funktionen der Google Webmaster Tools unter die Lupe nehmen und ein Gesamtfazit zu den Webmaster Tools ziehen. All denjenigen unter euch, die sich in aller Ausführlichkeit mit den Google Webmaster Tools befassen möchten, empfehlen wir wärmstens das kostenlose Ebook zu den Google Webmaster Tools von Stephan Czysch.

Andreas und die SEO Trainees

17 Antworten

Ich würde gründsäzlich immer das Webmaster Tool von Google nutzen. Nicht nur Fehler in der Sitemap und der Robot.txt werden sofort erkannt, sondern man bekommt auch viele weitere Informationen wie Suchanfragen, Suchanfragenanalyse, Snipet Erstellung und und und. Toller Beitrag der den Aspekt der Google Tools und Möglichkeiten gut rüberbringt, auch wenn der Artikel schon etwas älter ist.

Der zweite Teil ist ebenso wie der erste Teil sehr gut erklärt. Ich werde jetzt gleich mal meine URLs in den Tools eintragen und an den Google Index senden. Ich hoffe, dann geht das alles ein bisschen schneller. Ich bin schon gespannt auf die ersten Daten. Danke für eure Hilfe.

Stimmt es, dass man eher Google Analytics braucht als Webmaster Tools? Wo liegen die Vorteile des ersteren?

Hallo Holger,

die Webmaster Tools und Google Analytics ergänzen sich ganz gut und haben unterschiedliche Schwerpunkte. Grundsätzlich ist es empfehlenswert, beide Tools zu nutzen. Bei Analytics bekommst du detaillierte Daten und Auswertungen zu den Besucherzahlen, zum Besucherfluss, zur Verweildauer usw. und kannst dir diese Daten für jeden Content/jede Seite anschauen. Es kommt natürlich immer darauf an, welche Ziele du verfolgst und welche Informationen du dazu brauchst.

Gruß,

Andreas

Vielen Dank für den Überblick über google Webmaster Tools.

Ich habe schon überall nach einer passenden Einführung gesucht, da es ohne Hilfestellung fast zu komplex ist.

Hallo zusammen,

danke für diesen tollen Artikel.

Da ich noch ziemlich am Anfang stehe, haben mir diese Informationen sehr weiter geholfen.

Schöne Grüße aus Bayern

Ein wirklich toller Artikel. Gerade für Anfänger wirklich Gold wert!

Schön, dass euch der Artikel gefällt und hilft 🙂

Gruß

Andreas

Vielen Dank für den Artikel! Habe erst vor kurzem Google Webmaster Tools für meine Website angewendet. Durch deinen Artikel konnte ich mir einige Tipps einholen, welche ich jetzt anwenden werde.

Danke! Sehr hilfreich….! Gruss Martin

Wow! Danke für die ausführliche Übersicht. Ich persönlich habe die Webmaster-Tools noch nicht wirklich intensiv genutzt, aber der Bericht zeigt mir, dass dort sehr viel Potenzial vorhanden ist. Vor allem die Tipps bezüglich der Robot.txt sind sehr informativ, danke!

Unklar ist bis jetzt nach wie vor, ob es sinnvoll ist eine Sitemap zu haben oder nicht (sorry, leicht OT aberich frag trotzdem ; – ). Eigentlich braucht man ja eine Sitemap nicht, Aber Webmaster Tools impliziert bis heute, das man eben eine braucht… Das sollte GOOG mal beheben.

Hi Lelala,

es ist eigentlich immer sinnvoll, eine Sitemap anzulegen und zu übermitteln, zumal der Aufwand ja sehr gering ist, da das größtenteils automatisiert von Tools und Plugins übernommen wird. Die Relevanz einer Sitemap steigt mit der Größe deiner Seite. Durch die Sitemap gewährleistest du, dass Google von sämtlichen Inhalten deiner Domain erfährt. Wichtig vor allem für Inhalte, die intern & extern schlecht verlinkt sind.

Besten Dank für den Beitrag. LG aus Niedersachsens Landeshauptstadt!

Danke, das hat mir einige Detaile und Optionen erklärt, die ich nicht rühren wollte.