Wir von SEO-Trainee.de arbeiten in unserem SEO-Alltag sehr oft mit verschiedenen Tools, die Aufschluss über die technischen Begebenheiten, den Content, die Meta-Angaben und vieles mehr im OnPage-Bereich einer Website geben. Vor Kurzem wurde uns ein neues Tool vorgestellt, mit dem man viele dieser Aspekte überprüfen kann: DeepCrawl. Momentan wird es von SEOs in über 40 Ländern weltweit genutzt und bietet viele Möglichkeiten, projektbezogene OnPage SEO zu betreiben. Einige der Funktionsweisen wollen wir euch daher heute vorstellen und zeigen, was man mit DeepCrawl alles machen kann.

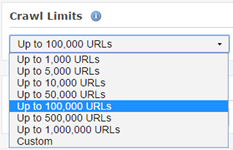

Möchte man eine Website mit DeepCrawl analysieren, geschieht dies in der Cloud. Über einen User Account kann man unterschiedliche URL-Pakete erstehen. Deren Größe und Preis hängt davon ab, wie umfangreich die Websites sind, die man crawlen möchte. Ein Monatspaket über 100.000 URLs liegt beispielsweise bei 60 Euro. So kann die URL-Anzahl je nach Bedarf angepasst bzw. aufgestockt werden. Doch was bekommt man für sein Geld? Wir haben uns zwei wichtige Dinge angeschaut: Die Einstellungen beim Crawlen einer Website und die Report-Arten, die das Tool zur Analyse bietet.

Die Eigenschaften des Crawls

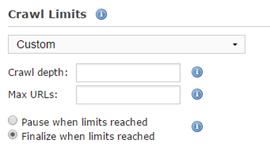

Einmal eingeloggt, kann es losgehen mit dem ersten Crawl-Projekt. Hat man gleich mehrere Websites, die man crawlen möchte, können bis zu 20 Projekte parallel laufen. Will man Websites nicht nur einmalig analysieren, sondern mögliche Veränderungen beobachten, kann man auch direkt einen regelmäßigen Crawl (wöchentlich, zweiwöchentlich, monatlich) initiieren. Dabei kann auch die Uhrzeit angegeben werden. Das ist praktisch, wenn der Crawl aufgrund einer hohen Anzahl von URLs sehr lange dauert und man ihn beispielsweise schon nachts starten lässt, um am nächsten Tag damit zu arbeiten. Um zu vermeiden, dass die Server der Website lahmgelegt werden, kann man auch die Schnelligkeit des Crawls festlegen. Mit der „Web Crawl Depth“ lässt sich festlegen, wie tief eine Website durchsucht werden soll. Empfohlen wird eine Ebenentiefe von maximal 8, was zwei Vorteile hat: Suchmaschinen wie Google indexieren tiefer liegende Ebenen eher selten, außerdem lässt sich so die maximale URL-Anzahl im DeepCrawl Account gering halten. Man kann auch bei jedem Projekt eine maximale URL-Anzahl angeben, die gecrawlt werden soll. Wenn man von den voreingestellten Standardeinstellungen des Tools abweichende Crawling-Eigenschaften benutzen will, kann man diese auch zu seinen personalisierten Standard-Einstellungen machen.

Generell kann zwischen fünf Crawl-Typen gewählt werden. Entweder crawlt man nur die Website, nur die Sitemap oder führt einen Universal Crawl durch, der diese beiden kombiniert und ebenfalls die Google-Analytics-Daten, die zuvor mit dem Projekt verknüpft wurden, berücksichtigt. Außerdem lassen sich im Hinblick auf einen Backlink Audit ein Backlink Crawl und ein Listen-Crawl durchführen. Beim Listen-Crawl fokussiert man sich auf das Crawlen bestimmter Seiten. Der Backlink Crawl gibt wichtige Einblicke in das OffPage-Profil einer Website.

Der Cloud-Mechanismus von DeepCrawl bietet auch beim Anlegen verschiedener Crawls einige Vorteile. Wenn man mit mehreren Usern an einem Projekt arbeitet, ist es möglich, alle Beteiligten in das Projekt zu integrieren. Dabei lassen sich dann ausstehende Crawls per „Issues“ oder „Tasks“ an sich selbst oder seine Mitarbeiter verteilen. Man erhält eine Erinnerung per Mail, wenn der Crawl ansteht.

Ansprechende Ergebnisse in verschiedenen Report-Typen

Sehr wichtig beim Nutzen eines OnPage Tools ist, dass die Ergebnisse nicht nur so aufbereitet sind, dass man sie gut verstehen kann, sondern auch visuell ansprechend sind, dass man sie mühelos weiterverwenden kann. Dies geschieht meistens in Report-Form. Bei DeepCrawl kann man zwischen drei Typen von Reports wählen:

- Snapshot Report: Dieser Berichttyp bietet sich vor allem bei einmaligen Crawls an und liefert die Ergebnisse in sehr übersichtlichen Kreisdiagrammen und Listen. Sie präsentieren alle wichtigen Fakten zum Crawl.

- Diffing Reports: Diese Reports geben einen besonders guten Überblick bei einem Vorher-Nachher-Vergleich. Wenn man konkrete Änderungen zwischen den beiden Crawls vorgenommen hat, die OnPage Konsequenzen trägt, lässt sich dies mit diesem Berichtstyp sehr gut feststellen und zeigen.

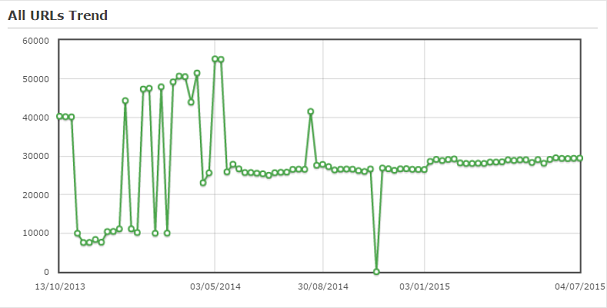

- Monitoring Report: Wenn man Entwicklungen über einen längeren Zeitraum beobachten möchte und regelmäßige Crawls angelegt hat, gibt die Monitoring-Berichtsfunktion eine übersichtliche Darstellung.

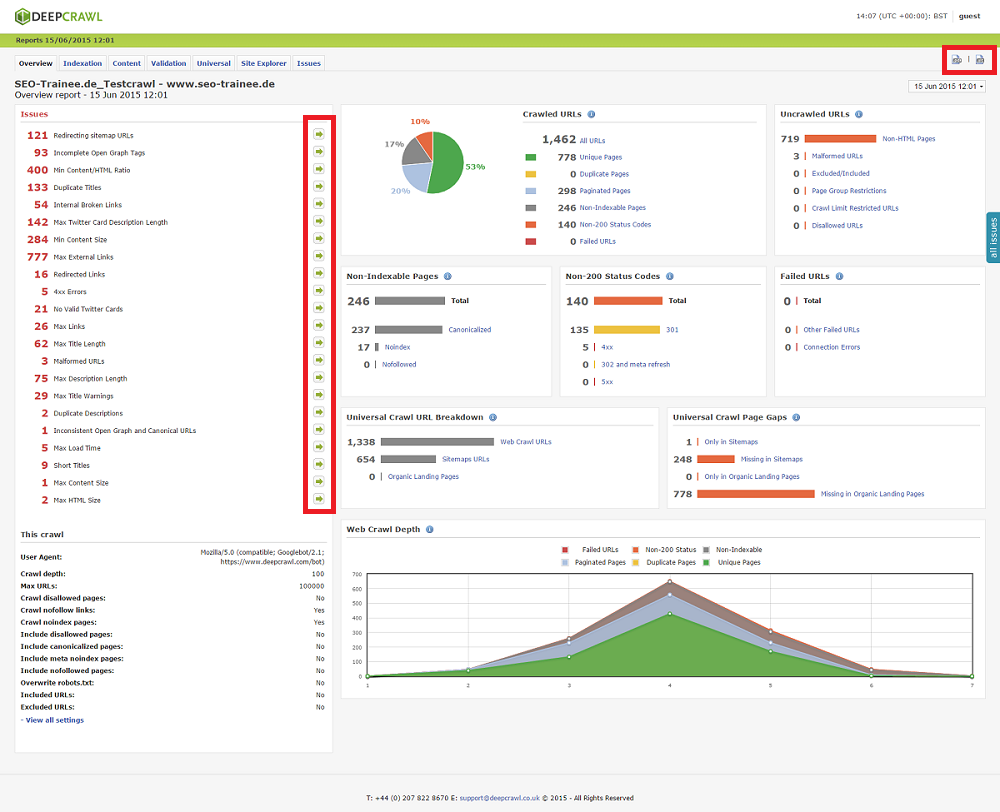

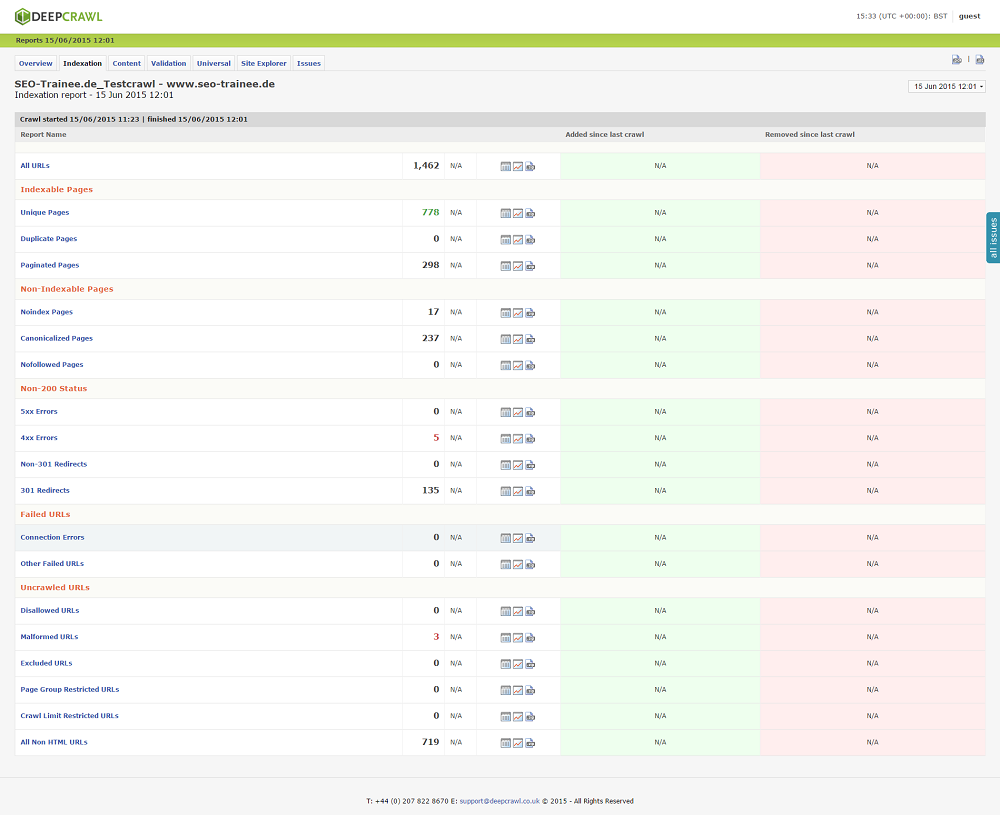

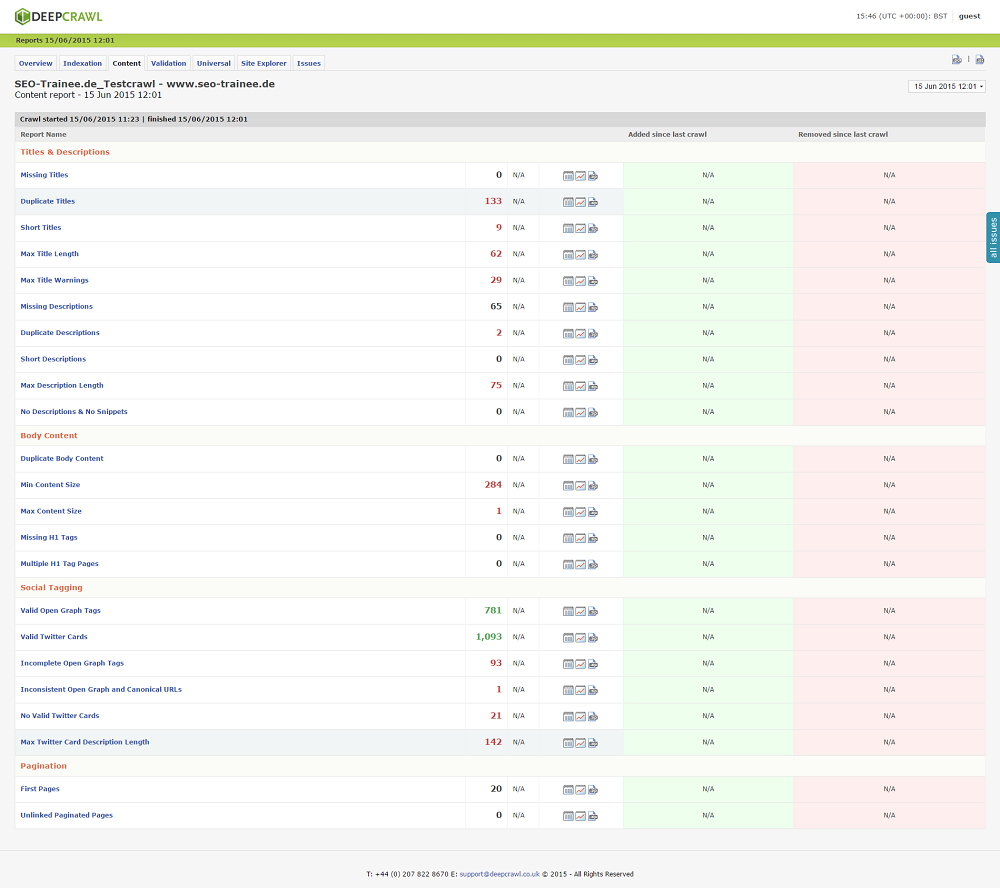

Wir haben das Ganze natürlich auch praktisch getestet und uns einen Report von unserer Domain SEO-Trainee.de angefertigt. Entschieden haben wir uns für den Snapshot, da es sich – zunächst – um einen einmaligen Crawl handelt. Der Report bietet neben einem Überblick auch verschiedene Analyseebenen: Neben dem „Overview“ gibt es eine detaillierte Einsicht zu den Bereichen „Indexation“, „Content“, Validation“, „Universal“ und „Site Explorer“. Der Overview zeigt, wie viele URLs gecrawlt wurden und welche Status-Codes sie liefern. Die blauen i-Punkte liefern Details zu den Aussagen. Außerdem werden links alle „Baustellen“ aufgeführt, die behoben werden sollten. Wenn man den Pfeil daneben klickt, wird genau aufgeschlüsselt, um welche URLs es sich genau handelt (wie unten im Screenshot rot markiert zu sehen).

Beim „Overview“ sowie bei allen anderen Bereichen lassen sich an jeder Stelle Reportings in Form von PDF- oder Excel-Dateien herunterladen, die nicht nur die genauen Daten zum Abspeichern ausgeben, sondern auch mit einem Label versehen werden können. Es stehen also an jeder Stelle Tabellen zur weiteren Anpassung zur Verfügung oder Ergebnisse, die man für eine mögliche Präsentation direkt hübsch aufbereitet vorfindet.

Der Punkt „Indexation“ listet die technischen Daten der einzelnen URLs genau auf: Hier findet man die indexierten und nicht-indexierten Seiten, ihre Statuscodes, Seiten mit Verbindungsfehler und nicht crawlbare Seiten. Hier können nicht nur die Einzelheiten zu den URLs eingesehen werden, sondern diese werden auch mit einem etwaigen vorherigen Crawl verglichen. Es wird also z.B. angezeigt, wie viele von den 404-Fehlerseiten im Vergleich zum letzten Crawl dazugekommen sind oder entfernt wurden (bei uns steht leider nur ein N/A, weil wir ja nur einen Crawl gemacht haben

Der Reiter „Content“ geht logischerweise auf den Content der Domain ein und liefert Informationen zu den Meta-Angaben der Domain sowie der Struktur des Contents und Duplicate Content. Außerdem zeigt er auch, inwieweit Social-Media-Verknüpfungen vorhanden sind und funktionieren.

Im Bereich „Validation“ werden die interne Verlinkung, die Performance hinsichtlich der Ladezeiten der URLs und andere technische Eigenschaften wie Weiterleitungen oder der Einsatz des hreflang-Tags untersucht. Der „Universal“-Reiter zeigt die XML Sitemaps und die Google-Analytics-Daten an. Optisch entsprechen diese Report-Teile der Darstellung der „Indexation“. Im Bereich „Site Explorer“ lassen sich die einzelnen Kategorien bzw. Pfade anzeigen und wie viele URLs sie jeweils umfassen. So hat z.B. unsere Kategorie /glossar bisher 272 URLs. Im letzten Reiter „Issues“ sind dann die bereits erwähnten Aufgaben aufgelistet, die es noch zu bearbeiten gilt.

Der DeepRank – die tool-eigene Ranking-Metrik

Besonders interessant ist es auch, wenn man sich die Details jedes Reiters genauer anschaut. Wählt man z.B. im Bereich „Indexation“ den Punkt „4xx Errors“ aus, werden die Seiten mit 4xx-Statuscodes ausgespielt. Außerdem werden diese Seiten mit einer Zahl zwischen 0 und 10 versehen, die eine tool-eigene Ranking-Metrik darstellt. Dieser sogenannte Deep Rank gibt an, wie relevant diese URL im Verhältnis zu den anderen auf der gesamten Domain ist. Hier lässt sich also mithilfe des DeepRank priorisieren, welche „Baustellen“ zuerst angegangen werden sollten.

Neben den vielen Funktionen, auf die man über einen Account bei DeepCrawl zugreifen kann, bietet die Website von DeepCrawl in einem Guide ausführliche Erklärungen zu den verschiedenen Einstellungen und Features im Tool. So finden neue User einen guten Einstieg mit vielen Tipps, wenn man keine persönliche Einführung hat, so wie wir ;-). Hier werden auch regelmäßig Tipps zu den einzelnen Funktionen gegeben. Dies ist im Gesamten sehr hilfreich, da die vielen unterschiedlichen Features des Tools für jemanden, der sich mit SEO Tools noch nicht ganz so gut auskennt, etwas erschlagend wirken können.

Unser Fazit

Mit DeepCrawl lassen sich ganz klar fortgeschrittene OnPage-Analysen durchführen, da man alle wichtigen Faktoren in den unterschiedlichen Report-Teilen ausführlich untersuchen kann. SEO-Fortgeschrittene können sich bei DeepCrawl also austoben. Aber auch für Einsteiger ist das Tool sehr nützlich, auch wenn man vielleicht ein bisschen Zeit braucht, um sich hinein zu fuchsen! Benutzersprache des Tools ist Englisch. DeepCrawl bietet, wie andere Tools auch, einen guten Gesamtüberblick über die OnPage-Situation einer Website. Eine besonderes Feature ist die tool-eigene Ranking-Metrik, der DeepRank. Uns hat DeepCrawl auf jeden Fall sehr gut gefallen, wir können es nur weiterempfehlen.

5 Antworten

Welcher weitere Nutzen gegenüber anderen Tools soll diese Tool letztendlich liefern. Mir scheint als ob es doch schon genug SEO Tools mit erweitertem Nutzenumfang gibt, die dieselben OnPage Analyse Funktionen bieten. Wäre mir das Geld nicht wert.

Hallo Vitalis!

Das besondere an DeepCrawl ist die tool-interne Ranking-Metrik, die dir zeigt, wie wichtig jede URL für die gesamte Domain ist. Das hat, denke ich, nicht jedes OnPage Tool. Hinzu kommen die sehr optisch sehr schön aufbereiteten Reportings, die eigens gebrandet werden können. Natürlich muss jeder selber entscheiden, wie viel Geld er für kostenpflichtige Tools aufwenden möchte!

Hallo Sandra,

danke für diesen umfangreichen Beitrag. Ich interessiere mich schon seit Längerem für SEO unddachte es gibt nichts mehr Neues. Besonders interessant finde ich die eigene Ranking-Metrik, die mit dieem Tool möglich ist. Hat mir wirklich sehr weitergeholfen.

Liebe Grüße, Stefan

Hallo Stefan!

Gern geschehen! Ja, der DeepRank ist sehr interessant! Viel Spaß mit DeepCrawl, wenn du es jetzt häufiger nutzt!