Auf GitHub wurde zwischen März und Mai dieses Jahres eine über 2500-Seiten lange Dokumentation von Google gefunden. In diesem Monatsrückblick tragen wir die interessantesten Beobachtungen von bekannten SEOs zusammen, die erste Blicke auf das geleakte Dokument geworfen haben.

Was sie herausgefunden haben, erfahrt ihr hier. Viel Spaß beim Lesen!

Google API Dokumentations Leak

#1 Googles API Dokumentation wurde geleakt

Eine anonyme Quelle hat sich an Rand Fishkin gewandt und Dokumente der Google Search API mit ihm geteilt. Diese Leaks stehen inhaltlich im direkten Widerspruch zu einigen öffentlichen Statements von Google, beispielsweise was die Bedeutung von Klicksignalen und das Alter einer Domain angeht. Die geleakte Dokumentation umfasst 2500 Seiten, welche 14.014 Attribute enthalten. Bei den Attributen handelt es sich um messbare Merkmale, die Google als bestimmte Werte speichert. Sie sind dafür da, um Objekte näher zu beschreiben. Ist das Objekt ein Mensch, könnten seine Attribute der Name, die Adresse oder eine ID-Nummer sein.

Die Dokumentation soll aus Googles Content API Warehouse stammen und versehentlich auf GitHub hochgeladen worden sein. Es handelt sich um eine umfassende Aufzählung der Daten, die Google sammelt. Welche Faktoren ins Ranking einfließen und wie sie gewichtet werden, ist jedoch nicht bekannt.

Fishkin hat Rücksprache mit drei Google Mitarbeiter:innen gehalten. Einer von ihnen hat sich enthalten. Die beiden anderen scheinen den ersten Eindruck zu bestätigen. Die Leaks sehen authentisch aus. Es ist jedoch unklar, welche der API-Attribute und -Module derzeit aktuell sind, wobei das jüngste Datum im Dokument August 2023 ist. Informationen zur AI-Suche oder AIO kommen jedenfalls nicht in der Dokumentation vor.

Rand Fishkin hat fünf wesentliche Entdeckungen aus der Dokumentation hervorgehoben:

- Glue und Navboost: Wahrscheinlich die wichtigsten Erkenntnisse des Leaks. Im nächsten Abschnitt wird noch etwas näher auf das Thema eingegangen.

- Google Clickstreams: Google nutzt Chrome Clickstreams, um die eigene Suche zu verbessern. Anscheinend werden Sitelinks basierend auf Chromes Klickdaten bestimmt, um die interessantesten und beliebtesten URLs zu identifizieren, was Einfluss auf die Sitelinks hat.

- Whitelists: Die Dokumentation bestätigt, dass Google zu bestimmten Themen wie Covid-19 oder Politik bestimmte Seiten bevorzugt, um Fehlinformationen zu vermeiden.

- Berücksichtigung des Quality Rater Feedbacks: Daten und Scores von Quality Ratern werden aktiv von einem Modul in Googles Suche berücksichtigt. Es ist unklar, ob dieses Modul nicht auch zu Testzwecken verwendet wird.

- Klickdaten zur Bewertung von Links: Es gibt eine Hierarchie, wie Links bewertet werden (niedrig, mittel und hochwertig). Klicks bestimmen den Qualitätsindex der jeweiligen Links, wobei niedrig bewertete Links vom Algorithmus komplett ignoriert werden.

#2 Glue und NavBoost

Da NavBoost ein sehr wichtiger Aspekt des Leaks ist, sollte noch etwas näher auf ihn eingegangen werden. Es handelt sich hierbei um einen Ranking-Algorithmus. NavBoost speichert Informationen vergangener Klicks der letzten 13 Monate, die für bestimmte Suchanfragen ausgeführt wurden. Dabei werden Klickrate, Nutzer:innen-Verhalten, Website-Qualität, Relevanz und thematische Kontexte berücksichtigt.

Bei „Glue“ handelt es sich um eine andere Bezeichnung für NavBoost. Der Kontext, in denen die Bezeichnungen verwendet werden, ist jedoch unterschiedlich. NavBoost konzentriert sich auf Web-Ergebnisse. Glue hingegen deckt alles auf der Seite ab, was kein Web-Ergebnis ist. Der Core-Algorithmus ist dennoch der gleiche. Bisher waren Erkenntnisse zu NavBoost sehr unzulänglich. Der Leak bietet daher endlich mehr Informationen zu diesem Ranking-Algorithmus.

#3 Google Leak Beobachtungen von Mike King

Mike (Michael) King, der Gründer von iPullRank und SEO- bzw. Online-Marketing-Experte, befasste sich ebenfalls mit dem Leak. Am Anfang seines Artikels geht er auf die vergangenen Aussagen von Google ein und stellt diese den Erkenntnissen aus der Dokumentation gegenüber. Anschließend fasst er einige SEO-relevante Haupterkenntnisse zusammen, die er in der kurzen Zeit gefunden hat. Diese möchten wir hier zusammenfassen.

Der Leak bietet zusätzliche Einblicke in Panda. Panda bildet einen Modifizierungsfaktor, der auf den einzigartigen externen Verlinkungen („independent links“) und den Querys von NavBoost („reference queries“) basiert. Es ist also nicht nur die Quantität der einzigartigen eingehenden Links wichtig, sondern auch die Menge an erfolgreichen Klicks. Wer gut ranken möchte, muss also „mehr erfolgreiche Klicks durch eine breitere Auswahl an Suchanfragen generieren und eine größere Linkdiversität erreichen.“

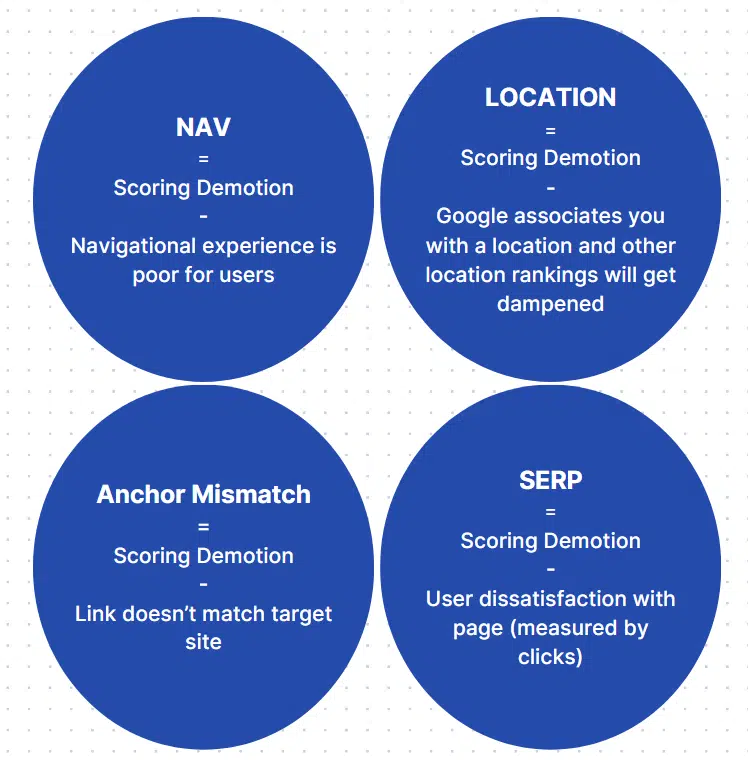

Neben Panda wurden auch einige andere Herabstufungsalgorithmen begutachtet:

• Anchor Mismatch: Der Link passt nicht mit der Zielseite zusammen.

• SERP Demotion: Interaktionen auf den SERPs deuten darauf hin, dass User:innen unzufrieden mit dem Ergebnis sind.

• Nav Demotion: Probleme mit der Navigation und der Nutzer:innen-Erfahrung (UX) einer Seite.

• Exact Match Domains Demotion: Domains, deren URLs exakt mit einem Keyword übereinstimmen.

• Product Review Demotion: Keine genaueren Informationen.

• Location Demotions: Globale und super globale Seiten können im Ranking herabgestuft werden. Möglicherweise versucht der Google-Algorithmus, Websites mit bestimmten Standorten zu verbinden.

• Porn Demotions: Herabstufung von pornografischen Inhalten.

Es gibt auch einige Erkenntnisse zum Umgang mit Links. Da es aber keine Scores gibt, ist nicht sicher, welches Gewicht diese Attribute tragen. Wie bereits besprochen, hat die hierarchische Stellung eines Links im Linkindex einen Einfluss auf seine Bewertung. Interessant hierbei ist, dass Links von Seiten, die als „fresh“, also neuartig, gekennzeichnet sind, automatisch eine höhere hierarchische Stellung im Linkindex genießen.

Es gibt mehrere Attribute zur Erkennung von Spam-Link-Texten, die Linktexte werden mit ihrem Verbreitungszeitraum in Relation gesetzt. Zudem ist zum Thema Links noch interessant zu wissen, dass Google bei der Analyse von Links nur die letzten 20 indexierten Versionen einer Seite verwendet. Ähnlich wie die Wayback-Machine speichert Google alle Versionen einer Seite, die jemals indexiert wurden. Da vom Algorithmus nur die letzten 20 indexierten Änderungen einer Seite berücksichtigt werden, bedeutet es, dass im Rückkehrschluss eine Änderung erst nach 20 Änderungen nicht mehr ins Rankingsystem mit einfließt.

Wie der Link visuell dargestellt wird, wird ebenfalls beachtet. Die Größe einer Schriftart und ob sie fett gedruckt ist, sind zwei Merkmale, die von Google beachtet werden.

Ein bereits bekannter Algorithmus von Google ist der PageRank, welcher Seiten nach ihrem Backlinkprofil beurteilt. Der „Homepage-PageRank“ (PageRank der Startseite) beeinflusst alle Seiten, besonders neue Seiten, die noch keine Authority aufbauen konnten.

Zu Content-Themen gab es folgende Beobachtungen: Es gibt eine maximale Token-Anzahl beim Einlesen von Dokumenten. Wird diese überschritten, fließt die restliche Information nicht in die Bewertung mit ein. Wichtige Informationen sollten also oben stehen. Seiten mit quantitativ wenig Inhalt werden zusätzlich auch nach Originalität bewertet. Titles, die besser zur Suchanfrage passen, werden ebenfalls besser bewertet.

Es gibt keine Attribute, die die Zeichenanzahl von bestimmten Objekten wie Titeln oder Snippets zählen. Das kann bedeuten, dass die Zeichenanzahl sich nicht auf die Rankings auswirkt. Ein großer Fokus liegt auf der Aktualität von Dokumenten. Daher wird das Datum einer Seite auf verschiedene Weisen festgestellt – über den Inhalt, die URL oder den Titel. Erstellungs- und Ablaufdaten von Domains werden ebenfalls gespeichert.

Bestimmte Seitentypen werden anders gehandhabt als üblich, insbesondere YMYL-Seiten (Your Money or Your Life) und Video-Seiten. Diese Seiten haben spezifische Classifier für ihre Seitentypen. Wie genau die Bewertung der Seiten aussieht, ist jedoch noch unbekannt.

#4 Weitere Leak Informationen von Andrew Ansley

Auch Andrew Ansley, SEO- und AI-Experte und Autor für SearchEngineLand, hat sich die Dokumentation angesehen und konnte neben den Beobachtungen, die Mike King gemacht hat, zusätzliche Informationen feststellen.

Google verfügt über eine Metrik namens PageQuality (PQ). Wie der Name bereits andeutet, bestimmt diese Metrik die „Qualität“ von Artikeln. Dazu wird ein eigenes Sprachmodell verwendet.

Zudem wurden mehrere Attribute zu den Themen Topic Borders and Topic Authority gefunden:

• siteFocusScore: Fokus eines bestimmten Themas auf einer Website

• siteRadius: Messung von Abweichungen zwischen Seiten-Einbettungen und Website-Einbettung. Google erstellt ein thematisches Profil für eine Website, und jede Seite wird mit dem Profil abgeglichen

• siteEmbeddings: komprimierte Website-/Seiten-Einbettungen.

Die Bewertung von Google wird zudem auf verschiedene Segmente aufgeteilt. Es war bereits bekannt, dass zur Bewertung einer Website viele Faktoren gehören: Themengenauigkeit, interne Links, verweisende Domains, Klicks etc. Diese Faktoren werden segmentiert. Sollte der normalisierte Seitenrang für ein Segment fehlen, werden die vorhandenen Bewertungen dazu verwendet, um das fehlende Segment zu bewerten. Das bedeutet, dass das Fehlen eines Faktors sich negativ auf die gesamte SEO-Performance auswirken kann, da sie den Durchschnitt der Gesamt-Bewertungen oder die Themenrelevanz senken. Sinkt der Durchschnitt, wirkt es sich negativ auf das Ranking aus.

Spam ist ein weiteres Thema, mit dem Andrew Ansley sich befasst hat. In seinem Artikel hat er eine Reihe von Scores aufgezählt:

• gibberishScores: Englisch für Unsinns-Wert. Hier werden gedrehter Inhalt, Füllinhalte von KI und unsinnige Texte ermittelt und bewertet.

• phraseAnchorSpamPenalty: Das Attribut ist eine Kombination von Spamerkennung und Herabstufung und befasst sich speziell mit Ankertexten.

• trendSpam: Erkennung von Manipulation der Klickrate (CTR)

• keywordStuffingScore: Bewertung für Keyword-Stuffing

• spamBrainTotalDocSpamScore: Spam-Bewertung von SpamBrain. Dem Inhalt wird ein Score zwischen 0 bis 1 gegeben.

• spamRank: Messung der Wahrscheinlichkeit, dass ein Dokument auf bekannte Spammer verweist. Der Wert liegt entweder bei 0 oder 65535. Warum es gerade diese beiden Zahlen sind, weiß keiner (außer die Mitarbeiter:innen von Google).

• spamWordScore: Zählung aller Wörter, die vom Algorithmus als „spammy“ angesehen werden.

Dank des Leaks ist es offiziell, dass Trust eine besondere Stellung hat. trustedTarget ist eine Metrik, die Inhalte nach Trust bewerten. Domains, die als vertrauenswürdig eingestuft werden, werden nachsichtiger behandelt und dürfen sich deshalb mehr erlauben.

Google-News

#1 Reddit Snippet kommt

Dass Reddit von Google bevorzugt wird, haben wir schon im Monatsrückblick vom Februar geklärt. Momentan testet Google Snippets, die speziell auf Reddit ausgerichtet sind. Anstelle der einfachen Auflistung von Threads wird nun auch die Anzahl der Bewertungen und Kommentare angezeigt.

Sie sehen gerade einen Platzhalterinhalt von Standard. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf den Button unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Weitere Informationen#2 Neuer Web Filter

Google hat einen neuen Filter veröffentlicht, mit dem Suchergebnisse auf Textlinks beschränkt werden können. Dieser Filter erscheint oberhalb der Suchergebnisse, auf dem Desktop ist er unter „mehr“ zu finden. Es handelt sich um eine nützliche Möglichkeit, die Suchergebnisse übersichtlicher zu machen. Eine Möglichkeit, warum dieser Filter eingebaut worden sein könnte, ist die Unzufriedenheit mit den teilweise minderwertigen AI-Overviews-Antworten.

Google Veranstaltungen

#1 Google I/O

Der Mai ist der Monat der Google News! Sowohl die Google I/O als auch das Google Marketing Live (GML) fanden in diesem Monat statt.

Dieses Jahr drehte sich alles auf der Google I/O um das Thema Künstliche Intelligenz (KI). Natürlich ging es hauptsächlich um Gemini, dessen Kontextfenster auf 2 Millionen Tokens erweitert wurde. Es wurden verschiedene Anwendungsfälle für den Alltag präsentiert. Darüber hinaus wurden die AI-Overviews, früher bekannt als SGE, veröffentlicht. Und noch vieles mehr:

Sie sehen gerade einen Platzhalterinhalt von Youtube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr Informationen#2 Google Marketing Live

Auch auf der GML stand die Künstliche Intelligenz im Mittelpunkt. Es gibt neue Anwendungsfälle für die Nutzung von KI im Ads-Umfeld.

Beispielsweise gab es ein AI-Upgrade für Performance Max Campaigns, das die Erstellung massenhafter AI-Assets ermöglicht. Zudem gibt es AI-gestützte Shopping-Anzeigen, die neue Darstellungsmöglichkeiten bieten. Produkte können in einer 3D-Ansicht dargestellt werden. Im Textil-Bereich ist die Darstellung von Produkten an verschiedenen Körpertypen möglich. Google beginnt auch mit dem Testen von Anzeigen in AI-Übersichten.

Hier ist die Zusammenfassung von Google:

Sie sehen gerade einen Platzhalterinhalt von Youtube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenOnline Marketing News

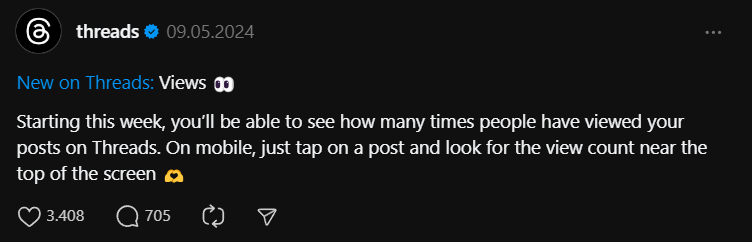

#1 View Count für Threads

Auf der neuesten Social-Media-Plattform von Meta, Threads, ist es nun möglich, die View Counts für Posts einzusehen, also die Anzahl der Nutzer:innen, die einen Beitrag gesehen haben. Bereits Ende 2023 konnten einige Creator:innen auf diese zugreifen. Nun sollen sie für alle mobilen Nutzer:innen sichtbar werden. Vor allem Creator:innen und Unternehmen werden von diesem Feature profitieren. Diese Seite erhofft sich dabei eine möglichst umfassende Darstellung der Informationen. Die Nutzer:innen hingegen sind weniger überzeugt. So wird kritisiert, wie sehr die Performance im Fokus heutiger Social-Media-Plattformen steht. Ein Argument, das im Hinblick auf den Suchtfaktor solcher Seiten relevant ist. Derzeit arbeitet Meta an weiteren Features für Threads. Darunter die Verwaltung von Post-Zitaten, die Möglichkeit, Inhalte auszublenden und Werbemöglichkeiten.

Instagram News

#1 Instagram rät von langen Reels ab

Während sich TikTok an längeren Formaten versucht, bestätigt Instagram-CEO Adam Mosseri, dass die Plattform ihren kurzen Videos treu bleiben wird. Obwohl Reels bis zu 10 Minuten lang sein können, sind die der meisten Nutzer:innen nicht länger als 90 Sekunden. Wohl auch deshalb rät Instagram von längeren Inhalten ab.

Kurzen Videos werden einige Vorteile zugeschrieben. Sie passen zur heutigen schnelllebigen Gesellschaft und sollen zu einer höheren Reichweite beitragen. Weiterhin unterstützen sie die schnelle Bedürfnisbefriedigung von Nutzer:innen und halten ihre Aufmerksamkeit einfacher. Letzteres führe zu einer hohen Engagement Rate. Nutzer:innen kommentierten zudem, dass das Einfügen von Werbung in kürzere Videos einfacher sei. Aufgrund der zeitlichen Begrenzung würde Werbung das Nutzer:innen-Erlebnis nicht beeinträchtigen. Längere Videos hingegen würden durch Werbung unterbrochen, so die Argumentation.

#2 Verpflichtende Werbeunterbrechungen

Wie nutzerfreundlich Instagram in Zukunft wahrgenommen wird, bleibt abzuwarten. Denn auf der Social-Media-Plattform sollen verpflichtende Werbepausen eingeführt werden. Diese Werbepausen werden in Form von als „Ad Break“ gekennzeichneten Posts ausgespielt und sollen das gewohnte Scrollen unterbrechen. Die Nutzer:innen werden also zu einer Pause gezwungen, während der Spot läuft. Derzeit befindet sich diese Idee noch in der Testphase und es ist unklar, wie viele Menschen in welchen Ländern auf die neuen Anzeigen gestoßen sind.

Eine Schlussfolgerung kann jedoch bereits gezogen werden. Eine überwiegende Mehrheit der Nutzer:innen reagiert negativ auf das neue Format. Sie sind der Meinung, dass Werbung bereits jetzt einen großen Teil der Nutzer:innen-Erfahrung ausmacht. Eine Nutzerin zeigt sich generell offen für Werbung auf Instagram, berichtet aber, dass sie die App sofort schließe, sobald sie auf Werbung stoße, die sie am Scrollen hindere. Es bleibt abzuwarten, welche Schlüsse Instagram daraus zieht und ob die neue Art der Werbeunterbrechung auf der Website beibehalten wird.

Sie sehen gerade einen Platzhalterinhalt von Standard. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf den Button unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Weitere Informationen#3 Aktuelle Updates: Memes für Reels und Banner für Ads

Instagram hat kürzlich ein Update mit neuen Funktionen für Reels und Profile veröffentlicht. Zukünftig sollen Nutzer:innen verschiedene bekannte Memes als ausgeschnittene Figuren in ihre Reels einfügen können. Diese Memes werden nicht nur optisch eingebunden, sondern sind auch mit passenden Sounds unterlegt. Derzeit steht diese Funktion testweise nur Android-Nutzer:innen der Beta-Version zur Verfügung. Es ist noch unklar, wann das Feature für alle Nutzer:innen bereitgestellt wird.

Das neue Banner-Feature ermöglicht die prominente Bewerbung von Produkten, Launches und Channels auf Unternehmensprofilen. Aber auch für reguläre Nutzer:innen sind die Banner interessant, wenn auch in limitierter Form. So können beispielsweise Spendenaktionen und geplante Live-Videos beworben werden.

Das Einbinden der Banner ist in beliebiger Anzahl und Reihenfolge möglich.

#3 Google hält zu AI-Overviews, trotz heftiger Kritik

Bereits im Monatsrückblick für den April berichteten wir euch von Googles neuem AI-Overviews Feature.

Google zeigt sich zuversichtlich, dass die Einführung von KI in der Suche diese positiv beeinflussen wird, so auch die neue Funktion AI-Overviews. Mitte Mai wurde sie offiziell in den USA eingeführt. Nun soll die Veröffentlichung in weiteren Ländern geplant sein. Ob auch Deutschland darunter sein wird, ist noch unklar. Ziel ist es, das Feature bis zum Jahresende für mehr als eine Milliarde Nutzer:innen zugänglich zu machen.

Die Anzeige von Informationen direkt in den Suchergebnissen ist nicht neu und erinnert an die bereits bekannten Featured Snippets. Wie dort stammen die Inhalte in der Regel von anderen Websites. Dies kann jedoch zu Traffic-Verlusten für diese Drittanbieter führen. Website-Betreiber:innen sollen zwar die Möglichkeit haben, selbst zu entscheiden, ob Google ihre Informationen direkt in den Suchergebnissen anzeigen darf, doch hat sich Google in der Vergangenheit nicht immer an diese Abmachungen gehalten. Entsprechend kritisch stehen die Publisher:innen dem Feature gegenüber.

Und auch für Werbetreibende und Google selbst kann das Feature Probleme mit sich bringen. Das Kerngeschäft von Google bestand bisher darin, Nutzer:innen auf Shops und Websites von zahlenden Werbetreibenden weiterzuleiten. Erhalten Nutzer:innen ihre Antworten bereits in den SERPs, ist die Wahrscheinlichkeit geringer, dass sie auf deren Anzeigen klicken. Auf der „Google Marketing Live“ kündigte Google jedoch an, künftig auch Anzeigen in KI-Overviews auszuspielen. Ob die Nutzer:innen mit diesen aber genau so gut interagieren wie bisher, bleibt abzuwarten.

Nicht zuletzt kritisieren Nutzer:innen AI-Overviews auch, da sie das Gefühl haben, dass Google ihnen dieses neue Feature aufzwingt und die Qualität der KI-Antworten oft zu wünschen übriglässt. Mehr dazu in unseren Tipps des Monats.

#4 Analytics-Daten für TikTok Studio

TikTok hat Ende Mai seine neue Creator-Plattform TikTok Studio gelauncht, die einen besonderen Fokus auf die Erstellung, Optimierung und Analyse von Inhalten legt. Alle Nutzer:innen ab 18 Jahren sollen nun in der Lage sein, ihren Account und dessen Performance unter anderem hinsichtlich des Publikumsverhaltens zu analysieren. Außerdem soll über TikTok Studio direkt auf die Creator Academy zugegriffen werden können, die Informationen beispielsweise zur Monetarisierung von Inhalten bereitstellt.

TikTok Studio ist in der TikTok App, im Web und sogar als eigenständige App verfügbar. Die verschiedenen Versionen bieten jedoch unterschiedliche Tools.

Auf TikTok Studio sollen auch weitere Funktionen für Werbetreibende eingeführt werden. Diese wurden auf dem TikTok World Product Summit vorgestellt.

Sie sehen gerade einen Platzhalterinhalt von Standard. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf den Button unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Weitere InformationenTipps des Monats

#1 Kognitive Verzerrungen und SEO

Durch die vielen Google-Updates sowie die zunehmenden AI-Features in der Suche wird es für SEOs zunehmend schwieriger, Google zu verstehen. Garrett Sussman von MOZ empfiehlt daher, sich stärker auf das Verstehen der eigenen Zielgruppe zu konzentrieren. Er argumentiert, dass Suchanfragen die Persönlichkeiten und Merkmale der Nutzer:innen widerspiegeln. Um die Suchanfragen der Zielgruppe besser zu verstehen, ist es hilfreich, sich mit kognitiven Verzerrungen auseinanderzusetzen. Diese Verzerrungen entstehen, weil das Gehirn schnelle Lösungen für stressige Situationen sucht, was zu inkorrekten Beurteilungen führt und hinsichtlich der Google-Suche beeinflusst, welche Anfragen Nutzer:innen stellen und auswählen.

Folgende kognitive Verzerrungen sind besonders relevant:

• Confirmation Bias: Nutzer:innen bevorzugen Informationen, die ihre bestehenden Überzeugungen bestätigen. Weiterhin suchen Nutzer:innen oft nach Keywords, die bereits geformte Annahmen über und Erfahrungen mit einem Thema beinhalten.

• Search Engine Bias: Die obersten Suchergebnisse werden als glaubwürdiger angesehen, auch wenn sie möglicherweise durch die Ansichten der Content Creator:innen verzerrt sind.

• Salience Bias: Auffällige Inhalte, ob visuell oder emotional, ziehen mehr Aufmerksamkeit auf sich.

• Authority Bias: Ergebnisse von autoritären Quellen werden bevorzugt. Websites, die sich nachweislich besonders gut mit einem Thema auskennen,, haben meistens Vorteile im Ranking.

• Familiarity Bias: Nutzer:innen bevorzugen bekannte Creator:innen und Websites.

Sussman gibt Tipps zur praktischen Umsetzung dieses Wissens. Unter anderem kritisiert er die übliche Praxis, sich auf häufig gesuchte Keywords zu konzentrieren, und empfiehlt stattdessen, die Sprache und Denkweise der Zielgruppe zu untersuchen und entsprechende Keywords zu wählen.

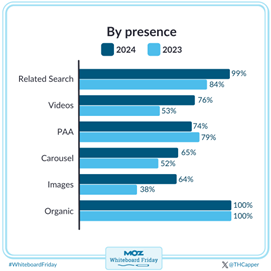

#2 Top SERP-Features 2024

Tom Capper von MOZ stellt in seinem Artikel die häufigsten SERP-Features vor. Dazu sammelt er Daten aus den ersten beiden Januarwochen. Außerdem vergleicht er diese mit Erhebungen aus dem letzten Jahr.

Recht häufig tritt das Related Seach Feature auf, eine Liste mit Vorschlägen für ähnliche Suchanfragen. Sie wurde in 99 Prozent der untersuchten SERPs gefunden. Den zweiten Platz belegen Videos. Während diese 2023 noch eher Desktop Nutzer:innen ausgespielt wurden, sind sie 2024 eher auf Mobilgeräten zu sehen. Capper vermutet hier einen Einfluss durch die Popularität von TikTok. People also Ask wird zwar nicht am seltensten ausgespielt, aber Capper hält dieses Feature für wenig relevant. Er bezweifelt, dass SEOs dadurch mehr Traffic generieren können.

Des Weiteren wurde die Häufigkeit der SERP-Features auch in Bezug auf den Share of Voice untersucht. Was es damit auf sich hat, erfahrt ihr bei MOZ.

#3 CMS bezüglich den Core Web Vitals im Vergleich

Die Core Web Vitals haben sich im April 2024 bei fast allen gängigen CMS verschlechtert, mit einer Ausnahme. Roger Montti zeigt in seinem Artikel anhand des Berichts von HTTPArchive, woran das liegen könnte. Das System mit der besten Performance ist mit 13 Prozentpunkten Vorsprung Duda. Den zweiten Platz belegt SquaresSpace. Das Schlusslicht bildet WordPress. Im Vergleich zu den anderen CMS ist seine Performance jedoch weniger stark zurückgegangen. Grund dafür könnten die zahlreichen Performance-Verbesserungen sein, die mit der neuen Version im April eingeführt wurden.

Der Grund für die generelle Verschlechterung könnte die Einführung von INP (Interaction ton ext Paint) sein. INP misst die Reaktionsgeschwindigkeit einer Website während des gesamten Besuchs und ist wesentlich umfassender als sein Vorgänger FID. Dieser bezog sich nur auf die erste Interaktion mit einer Website. (Mehr dazu im Monatsrückblick aus Mai 2023)

#4 Fehlerhafte Angaben in den AI-Overviews

In den Online Marketing News sprachen wir es bereits an: Die AI-Overviews von Google konnten unter anderem auch Nutzer:innen bisher nicht überzeugen. Grund dafür sind mitunter auch die zahlreichen Fehlinformationen, die in letzter Zeit von dem Feature ausgegeben wurden. Barry Schwartz von Search Round Table hat es sich zur Aufgabe gemacht, diese zu sammeln.

Hier seht ihr einige Beispiele:

• Sucht ihr nach einem Job für euren Papagei? Hier sind ein paar Vorschläge: Die Tiere können laut AI-Overviews beispielsweise als Architekten, Verhaltenspsychologen oder Gefängnisinsassen beschäftigt werden.

• Wenn ihr wissen wollt, wie ihr verhindert, dass Käse nicht von eurer Pizza fällt, hat AI-Overviews ebenfalls eine passende Lösung parat: Befestigt ihn einfach mit Kleber!

• Von allen US-Präsidenten, die die UW-Madison besucht haben, ist Andrew Johnson der beeindruckendste: Laut der KI hat der ganze 14 Abschlüsse erlangt!

Diese Beispiele sind relativ ungefährlich. Doch auch bei ernsten medizinischen Fragen gab die KI in der Vergangenheit Fehlinformationen an. Diese können gravierende Folgen haben. Es bleibt abzuwarten, inwieweit solche Fehler in Zukunft vermieden werden.

Sie sehen gerade einen Platzhalterinhalt von Standard. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf den Button unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Weitere InformationenDanke, dass ihr bis hier gelesen habt. Wenn euch dieser Beitrag gefallen hat, wirft bitte einen blick auf unser Geburtstagsgewinnspiel! Heute ist die letzte Chance einen Kommentar zu hinterlassen!

Ein schönes Wochenende wünschen euch Désirée und Laura!

Eine Antwort

Der Google-Leak enthüllt wichtige SEO-Faktoren wie Markenreputation, Backlink-Qualität, Nutzerverhalten und Content-Originalität.

Experten wie Mike King und Andrew Ansley analysierten die geleakten Dokumente und fanden Hinweise auf die Bedeutung von Klickdaten, Abstrafungsalgorithmen, Linkbewertung und Spam-Scores.

Der Leak bestätigt bekannte Rankingfaktoren, gibt aber auch neue Einblicke in die Funktionsweise des Google-Algorithmus.

SEOs können diese Erkenntnisse nutzen, um ihre Strategien zu optimieren und bessere Rankings zu erzielen.

Vielen Dank, sehr interessant.