Als Tim Berners-Lee 2001 vom „semantic Web“ sprach, hat er die Zukunft des Internet zunächst vage und erst im Laufe der Zeit zunehmend konkreter beschrieben. Durchaus visionär sind seine Vorstellungen von einer im WWW aggregierten Datenmenge, die auf ihrer Bedeutungsebene nicht nur von Menschen, sondern auch von Maschinen interpretierbar sein soll. Gute zehn Jahre später hat die Vision alles utopische abgelegt: die maschinelle Verarbeitung semantischer Informationen schreitet schnell voran.

Sucht man jetzt bei Google nach Schauspielern, die im St. Pauli Theater auftreten, erhält man die nötigen Informationen über Umwege aus vielen verschiedenen Quellen. Das liegt daran, dass das traditionelle WWW ein Netzwerk aus miteinander verbundenen Dokumenten ist. Gibt es kein Dokument, was sich explizit mit „Schauspieler im St. Pauli Theater“ beschäftigt, kann es auch nicht ausgegeben werden.

Wenn nun nicht Dokumente, sondern semantisch ausgezeichnete Daten miteinander verbunden wären, würde das die Möglichkeiten der Suchergebnisse ins schier Unbegrenzte katapultieren. Auf eine Anfrage wie „alle Schauspieler des St. Pauli Theaters mit Tanzausbildung“ könnten die nötigen Daten aggregiert und angezeigt werden, auch ohne dass ein entsprechendes Dokument existieren würde.

Ziel des semantischen Webs ist es deshalb, einen einheitlichen, globalen Datenraum (Linked Data) zu erschaffen, auf den jeder Zugriff hat und über Anwendungen für sich nutzen könnte. Aber wie soll das funktionieren, was bedeutet das für SEO und was lässt sich sonst noch mit den „richtigen“ Daten anstellen?

Die Technik der SERP-Semantik

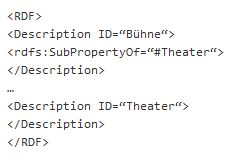

Um die Bedeutung von Daten und ihre Zusammenhänge untereinander eindeutig repräsentieren zu können, müssen sie beschrieben werden. Einfache Zusammenhänge zwischen Objekten lassen sich mithilfe des Ressource Description Frameworks (RDF) festlegen, das auf der Extensible Markup Language (XML) und XML Schema aufbaut. Die RDF-Variante RDFa erleichtert die Integration in XHTML, ähnlich wie Microformats.

Innerhalb von RDF werden Aussagen in Form von einem “Triple” gemacht, da sie aus drei Elementen bestehen: Subjekt, Prädikat, Objekt.

Nehmen wir als Beispiel das Theater als Subjekt, das unter anderem dadurch ausgezeichnet wird, dass es eine Bühne hat:

Subjekt: Theater (x)

Objekt: Bühne (y)

Prädikat: hat einen Teil (D)

Damit lässt sich die Aussage machen:

D(x,y)

Dieser Zusammenhang kann als RDF/XML-Code modelliert werden:

Für SEOs dürfte RDF keine neue Nummer sein: Auszeichnungen mit RDFa tauchen in den Rich Snippets auf. Dazu sollte man sich am besten den Standards von schema.org oder an GoodRelations für E-commerce halten. Unkomplizierte Auszeichnungen wie Preise, Verfügbarkeit, Versandoptionen und Bilder lassen sich äußerst einfach in den eigenen Quellcode integrieren: Mit dem Rich Snippet Generator können sogar Code-Fragmente im W3C-RDFa-Format generiert werden, die sich dann per Copy-and-Paste in die eigene Webseite einbetten lassen.

Der Knowledge Graph von Google zieht sich die nötigen Daten unter anderem über eine semantische Datenbank, bzw. einer Graphendatenbank. Mitte 2012 umfasste diese 500 Millionen Einheiten mit mehr als 3,5 Billionen Beziehungen untereinander, die u. a. über RDF definiert werden. Diese Graphendatenbank wird auch über den normalen Crawling-Prozess befüllt – ein wichtiges Detail, denn bedient man den Crawler mit strukturierten Daten, werden diese unter Umständen auch prominent ausgegeben. Zur Zeit beschränkt sich der Knowledge Graph auf die englische Sprache, aber auch in den deutschen SERPs werden Produkte, Bewertungen und Personen in der RDFa-Serialisierung schon jetzt zur besseren Strukturierung der Suchergebnisse herangezogen.

Google unterstützt zwar auch Microformats, sollen allerdings spezielle Informationen beschrieben werden, die über Kontaktdaten und Termine etc. hinausgehen, dann führt kein Weg an RDFa vorbei. RDFa erlaubt maximale Flexibilität, da eigene Vokabularien definiert werden können. Und am wichtigsten: Daten, die mit RDFa beschrieben sind, haben das Potenzial, für viele Anwendungen genutzt werden zu können.

Das Potenzial der Daten: Mashups²

Das Potenzial der Daten lässt sich zum jetzigen Zeitpunkt am besten an Mashups zeigen.

Ein Mashup ist eine Webapplikation oder eine Website, die bestehende Inhalte von zwei oder mehreren externen Online-Angeboten kombiniert und in einer neuen Anwendung integriert. So werden Inhalte und Daten unterschiedlichster Webservices auf neue Art und Weise präsentiert.

Wenn nicht über offizielle Programmierschnittstellen (APIs) auf Daten zugegriffen werden kann, können Daten auch gezielt von Seiten extrahiert werden (Screen Scraping), oder aber über Feeds angezapft werden.

Popurls.com ist so ein Mashup: aus vielen verschiedenen Informationsquellen (Reddit, Huffington Post, Google News, Hacker News etc.) erstellt Popurls.com ein sehr angenehmes Dashboard, das auf einem Blick die wichtigsten Inhalte aus dem Web anzeigt.

Popurls.com ist so ein Mashup: aus vielen verschiedenen Informationsquellen (Reddit, Huffington Post, Google News, Hacker News etc.) erstellt Popurls.com ein sehr angenehmes Dashboard, das auf einem Blick die wichtigsten Inhalte aus dem Web anzeigt.

Amazon macht auch einige Daten durch den Amazon E-Commerce Service öffentlich zugänglich, so dass Entwickler eigene Shop-Oberflächen entwickeln können. Amazon erreicht so, dass Ware über eine Vielzahl an Kanälen vertrieben wird, und im Gegenzug werden die Anbieter an den Erlösen beteiligt.

Die ZEIT ONLINE hat erst vor kurzem eine Text-API zur Verfügung gestellt, die alle Texte seit 1946 umfasst. Autor, Kategorien und Schlagworte sind zusätzlich über Metadaten ausgezeichnet worden und lassen so „örtliche oder inhaltliche Zusammenhänge, Zeitbezüge [und] Dinge sichtbar werden, die beim einfachen Lesen nicht unbedingt zutage treten.“

Im Gegensatz zu klassischen Web 2.0 Mashups sind semantische Mashups nicht durch eine vorher festgelegte Menge an Datenquellen beschränkt, sondern operieren in einem offenen Datenraum, der u. a. durch RDF als standardisiertes Datenmodell möglich gemacht wird. Gapminder.org macht sich schon jetzt große Bestände strukturierter Daten zunutze, die losgelöst von den Beschränkungen einer API in der sogenannten Linked Open Data Cloud zur Verfügung stehen.

Dieses Netzwerk an annotierten Daten ist öffentlich zugänglich und wird unter anderem von der British Broadcasting Corporation (BBC), der New York Times, The Guardian, der Deutschen Zentralbibliothek für Wirtschaftswissenschaften und data.gov unterstützt.

Ausblick

Das Internet als Medium für Datensammlungen ermöglicht schon jetzt innovative Anwendungen. In Zukunft werden Dank semantischer Auszeichnungssprachen zusätzlich völlig neuartige, datengetriebene Einsatzmöglichkeiten geschaffen.

Zwar hat das semantische Web noch einen weiten Weg vor sich und viele dringende Fragen zu beantworten, aber der Grundstein von logisch ausgezeichneten Daten über RDF ist schon lange gelegt worden. Die Vorteile sich mit dieser Entwicklung auseinander zu setzen betreffen bei weitem nicht nur SEOs, aber sie sollten auf jeden Fall ganz vorn mit dabei sein.

Mit bedeutungsvollen Grüßen

Ines und die SEO Trainees.

© Bild: iStockphoto / ThinkStock. Mit freundlicher Unterstützung von lorm.de

16 Antworten

Hi,

danke dir. Probiers gleich mal aus.

Lg Tom

Hallo,

also ich wollte euch mal fragen, ich hab auch das Google Rich Snippet eingebaut, damit neben meinem Blogartikel noch mein Bild kommt. Im Rich Snippet testing Tool sehe ich auch mein Bild, aber in den Suchresultaten bei Google seit Monaten noch die alten Infos. Was mache ich falsch?

Lg Tom

Hi Tom,

mir ist aufgefallen, dass Du unter Deinen Artikeln mit „tom“ verlinkst, nicht wie dein G+-Name „Tom Cz“. Kann das schon das Problem lösen? (https://plus.google.com/authorship) BG Ines

Hallo Ines,

danke für deine Antwort. Da wir für unsere shops nur Inhouse-SEO machen, haben wir natürlich nicht die Erfahrungen und Datensätze einer professionellen Agentur.

Das aber der Quelltext größer wird, ist unbestritten. Wenn man zum Beispiel eines Produktes den Produktnamen/ den Hersteller/ den Preis/ die Währung/ die Verfügbarkeit etc. semantisch darstellen möchte, benötigt man pro Attribut einen beginnenden und einen schließenden tag (z.B. 10). Somit hat man gerade bei Kategorieseiten mit 30 und mehr Produkten viel zusätzlichen Quelltext.

Unsere Erfahrungen im Bezug auf die Berücksichtigung bei google sind auch nur Stichproben. Wir haben einfach mal in den USA einige Produkte gegoogelt und uns jeweils für die ersten zehn Treffer den Quelltext angesehen. Das Ergebnis war ernüchternd, nur ganz wenige haben eine semantische Beschreibung. In Deutschland sind es ähnlich aus. Ob natürlich diese Seiten besser platziert wären, wenn sie semantische Angaben enthalten würden, können wir natürlich nicht beurteilen.

Somit gehen wir derzeit von einem nice-to-have aus, was in Zukunft natürlich nicht so bleiben muss und an Bedeutung gewinnen wird.

Besonders cool (ja schon fast grey-hat/ black-hat) ist die Möglichkeit, dass man mit den tags den Suchmaschinen einen anderen Inhalt vermitteln kann als dem Anwender/ Besucher. Ich denke, dass auch den Suchmaschinen das bekannt sein dürfte und deren Algorithmus diesen Mißbrauch ausschließen müsste. Und solange, das nicht sichergestellt ist, wird u.E. die Semantik noch kein wesentliches Rankingkriterium.

Im Fazit ist aber festzustellen, dass man mit der konsequenten Verwendung der Semantik die Arbeit der Suchmaschinen (irgendwann) erleichtert und dies durch bessere Platzierungen belohnt wird.

Viele Grüsse aus Flensburg

Mathias

Hallo Mathias,

deinem Fazit stimme ich gerne zu! Dieses Thema lässt mich auch überhaupt nicht mehr los (zum Glück). Ich bin auf diesen Artikel des Wall Street Journals gestoßen: http://online.wsj.com/article/SB10001424052702304459804577281842851136290.html?mod=wsj_share_goog#

Darin steht:

„One person briefed on Google’s plans said the shift to semantic search could directly impact the search results for 10% to 20% of all search queries, or tens of billions per month.“

Wie und ob die semantische Auszeichnung manipulierbar sein wird, ist natürlich auch ein wildes Spekulationsfeld! Freue mich da auf erste handfeste Analysen 😀

Beste Grüße nach Flensburg

Ines

Hallo nach Hamburg,

wirklich schöner Artikel zu denen wir zwei Anmerkungen haben.

Unseres Wisses wirkt sie die semantische Optimierung (noch) nicht auf die SERPs aus, obgleich man den Suchmaschinen durch die Verwendung (z.B. product/ price/ location etc.) der tags das Einlesen/ die Zuordnung des Inhalts erleichtert. Somit ist das derzeit nur ein nice to have.

Weiterhin vergrößert sich durch die Verwendung der Semantik der Quelltext, so dass ein ungünstigeres Inhalt/Quelltext-Verhältnis entsteht. Ob und inwieweit dies durch die Suchmaschinen (negativ/ positiv) bewertet wird, können wir leider nicht sagen, da ein entsprechendes Datenvolumen fehlt.

Aber mit Sicherheit ist man mit der Verwendung der Semantik/ Rich-Snippets gut auf das web 3.0 vorbereitet, so dass euer Artikel auf alle Fälle für eine vorausschauende SEO geeignet ist.

Viele Grüsse

Mathias

Hallo Mathias,

vielen Dank für deine Anmerkungen!

Der vergrößerte Quelltext gehört sicherlich in die Kategorie noch zu klärender Fragen. Aber eine Auszeichnung von Produkten, Preis, Ort ist meiner Meinung nach mehr als nur ein nice to have – aber vielleicht habt ihr da andere Erfahrungen gemacht?

Spannend auch, dass der Knowledge Graph sich nun auch auf die deutschen SERPs ausweitet:

http://semanticweb.com/google-knowledge-graph-picks-up-a-few-new-languages-and-shows-some-medical-smarts_b33813

http://t3n.de/news/google-knowledge-graph-430656/

Beste Grüße

Ines