Diesen Monat haben wir eine besondere Artikelserie für euch geplant: Wir werden die Webmaster Tools der Suchmaschinen Google, Bing (auch von Yahoo genutzt) und Yandex genauer unter die Lupe nehmen und euch in drei Mittwochsartikeln zeigen, welche Funktionen und Daten die drei Webmaster-Tool-Varianten für euch bereithalten. In einem vierten Artikel werden wir die Tools einander gegenüberstellen und konkret miteinander vergleichen. Los geht’s diese Woche mit dem Klassiker – den Webmaster Tools von Google. Viel Spaß beim Lesen!

Mit den Google Webmaster Tools stellt Google Webseitenbetreibern Daten und Tools zur Verfügung, um ihre Seite Google-freundlich zu strukturieren und somit erfolgreich zu ranken. Treten Probleme wie zum Beispiel Crawling-Fehler auf, wird man als Webmaster über die Tools von Google darüber in Kenntnis gesetzt und kann Abhilfe schaffen. Wie genau das funktioniert, erfahrt ihr hier. Der Vollständigkeit halber haben wir auch sämtliche Einstellungsmöglichkeiten aufgeführt. Wem das zu trocken ist, der sollte direkt mit dem Punkt „Website-Benachrichtigungen“ beginnen.

Erste Schritte

Einstellungen

Website-Benachrichtigungen

Darstellung der Suche

Suchanfragen

Google-Index

Crawling

Sicherheitsprobleme

Andere Ressourcen

Google Labs

Fazit

Erste Schritte

© Creatas/Thinkstock

Bevor es losgehen kann, muss die Website in den Webmaster Tools angelegt werden. Dazu müsst ihr euch in euren Google-Account einloggen und auf den Button „Website hinzufügen“ klicken. Es gibt verschiedene Möglichkeiten, die Inhaberschaft zu bestätigen, d.h. Google mitzuteilen, dass man tatsächlich der Webmaster der eingereichten Website ist:

- Eine von Google bereitgestellte HTML-Datei auf der eigenen Website hochladen

- Ein HTML-Tag, das in den Head-Bereich der Startseite der Website eingefügt werden muss

- Eine Verifizierung über das dazugehörige Google-Analytics-Konto

- Eine Verifizierung über den Google Tag Manager

Verfügt man bereits über ein Google-Analytics-Konto, bietet sich sicherlich die Verifizierung hierüber an. Aber auch ein HTML-Tag ist schnell und einfach in den Head-Bereich der Website eingebunden. Sowie die Inhaberschaft bestätigt ist, kann’s auch schon losgehen!

Dashboard

Klickt man auf die angelegte Website, gelangt man automatisch auf das Dashboard, wo auf einen Blick wichtige aktuelle Informationen zu finden sind. Als Erstes wird man hier darüber informiert, ob man neue Nachrichten von Google erhalten oder die Suchmaschine kritische Fehler festgestellt hat. Hat man beispielsweise in irgendeiner Weise gegen die Google Webmaster Guidelines verstoßen, wird man darüber manchmal von Google in Kenntnis gesetzt.

Außerdem werden angezeigt:

- Crawling-Fehler der letzten 90 Tage, d.h. URLs, die Google nicht crawlen konnte

- Ein Linien-Diagramm zu den Impressionen und Klicks der letzten 30 Tage

- Angaben dazu, wie viele URLs an Google übermittelt wurden und wie viele davon indexiert sind, inklusive Balkendiagramm

Auf der linken Seite des Dashboards befindet sich das Menü, rechts oben gibt es einen „Hilfe“-Button und einen Button mit einem Zahnrad, über den verschiedene Einstellungen vorgenommen werden können. Damit geht’s jetzt weiter:

Einstellungen

Webmaster-Tools-Einstellungen

- Nachrichtensprache: Legt die Sprache fest, die im Tool genutzt wird.

- E-Mail-Benachrichtigungen: Hier kann man angeben, ob man von Google Benachrichtigungen per E-Mail erhalten möchte. Dabei kann man auswählen, ob man über alle Probleme oder nur die am häufigsten auftretenden Probleme informiert werden möchte.

Website-Einstellungen

- Geografisches Ziel: Hier kann man das Land auswählen, für das die Website relevant ist. Zwar kann Google in der Regel erkennen, für welches Land eine Website relevant ist, auch wenn die Top Level Domain .net, .com oder Ähnliches ist. Dennoch ist es sinnvoll, an dieser Stelle das Land konkret anzugeben und somit einen weiteren Hinweis an Google bzgl. des geografischen Ziels zu senden.

- Bevorzugte Domain: Hier kann man festlegen, welches die bevorzugte Domain ist, z.B. diejenige mit oder ohne www. Dazu ist es natürlich notwendig, dass ihr beide Varianten als Websites anlegt, also zum Beispiel seo-trainee.de und www.seo-trainee.de. Auf diese Weise kann man Google mitteilen, dass beide Varianten zusammengehören und demselben Inhaber zuzuschreiben sind. Die als „bevorzugt“ ausgewählte Domain gibt an, welche Domain-Variante in den Suchergebnissen erscheinen soll.

- Crawling-Geschwindigkeit: Hier habt ihr die Wahl zwischen „Optimale Crawling-Geschwindigkeit von Google bestimmen lassen“ oder „Maximale Crawling-Frequenz beschränken“. Das kann sinnvoll sein, um mögliche Server-Überlastungen zu umgehen. Die Crawling-Geschwindigkeit kann sowohl auf Root- als auch auf Subdomain-Ebene geändert werden. Änderungen sind 90 Tage lang gültig. In den meisten Fällen empfiehlt es sich allerdings, die Crawling-Geschwindigkeit von Google bestimmen zu lassen.

Adressänderung

Zieht man seine Website auf eine neue Domain um, kann man das Google an dieser Stelle mitteilen. Bevor man die neue Website den Webmaster Tools hinzufügt, sollte man die Inhalte darauf einrichten und URLs von der alten Domain auf die neue per 301 weiterleiten.

Google Analytics-Property

Hier hat man die Möglichkeit, Daten aus den Webmaster Tools in Google Analytics zu aktivieren. Voraussetzung ist natürlich, dass man über ein Analytics-Konto verfügt. So können die Daten aus beiden Analyse-Tools zusammengeführt werden und man kann direkt aus dem Analytics-Konto auch Daten aus den Webmaster Tools einsehen. Mehr Informationen dazu gibt es hier.

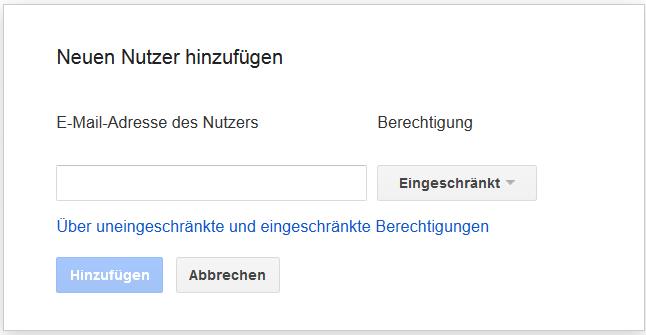

Nutzer und Website-Inhaber

Hier kann der Inhaber der Website neue Nutzer hinzufügen und ihre Berechtigung festlegen. Uneingeschränkte Nutzer können alle Daten einsehen und einen Großteil der Aktionen durchführen. Allerdings können sie keine neuen Nutzer anlegen. Eingeschränkte Nutzer können die meisten Daten einsehen und einige Aktionen durchführen, allerdings keine Einstellungen oder Ähnliches vornehmen. Das ist vor allem praktisch, wenn ihr mit einer SEO-Agentur zusammenarbeitet. Damit diese die relevanten Daten einsehen kann, legt ihr den SEO Consultant als Nutzer an und beschränkt seine Nutzungsrechte. So kann er mit den Daten arbeiten, aber keine Einstellungen verändern.

Überprüfungsdetails

Zum einen kann hier eingesehen werden, wann und mit welcher Methode der Inhaber der Website als solcher verifiziert wurde. Auch die bestätigten Inhaber sind aufgelistet und neue Inhaber können an dieser Stelle hinzugefügt werden.

Partner

Der letzte Punkt zeigt verknüpfte Nutzer an. Verknüpfte Nutzer bzw. Partner sind Personen oder Konten, die im Namen der Website handeln können. Sie verfügen aber nicht über die Möglichkeit, Website-Daten einzusehen oder Aktionen durchzuführen. Bisher werden als Beispiel für Partner nur Mitglieder des YouTube-Partnerprogramms aufgeführt, also Partner, die über einen YouTube-Kanal verfügen und diesen mit der Website verknüpfen.

Nachdem die Einstellungen vorgenommen wurden, kann es losgehen. Bei der Erklärung der weiteren Funktionen richte ich mich nach den Menüpunkten auf der linken Seite des Dashboards.

Website-Benachrichtigungen

Wie bereits erwähnt, wird man direkt im Dashboard über aktuelle Nachrichten und mögliche kritische Fehler informiert. Über den Menüpunkt „Website-Benachrichtigungen“ kommt man in eine Art Postfach, in der alle Benachrichtigungen der Website gesammelt werden. In folgenden Fällen erhält man u.a. eine Benachrichtigung von Google:

- Wenn man gegen die Google Webmaster Guidelines verstoßen und eine manuelle Abstrafung erhalten hat, z.B. weil die Website über ein unnatürliches Link-Muster verfügt oder minderwertigen Content bereitstellt.

- Zur Bestätigung von Änderungen und Aktionen, z.B. wenn man eine Änderung bezüglich der Sitelinks an Google übermittelt oder die Entfernung einer URL beantragt hat.

- Wenn auf der eigenen Website Malware gefunden wurde.

Die Webmaster Tools bieten Webseitenbetreibern eine gute Möglichkeit, auf direktem Wege mit Google zu kommunizieren. Im Falle einer Abstrafung beispielsweise kann man Google über die Webmaster Tools auf einfachem Wege mitteilen, welche Schritte man zur Behebung des Problems unternommen hat. Nicht zuletzt deshalb ist jedem Webmaster zu empfehlen, die Webmaster Tools zu nutzen!

Darstellung der Suche

Im Menüpunkt „Darstellung der Suche“ erhaltet ihr wertvolle Informationen darüber, wo Optimierungspotenzial bezüglich der Gestaltung eurer Snippets in den Suchergebnisseiten besteht. Snippet-Optimierung ist ein wichtiger Teil der OnPage-Optimierung, da attraktive Snippets die Klickrate erhöhen und somit zu mehr Besuchern und auch mehr Konversionen führen können.

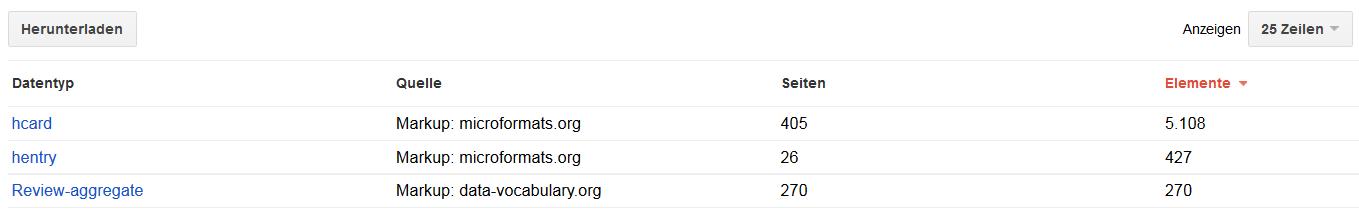

Strukturierte Daten

Mittels strukturierter Daten kann man Informationselemente bzw. Textteile auszeichnen, sodass Google besser interpretieren kann, um welche Art der Information es sich handelt. Das ist vor allem wichtig für die Erstellung von Rich Snippets, also Snippets, die mehr Informationen als lediglich Title, URL und Description enthalten. Zusätzliche Informationen können zum Beispiel Veranstaltungstermine, (Produkt-)Bewertungen, eine Breadcrumb-Navigation oder Autorenbilder sein.

Die Google Webmaster Tools bieten eine Übersicht, welche Art der strukturierten Daten wie häufig auf eurer Website verwendet werden. Diese werden nach Datentyp sortiert aufgelistet. Durch Klicken auf einen Datentyp bekommt man detailliertere Informationen darüber, auf welchen Unterseiten das Datenformat angewendet wird. Klickt man wiederum auf eine einzelne Seiten-URL, werden die genaue Details zu dieser URL angezeigt. Hier könnt ihr also ganz genau überprüfen, ob Google die strukturierten Daten wie gewünscht ausliest und weiterverarbeitet.

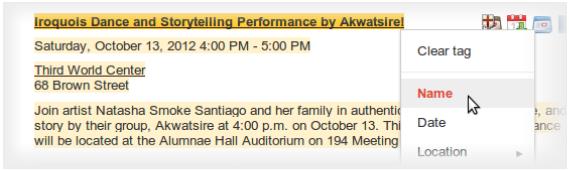

Data Highlighter

Mit dem Data Highlighter gibt es seit einiger Zeit eine weitere Möglichkeit, Daten auszuzeichnen, mit denen Google das Snippet dann aufwerten kann. Die Anwendung ist denkbar einfach: Nachdem man auf „Markieren starten“ geklickt hat, muss man folgende Informationen eingeben:

- Die URL der Seite, auf der Daten getaggt werden sollen.

- Die Art der Information, die hervorgehoben werden soll. Das kann Folgendes sein: Artikel, Buchrezensionen, Ereignisse, Filme, lokale Unternehmen, Produkte, Restaurants, Software-Programme und TV-Serien.

- Außerdem kann man wählen, ob nur die angegebene Seite oder darüber hinaus auch ähnliche Seiten getaggt werden sollen. Wählt man die zweite Option, so erkennt Google gewisse Muster bezüglich der markierten Informationen und überträgt diese auf ähnliche Seiten. Wird zum Beispiel das Datum auf einer Seite als solches getaggt, passiert das automatisch auch auf ähnlichen Seiten.

Das eigentliche Taggen von Informationen ist ein Kinderspiel. Nachdem man die oben genannten Angaben gemacht hat, kommt man auf die ausgewählte Seite und kann dort mit dem Cursor Textteile markieren und als Datum, Ort etc. auszeichnen.

HTML-Verbesserungen

Title und Description sind elementare Bestandteile von Snippets. An dieser Stelle gibt Google Aufschluss darüber, ob Meta-Beschreibungen und Title-Tags zu lang, zu kurz oder doppelt vorhanden sind, und ob es Probleme bezüglich fehlender oder irrelevanter Title-Tags gibt. Auch nicht indexierbarer Content wird hier aufgelistet. Sind Probleme vorhanden, bekommt man durch Klicken auf das jeweilige Problem eine detaillierte Liste mit den betroffenen URLs angezeigt.

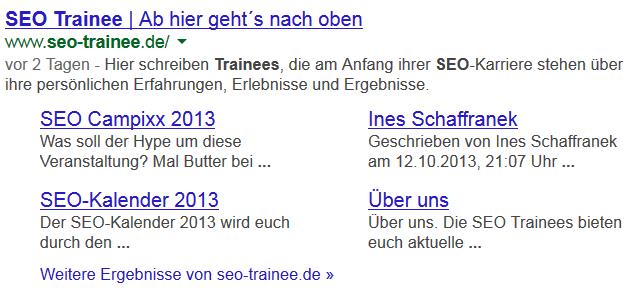

Sitelinks

Sitelinks sind automatisch generierte Links, die manchmal zusätzlich unter dem Suchergebnis für eine Website in den SERPs erscheinen können. Über die Webmaster Tools könnt ihr Seiten abwerten, sodass sie nicht mehr als Sitelinks in den Suchergebnissen auftauchen.

Das empfiehlt sich für eher unwichtige Seiten wie das Impressum und die AGBs. Diese sind in der Regel intern gut und häufig verlinkt, was für Google eines der Signale ist, um eine Seite als Sitelink anzuzeigen. Für den User bieten sie allerdings wenig Mehrwert im Snippet bzw. sie sind nicht konversionsträchtig, sodass eine Abwertung sinnvoll ist. Dazu einfach die Seite, die abgewertet werden soll, in das Feld eingeben und auf „Abwerten“ klicken.

Suchanfragen

In diesem Menüpunkt findet ihr alle wichtigen Informationen rund um die Sichtbarkeit eurer Websites und die Anzahl an Impressionen und Klicks sowie über die interne und externe Verlinkung.

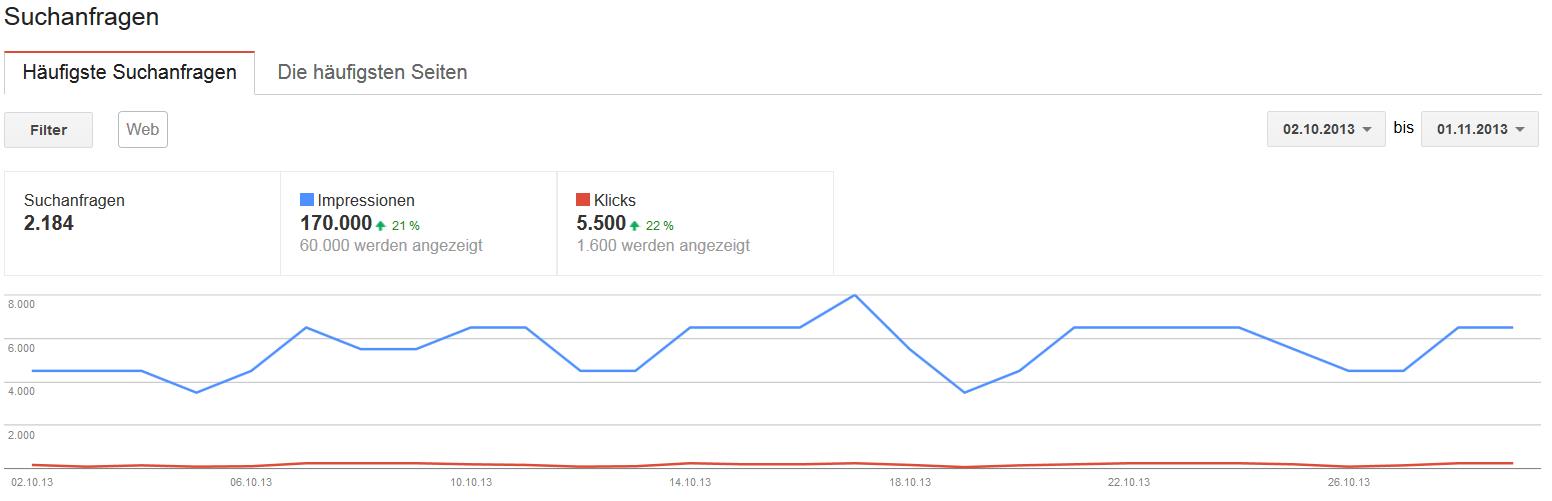

Suchanfragen

Wenn ihr wissen wollt, zu welchen Suchbegriffen eure Website rankt, dann seid ihr hier richtig. Google liefert Informationen darüber, wie viele Impressionen ihr zu einem bestimmten Suchbegriff generiert, d.h. wie oft eure Seite zu einem bestimmten Suchbegriff in den Suchergebnissen angezeigt wurde. Dazu kommt die Anzahl an Klicks, die angibt, wie häufig das jeweilige Suchergebnis angeklickt wurde.

Setzt man diese beiden Zahlen ins Verhältnis zueinander, erhält man die Click Through Rate (CTR), zu Deutsch Klickrate. Darüber hinaus wird die durchschnittliche Position angegeben, auf der ihr für den Suchbegriff rankt. Der Zeitraum, für den diese Zahlen ausgegeben werden, ist individuell wählbar, kann aber maximal 90 Tage in die Vergangenheit zurückreichen.

Diese Ansicht gibt es sowohl für die häufigsten Suchanfragen als auch für die am häufigsten angeklickten Seiten.

Bezüglich der Impressionen, Klicks, CTR und der durchschnittlichen Position kann man sich ergänzend die prozentuale Veränderung im Vergleich zum vorherigen Zeitraum anzeigen lassen.

Klickt man auf einen der Suchbegriffe, gelangt man automatisch in eine neue Übersicht zu exakt diesem Suchbegriff.

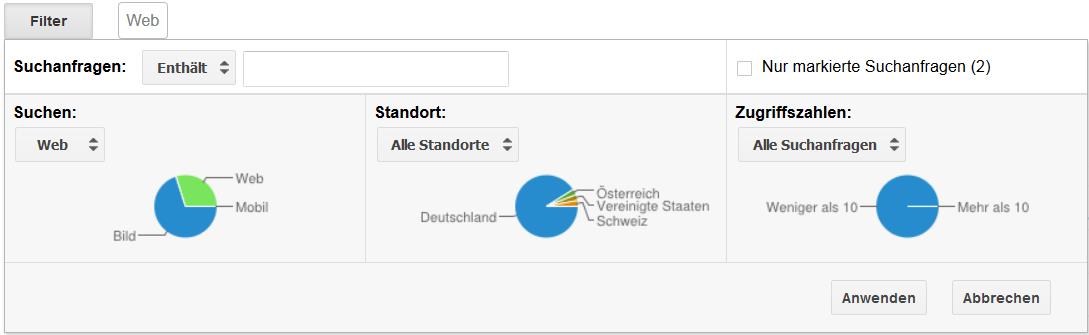

Filter

Um die Daten seinen Bedürfnissen entsprechend aufzubereiten, gibt es verschiedene Filtermöglichkeiten. Klickt man oben links auf „Filtern“, öffnet sich ein Drop-Down-Menü mit verschiedenen Möglichkeiten:

- Suchen: Hier kann man filtern nach Web-Suche, Bilder, Video und Mobil – je nachdem, worauf man seine SEO-Anstrengungen konzentriert.

- Standorte: Damit kann man Daten für bestimmte Standorte herausfiltern.

- Zugriffszahlen: Hier besteht die Möglichkeit, Suchanfragen mit sehr geringen Impressionen bzw. Klicks herauszufiltern.

Darüber hinaus kann man sich „nur markierte Suchanfragen“ anzeigen lassen. Dazu muss man vorab mindestens eine der Suchanfragen aus der Tabelle markieren, indem man auf das Sternchen links daneben klickt.

Die Daten lassen sich per Mausklick zur weiteren Verarbeitung herunterladen. Dieser Menü-Punkt liefert für SEOs wichtige Anhaltspunkte dahingehend, welche Suchbegriff noch gepusht werden sollten, um erfolgreicher zu ranken. Weist ein Suchbegriff viele Impressionen, aber wenig Klicks auf, obwohl die Seite gut für den Begriff rankt, könnte das ein Hinweis darauf sein, dass das Snippet nicht ansprechend gestaltet ist oder dass das Angebot nicht zur Suchanfrage passt. Insgesamt liefern die Webmaster Tools ausreichende Daten für SEOs und Webmaster, um zumindest einen groben Überblick zu bekommen, hinter welchen Suchbegriffen sich das größte Optimierungspotenzial verbirgt.

Links zu Ihrer Website

Unter diesem Unterpunkt findet ihr Informationen über die Backlinks eurer Website. Neben der Gesamtzahl der Backlinks gibt es unter anderem Informationen darüber, von welchen Seiten die meisten Links stammen. Klickt man auf eine der Domains, bekommt man eine detailliere Auflistung der Unterseiten der eigenen Website, auf die die Backlinks von dieser Domain zeigen.

Auch der „am meisten verlinkte Content“ wird hier übersichtlich aufgelistet. Klickt man auf eine URL, bekommt man eine Auflistung aller Domains, die auf diesen Content verweisen, inklusive der Anzahl der Links auf die eigene Seite. Klickt man wiederum auf eine dieser Domains, erhält man eine genaue Liste der Backlinks inklusive der URLs, unter denen sie zu finden sind.

Auch Anchor-Texte könnt ihr hier einsehen. Allerdings werden lediglich die 200 am häufigsten verwendeten Anchor-Texte ohne weitere Informationen oder Daten aufgelistet.

Interne Links

Auch die interne Linkstruktur ist ein wichtiges SEO-Thema und kann in den Webmaster Tools analysiert werden. Ihr findet hier eine Auflistung der am häufigsten intern verlinkten Seiten in absteigender Reihenfolge. Klickt man hier auf eine der aufgelisteten Seiten, bekommt man eine detaillierte Übersicht über die einzelnen Unterseiten, die auf die gefragte Seite verlinken.

Manuelle Maßnahmen

Falls Google eine manuelle Spam-Maßnahme gegen die Website verhängt hat, findet man hier weitere Informationen sowie Tipps zur Behebung. Geht die manuelle Maßnahme mit einem Ranking-Verlust einher, bekommt man darüber hinaus auch eine Nachricht von Google, die unter „Website-Benachrichtigungen“ zu finden ist.

Google-Index

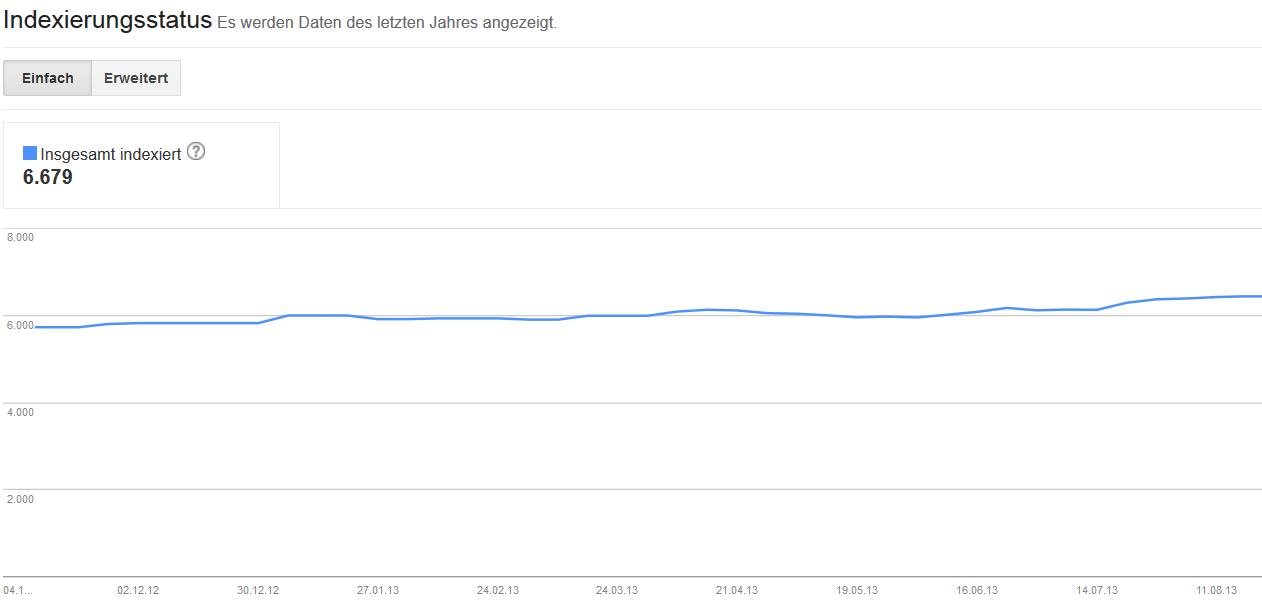

Indexierungsstatus

Ein Graph zeigt hier die Anzahl der indexierten URLs im letzten Jahr an. Klickt man hier auf „Erweitert“, kann man sich darüber hinaus weitere Zahlen anzeigen lassen:

- alle jemals gecrawlten URLs

- von der robots.txt ausgeschlossenen URLs

- entfernte URLs

Steigt die Anzahl an indexierten Seiten, deutet das darauf hin, dass Google regelmäßig auf die Website zugreifen kann und neue Inhalte indexiert. Bei einem plötzlichen Abfall der indexierten Seiten muss man in jedem Fall genauer hinschauen. Das kann ein Indiz dafür sein, dass Google nicht auf die Website zugreifen konnte, beispielsweise wegen eines Server-Problems.

In den meisten Fällen gibt es mehr gecrawlte als indexierte Seiten. Das liegt daran, dass Seiten, die z.B. das Meta Tag „noindex“ tragen oder Duplicate Content darstellen, von Google nicht in den Index aufgenommen werden.

Content Keywords

Hier zeigt Google die 200 am häufigsten auf der Website vorkommenden Keywords in einer Liste an. Klickt man auf eines der Keywords, werden neben der Häufigkeit auch die verschiedenen Varianten angezeigt, in denen es auf der Seite vorkommt. Außerdem werden die Top-Seiten gelistet, auf denen das jeweilige Keyword am häufigsten zu finden ist.

Diese Übersicht gibt einen Hinweis darauf, wie Google die Website thematisch einordnet. Vorsicht: Sind hier Keywords zu finden, die thematisch überhaupt nicht zu der Seite passen und womöglich in den Bereich Bad Neighbourhood fallen, kann das ein Zeichen für Malware sein!

URLs entfernen

Wollt ihr eine URL aus dem Index entfernen lassen, seid ihr hier richtig. Nachdem ihr die URL eingegeben habt, gibt es drei Auswahlmöglichkeiten:

- „Seite aus Suchergebnissen und Cache entfernen“

- „Seite nur aus Cache entfernen“

- „Verzeichnis entfernen“

Wählt man die erste Option, wird die URL komplett aus dem Index und Cache entfernt.

Mit der zweiten Option bleibt die URL im Index, aber die aktuell gecachte Version wird von Google gelöscht. Das kann z.B. sinnvoll sein, wenn man aus rechtlichen Gründen ein Bild entfernt hat und nicht möchte, dass dieses in der gecachten Version noch wochenlang über Google verfügbar ist.

Mit der letzten Option kann man ein ganzes Verzeichnis aus dem Index ausschließen. Hierbei ist jedoch Vorsicht geboten, weil es leicht passieren kann, dass versehentlich Seiten dabei sind, die man eigentlich doch gerne im Index hätte. Der Vorteil einer URL-Entfernung über die Webmaster Tools: Es geht in der Regel schneller als über die robots.txt oder das Meta Robots Tag noindex.

Crawling

Hier findet ihr Informationen darüber, wie der Google Bot eure Seite crawlt. Falls diesbezüglich Fehler auftreten, werdet ihr an dieser Stelle darüber in Kenntnis gesetzt und könnt entsprechend Schritte zur Crawl-Optimierung einleiten.

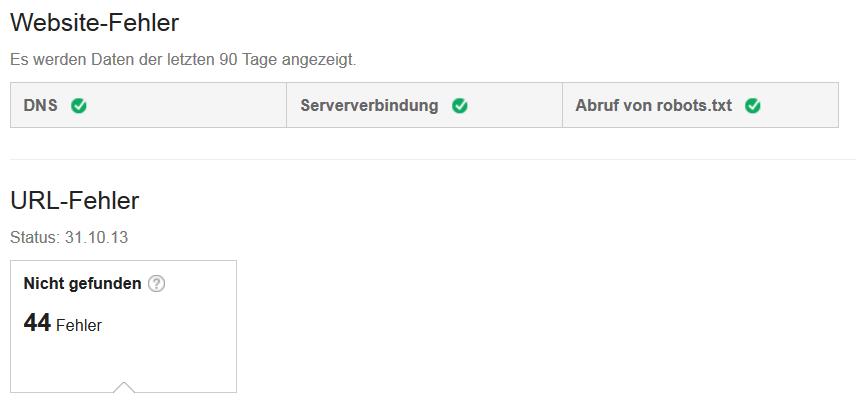

Crawling-Fehler

Crawling-Fehler werden in Website- und URL-Fehler unterteilt. Website-Fehler sind solche, die die gesamte Website betreffen, d.h. wenn der Zugriff auf die gesamte Website verhindert wurde. Es werden drei Fehler unterschieden:

Crawling-Fehler werden in Website- und URL-Fehler unterteilt. Website-Fehler sind solche, die die gesamte Website betreffen, d.h. wenn der Zugriff auf die gesamte Website verhindert wurde. Es werden drei Fehler unterschieden:

- DNS: Der Google Bot konnte nicht auf die Seite zugreifen, weil es Probleme in der Kommunikation mit dem DNS-Server gab.

- Serververbindung: Bei Überlastung des eigenen Servers und Überschreitung der zulässigen Zeit für den Seitenaufruf durch den Google Bot.

- Abruf von robots.txt: Das Crawling wurde abgebrochen, weil die robots.txt nicht ausgelesen werden konnte und der Google Bot keine Seiten crawlen möchte, die möglicherweise dort ausgeschlossen sind.

Ein grünes Häkchen signalisiert jeweils, dass alles in Ordnung ist.

Die URL-Fehler beziehen sich auf einzelne URLs und liefern dementsprechend detailliertere Informationen. Am häufigsten kommt es vor, dass Seiten nicht gefunden werden und einen 404-Fehlercode ausgeben. Das ist der Fall, wenn die Seite nicht mehr existiert, sie aber noch mindestens von einer Seite aus verlinkt ist. Folgende URL-Fehler gibt es:

- Nicht gefunden (404-Fehlermeldung)

- Nicht gefolgt

- Zugriff verweigert

- Serverfehler

- Soft 404-Fehler

- Google News-spezifische Fehler

Die nicht crawlbaren URLs werden tabellarisch inklusive gesendetem Antwort-Code und dem Datum aufgelistet, wann der Fehler erkannt wurde. Klickt man auf eine der URLs, erhält man detaillierte Informationen zu dieser. Interessant ist vor allem der Reiter „Verlinkt über“, da man hier herausfinden kann, von welchen Seiten aus die URL verlinkt ist. So kann man interne Links entsprechend korrigieren oder entfernen – was wiederum gut ist für die User Experience und die Crawl Optimization.

Hat man ein Problem behoben, kann man die jeweilige URL markieren und den Button „Als korrigiert markieren“ klicken. Die URL wird dann nicht weiter aufgelistet.

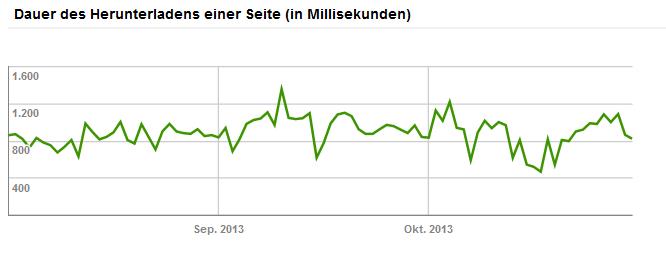

Crawling-Statistiken

Unter diesem Menüpunkt findet ihr Statistiken zum Crawl-Verhalten des Google-Bots in den letzten 90 Tagen. Hierbei gibt es Informationen zu den pro Tag gecrawlten Seiten, den pro Tag heruntergeladenen Kilobytes und der Dauer des Herunterladens einer Seite (in Millisekunden) jeweils inklusive Liniendiagramm. Schwankungen sind normal. Lediglich bei extremen Einbrüchen, z.B. bei der Anzahl der gecrawlten Seiten oder einem kontinuierlichen Anstieg der Zeit, die zum Herunterladen einer Seite verwendet wird, sollte man den Ursachen auf den Grund gehen.

Abruf wie durch Google

Hier ist es zum einen möglich, neue URLs an den Google-Index zu senden. Wenn ihr also neue Inhalte unter einer neuen URL erstellt habt, könnt ihr diese direkt an Google übermitteln. Der Vorteil: Auf diese Weise gelangen neue URLs meist schneller in den Index, als wenn man auf den nächsten Besuch des Google Bots wartet.

Außerdem kann man hier einzelne Seiten durch die Brille des Crawlers betrachten. Dazu gibt man einfach die gewünschte URL ein und klickt auf „Abrufen“. Daraufhin bekommt man den Quellcode angezeigt, wie der Google Bot ihn ausliest. Hilfreich ist das vor allem, um mögliche Hacker-Angriffe aufzudecken, bei denen der schädliche Code für den Nutzer nicht sichtbar ist, wohl aber für den Crawler.

Blockierte URLs

Über die robots.txt können bestimmte Seiten oder Verzeichnisse vom Crawling ausgeschlossen werden. Die Webmaster Tools liefern an dieser Stelle Informationen darüber, wie viele URLs über die robots.txt blockiert sind. Das ist hilfreich, um zu überprüfen, ob man die richtigen Seiten vom Crawling ausgeschlossen hat und versehentlich Seite und Verzeichnisse in der robots.txt blockiert sind, die man eigentlich gerne im Index hätte.

Außerdem besteht die Möglichkeit, die robots.txt testweise zu ändern und sich die Ergebnisse dieses Tests direkt anzeigen zu lassen, ohne die eigentliche robots.txt tatsächlich zu verändern.

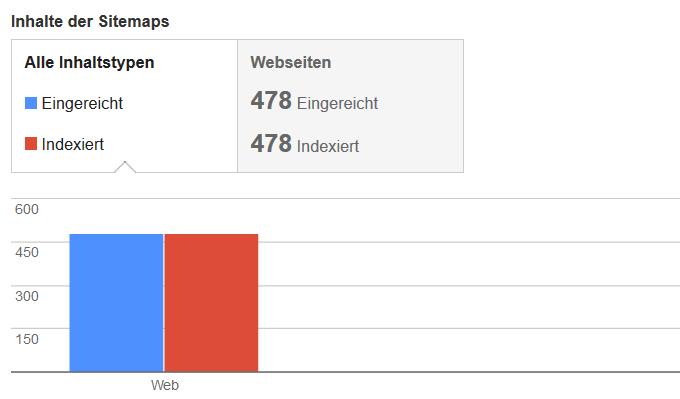

Sitemaps

Sitemaps sind ein hilfreiches Mittel, um Google über alle relevanten Seiten und Verzeichnisse der eigenen Website in Kenntnis zu setzen. Sie stellen eine Art Inhaltsverzeichnis dar, anhand dessen der Google-Bot schnell und einfach einen Überblick über die Website bekommt und auch Seiten finden kann, die aufgrund mangelnder Verlinkung sonst eventuell nicht gecrawlt werden können. Deshalb ist es in jedem Fall empfehlenswert, eine Sitemap zu erstellen (es gibt viele hilfreiche Tools). Um diese einzureichen, klickt ihr einfach auf „Sitemap hinzufügen/testen“ und gebt die URL der Sitemap ein.

Wer eine Sitemap eingereicht hat, erhält in den Webmaster Tools Informationen darüber, wie viele URLs an Google übermittelt wurden und wie viele davon tatsächlich indexiert sind. Sind weniger Seiten indexiert als eingereicht, kann das zum Beispiel daran liegen, dass einige Seiten über das Meta Tag „noindex“ oder die robots.txt von der Indexierung ausgeschlossen sind. Ist der Unterschied zwischen eingereichten und indexierten URLs sehr groß, sollte man der Sache in jedem Fall auf den Grund gehen!

Darüber hinaus werden an dieser Stelle Fehler und Warnungen angezeigt, wenn es Probleme beim Auslesen der Sitemap oder einzelner URLs gab.

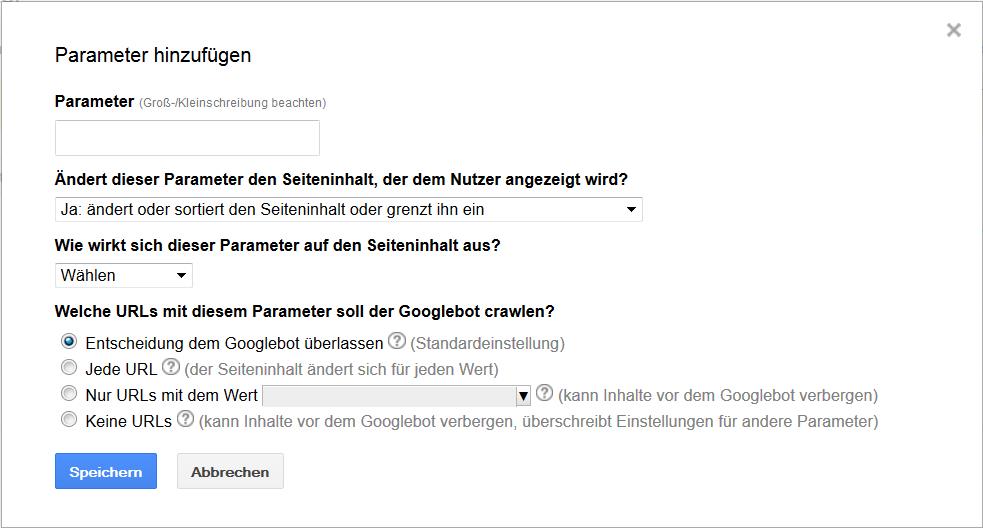

URL-Parameter

URL-Parameter werden genutzt, um „dynamische“ Seiten zu erstellen wie zum Beispiel Seiten mit Filter- oder Sortierungsfunktionen. Auch bei der Verwendung von Session IDs zum Tracken der Kaufprozesse verschiedener Kunden entstehen solche dynamischen URLs. Das Problem hierbei: Häufig entsteht Duplicate Content, d.h. derselbe Content ist unter verschiedenen URLs zu finden. Abgesehen davon, dass Google generell kein Freund von Duplicate Content ist, stellt das auch ein Problem bezüglich eines effizienten Crawlings der Website dar.

Die Webmaster Tools geben Seitenbetreibern die Möglichkeit, Google mitzuteilen, wie die verschiedenen URL-Parameter behandelt werden sollen, um ein möglichst effizientes Crawling der Website zu ermöglichen. Um ein Parameter hinzuzufügen, klickt man zunächst auf das entsprechende Feld und gibt den Parameter ein. Dann muss man angeben, ob der Parameter den Seiteninhalt, den der Nutzer angezeigt bekommt, ändert oder nicht. Ändert der Parameter den Seiteninhalt nicht (z.B. Session IDs), wird in den Webmaster Tools eine URL festgelegt, die sozusagen stellvertretend gecrawlt wird.

Etwas komplizierter ist es, wenn der Inhalt durch den Parameter verändert wird (z.B. bei Sortierungsfunktionen). Dann muss zunächst spezifiziert werden, inwieweit sich der Inhalt ändert, z.B. durch Sortierung, Eingrenzung oder Präzisierung. In einem letzten Schritt muss angegeben werden, wie der Google Bot URLs mit dem Parameter crawlen soll. Hierbei kann man wählen zwischen:

- Jede URL

- Nur URLs mit einem bestimmten Wert

- Keine URLs

- Entscheidung dem Google Bot überlassen. Diese Option sollte man unbedingt auswählen, wenn man sich nicht sicher ist.

Google selbst betont, dass es sich bei der Parameter-Behandlung um ein Feature für Fortgeschrittene handelt und man sie nur anwenden sollte, wenn man sicher ist, nicht versehentlich die falschen URLs vom Crawling auszuschließen. Nichtsdestotrotz ist die Parameter-Behandlung sehr wichtig, wenn man dynamische URLs auf seiner Seite generiert. Denn so können Probleme mit Duplicate Content gelöst und ein effizientes Crawling der Seite ermöglicht werden.

Google selbst betont, dass es sich bei der Parameter-Behandlung um ein Feature für Fortgeschrittene handelt und man sie nur anwenden sollte, wenn man sicher ist, nicht versehentlich die falschen URLs vom Crawling auszuschließen. Nichtsdestotrotz ist die Parameter-Behandlung sehr wichtig, wenn man dynamische URLs auf seiner Seite generiert. Denn so können Probleme mit Duplicate Content gelöst und ein effizientes Crawling der Seite ermöglicht werden.

Sicherheitsprobleme

Dieses Feature ist relativ neu und wird von Google genutzt, um Webmaster über mögliche Sicherheitsrisiken wie Hacker-Angriffe zu informieren. Am besten ist es natürlich, wenn Google euch an dieser Stelle mitteilt, dass keine Sicherheitslücken festgestellt werden konnten. Falls das doch einmal der Fall sein sollte, findet ihr unter diesem Menü-Punkt detaillierte Informationen.

Andere Ressourcen

Hier findet ihr hilfreiche Links zu weiteren Tools und Informationen von Google, die ihr für Optimierungszwecke heranziehen könnt.

- Test-Tool für strukturierte Daten

- Hilfsprogramm zur Auszeichnung strukturierter Daten

- E-Mail-Markup-Tester

- Google Places

- Google Merchant Center

- PageSpeed Insights

Google Labs

Im Bereich Google Labs stellt Google Funktionen vor, die sich nach eigenen Angaben noch in der Testphase befinden. Das bedeutet, dass diese Funktionen Fehler enthalten können, möglicherweise noch verändert oder auch komplett entfernt werden können. Derzeit sind drei Funktionen gelistet, die noch verfügbar sind.

Autorenstatistiken

Hier wird angezeigt, wie viele Impressionen und Klicks die Artikel verursacht haben, für die der Webseitenbetreiber als bestätigter Urheber bzw. Autor erfasst ist. Auch die durchschnittliche Position in den SERPs und die CTR werden angezeigt.

Benutzerdefinierte Suche

Google bietet Webmastern an, von den Suchfunktionen zu profitieren und die Google-Suche in die eigene Website zu integrieren. Es ist möglich, die Suchfunktion auf die eigene Seite zu beschränken oder mehrere Seiten und Websites aufzunehmen. Auch bezüglich andere Aspekte wie z.B. dem Design sind individuelle Anpassungen möglich.

Vorschau

Bei manchen Suchergebnissen in den SERPs erscheint beim Mouseover eine Vorschau der Website, ohne dass man bereits auf die Website gelangt. In diesem Menüpunkt kann man die eigene Website mit dem Vorschaubild vergleichen und so feststellen, ob Google die Vorschau korrekt ausspielt.

Fazit

Die Google Webmaster Tools sind ein wichtiges (und kostenfreies) Werkzeug für jeden Webseitenbetreiber. Für die Suchmaschinenoptimierung und insbesondere für die OnPage-Optimierung bieten sie interessante und relevante Daten, z.B. bezüglich Suchanfragen, Crawling und Indexierung. Außerdem können sie für die direkte Kommunikation mit Google genutzt werden, da man verschiedene Hinweise an die Suchmaschine senden kann, wie diese die Seite behandeln soll.

Möchtet ihr eure Snippets optimieren, findet ihr in den Webmaster Tools viele wichtige Informationen darüber, ob und wie eure Daten bereits strukturiert sind und wo Optimierungspotenzial besteht.

Auch eine Analyse der Suchanfragen ist möglich, sodass man einen guten Überblick bekommt, für welche Suchanfragen die eigene Website in den SERPs erscheint und wie häufig sie angeklickt wird.

Sowohl zur Indexierung als auch zum Crawling der Seite gibt es umfangreiche Daten, sodass man ggf. Maßnahmen für ein effizienteres Crawling ergreifen oder Problemen mit Duplicate Content auf den Grund gehen kann.

Mithilfe der Webmaster Tools ist es also möglich, die eigene Website zu analysieren, mögliche Schwachstellen aufzudecken, plötzliche Veränderungen zu erkennen und Optimierungspotenziale zu erschließen. Da man nie nur einem Tool vertrauen sollte, empfiehlt es sich, neben den Webmaster Tools auf andere Analyse-Tools wie zum Beispiel SEOlytics zurückzugreifen. Gerade was die Backlinks betrifft, sind die Daten in den Google Webmaster Tools nicht umfassend genug, um eine aussagekräftige Analyse zu erstellen. Außerdem bieten die Webmaster Tools im Gegensatz zu anderen Tools keine Möglichkeit, an die Daten seiner Wettbewerber zu kommen.

Ich hoffe, ich konnte euch einen guten Überblick über die einzelnen Funktionen geben. Als nächstes nehmen wir die Bing Webmaster Tools genauer unter die Lupe.

Habt eine schöne Restwoche!

Amke und die SEO Trainees

22 Antworten

Hallo,

schöner Artikel. Vielleicht könnte man noch den relativ neuen Punkt „Suchanalyse“ ergänzen.

Gruß

Chris

Hi Chris! Danke für die Anmerkung, das neben mir gerne auf unsere To-Do-Liste mit auf 😉 LG, Sandra

Hi Amke, ich bin wie du auch gerade in meinem SEO Trainee drin und erhoffe mir davon auch viele Einsatzmöglichkeiten 🙂 Dein Artikel ist wirklich echt ausführlich und man kann sich vieles mal anlesen… ;-)Also, dankeschön.

Hi Tina,

gern geschehen! 🙂 Und weiterhin eine lehrreiche Zeit als Trainee!

Viele Grüße,

Amke

Hallo Amke,

vielen Dank für die Aufklärung. Ich habe eine Frage zu den Sitelinks bei den Webmastertools: Was ich immer noch nicht verstehe, sind die Eingabemöglicheiten für die URLs.

Es gibt zum einen den Punkt: Für dieses Suchergebnis und zum anderen Diese Sitelink-URL abwerten.

Was wird denn jeweils dort eingegeben?

VG

andré

Hallo gibt es von Bing eigentlich eine Alternative zum Keywordtool. Ich glaube hier könnte Bing in eine echte Marktlücke stoßen.

BTW, großartiger Artikel

Hallo Marco,

danke für das Kompliment. 🙂

Es gibt in den Bing Webmaster Tools tatsächlich eine Funktion zur Keyword-Recherche, allerdings noch in der Beta-Version. So wird bisher nur das Suchvolumen zu den einzelnen Keywords angezeigt, nicht aber der Wettbewerb. Schau doch mal in unseren Artikel zu den Bing Webmaster Tools: https://www.seo-trainee.de/bing-webmaster-tools-einfuehrung/#Diagnose%20und%20Tools 🙂

Grüße,

Amke

Hi Julia,

Wirklich ein hilfreicher Artikel. Was mich aber immer verwundert sind die externen Links. Dort werden immmer viel weniger gelistet als es sein sollten. So sind manche Links zu meiner, welche definitiv bestehen, nicht zu finden. Woran kann das liegen?

Gruß

Sorry, Amke meinte ich natürlich 😀

Hallo Julia,

vielen Dank für deinen Kommentar. Grundsätzlich ist es so, dass die Auflistung externer Links in den Google Webmaster Tools nicht vollständig ist. Das kann verschiedene Gründe haben. Zum Beispiel kann es natürlich sein, dass die linkgebende Seite gar nicht im Index ist und Google somit gar keine Kenntnis über den Link erlangt.

Allerdings würde ich mich auch nicht 100prozentig darauf verlassen, dass Google tatsächlich alle Backlinks in den Tools anzeigt, von denen sie Kenntnis haben.

Die Informationen aus den Google Webmaster Tools bieten also einen guten Überblick über das Backlinkprofil einer Seite, zur vollständigen Analyse sollte man aber noch weitere Tools heranziehen, denke ich.

Viele Grüße,

Amke

Hallo, guter und vor allem sehr ausführlicher Artikel. Waren auch für mich ein paar neue Dinge dabei. Eine Frage: hast du schon mal mit der Webmaster Tools API gearbeitet? Bzw. hast du Informationen darüber?

Hallo Werner,

da muss ich leider passen. Ich habe bisher weder mit der API gearbeitet noch habe ich gerade im Rahmen einer kurzen Recherche irgendeinen wirklich aufschlussreichen Artikel dazu gefunden. Ich werde aber weiterhin die Augen offenhalten und dir hier Bescheid geben, wenn ich etwas Lesenswertes dazu finde.

Beste Grüße,

Amke

Super! Normalerweise muss ich mir die Funktionalität dieses Tools ja im Internet zusammensuchen. Es ist toll mal alles im Überblick zu haben.

Hallo Amke,

Schöner Artikel. Du könntest noch mit aufnehmen, dass bei vielen Funktionen „nur“ 1.000 Datensätze maximal angezeigt werden, z.B. bei crawling-fehlern & links (im dashboard). Darfst natürlich die Leser gerne auf mein E-Book hinweisen sofern Nico das erlaubt 🙂

Sonst mache ich das: http://www.trustagents.de/unternehmen/publikationen/google-webmaster-tools-e-book

Hi Stephan,

vielen Dank für deine Ergänzungen! 🙂

Beste Grüße,

Amke