Es scheint aktuell wieder einmal viel bei Google zu passieren. Viele Webmaster konnten starke Ranking-Schwankungen beobachten. Die Gründe für die Schwankungen sind bisher allerdings unklar, weshalb wir zu diesem bestimmenden Thema momentan keine konkreten Aussagen treffen können. Daher nehmen wir uns erneut das klassische SEO-Thema der Indexbereinigung vor. In unserem Top-Thema stellen wir Euch einige Methoden für die Deindexierung von Seiten vor.

Indexbereinigung (Teil 2) – So entfernt Ihr Seiten aus dem Index

Lange musstet Ihr warten. Aber hier kommt er – der zweite Teil zum Thema Indexbereinigung. Bereits im Wochenrückblick der KW51 des vergangenen Jahres haben wir über drei Möglichkeiten (410-Statuscode, 301-Weiterleitung und Canonical Tag) berichtet, mit denen Ihr Seiten aus dem Index entfernen könnt. Da es noch weitere Möglichkeiten gibt, wollen wir Euch diese nicht vorenthalten. In unserem Wochenrückblick der KW49 haben wir übrigens darüber berichtet, wann Ihr Seiten aus dem Index entfernen solltet. Lest Euch gerne noch einmal die Grundlagen aus den beiden vergangenen Artikeln durch.

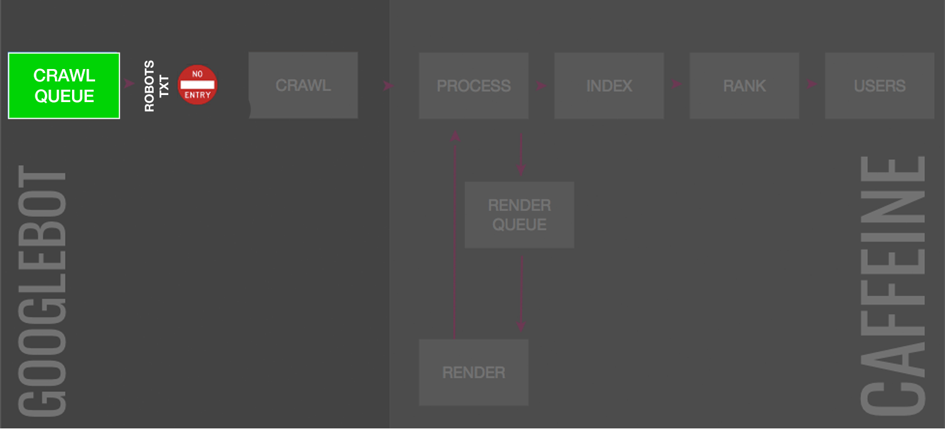

Robots.txt

Mit Hilfe der Diriktiven in der Robots.txt erhalten Website-Betreiber die Möglichkeit, Suchmaschinen mitzuteilen, welche Seiten gecrawlt werden sollen und welche nicht. Bei dem Besuch einer Website lesen Crawler immer als erstes die Robots.txt aus. Hier gibt es einige Punkte zu beachten.

- Eine von der Robots.txt blockierte Seite kann trotzdem indexiert werden, wenn beispielsweise viele externe Verlinkungen auf diese verweisen. Suchmaschinen wie Google schätzen diese Seiten dann als relevant ein und nehmen sie in den Indexierungsprozess auf.

- Bei bereits indexierten Seiten, die Ihr entfernen wollt, empfehlen wir prinzipiell, eine andere Methode zu verwenden. Gerade bei Seiten, die recht tief in der jeweiligen Domain-Architektur verankert sind, kann es sein, dass Crawler diese Seiten nicht regelmäßig besuchen. Erst wenn sogenannte Deep Crawls durchgeführt werden, erfassen Crawler die vollständige Verlinkungsstruktur einer Domain. Folglich bedeutet das für eine Deindexierung, dass einige Änderungen der Robots.txt von Seiten, die unregelmäßig gecrawlt werden, auch verspätet ausgelesen werden. Für eine schnelle Entfernung aus dem Index eignet sich diese Variante also nicht.

- Wenn Ihr eine Seite mittels eines Canonical Tags, Noindex Meta Tags oder auch 404- sowie 301-Statuscode deindexieren wollt, sollte nicht zusätzlich eine Crawl-Blockierung mit der Robots.txt durchgeführt werden. Das führt dazu, dass diese Befehle nicht ausgelesen werden können. Somit ist es wahrscheinlich, dass die Seite weiterhin im Index bestehen bleiben. Folglich sollte die Robots.txt eher für Anpassungen beim Crawling- und nicht beim Deindexierungsprozess verwendet werden.

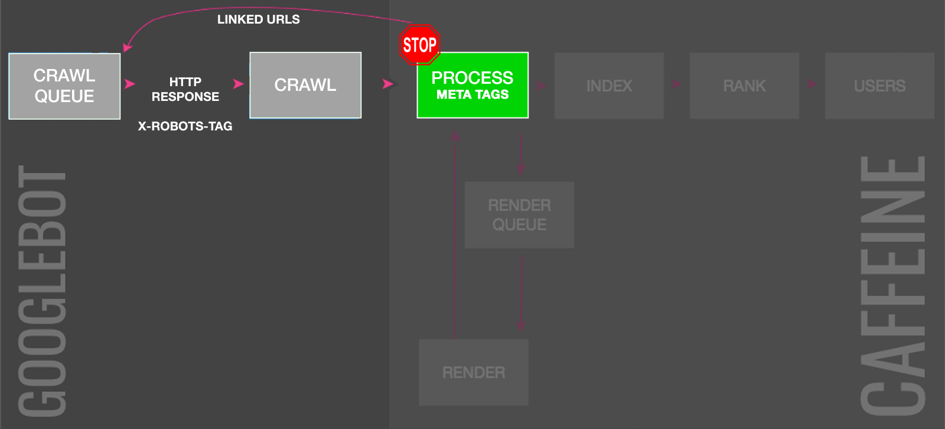

Noindex Meta Tag

Einen wesentlich schnelleren und sichereren Deindexierungsprozess könnt Ihr mit dem Noindex Meta Tag erreichen. Wenn Ihr das Tag benutzen wollt, müsst Ihr es in den Head-Bereich des Quellcodes einer Seite einbinden. Allerdings sind auch hier einige Dinge zu beachten:

- Wie bereits erwähnt, solltet Ihr bei der Verwendung des Noindex Meta Tags darauf achten, dass die jeweilige Seite nicht auch über die Robots.txt blockiert wird. Die Robots.txt wird immer als erstes von Crawlern ausgelesen. Das Noindex Meta Tag könnte der Crawler bei einer Blockierung in der Robots.txt also gar nicht auslesen, da ein weiteres Crawlen ja nicht erwünscht ist. In dem Fall, dass nun viele Domains auf genau diese Seite verlinken, ist die Gefahr groß, dass trotzdem eine Indexierung stattfinden kann.

- Ein Noindex Meta Tag sollte nicht zusammen mit einem Canonical Tag verwendet werden. Es kann passieren, dass die Wirkung des Noindex Meta Tags an die kanonisch angegebene URL vererbt wird.

- Ihr solltet Euch darüber im Klaren sein, dass alle bestehenden Ranking-Signale für immer verloren gehen.

- Seiten, die mit einem Noindex-Meta-Tag versehen sind, werden seltener gecrawlt.

- Wenn Seiten für einen längeren undefinierten Zeitraum mit einem Noindex-Attribut versehen sind, folgen Crawler den Links auf diesen Seiten nicht mehr. Sie werden dann in Prinzip zu sogenannten Nofollow-Verlinkungen. In diesen Fällen wird kein PageRank mehr übertragen.

It depends :-).

— ? John ? (@JohnMu) December 27, 2017

You probably knew that already :-))

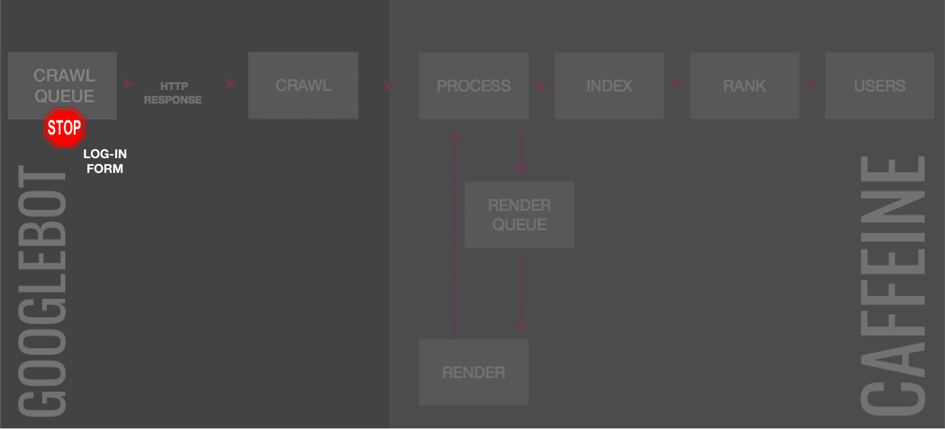

Verwendung von Passwörtern

Wenn Ihr Seiten mittels Passwörter blockiert, haltet Ihr nicht autorisierte Nutzer sowie auch Suchmaschinen davon ab, Eure Seite zu besuchen. Wie bereits erwähnt, bedingt das Crawling bis auf wenige Ausnahmen in der Regel eine Indexierung. Sollten Crawler Eure Seite auf Grund von Passwörtern nicht mehr besuchen können, wird auch irgendwann eine Indexierung aufgehoben. Allerdings kann dies ähnlich wie bei der Robots.txt einige Zeit in Anspruch nehmen. Grund hierfür ist, dass Crawler mindestens einmal bemerken müssen, dass eine Seite mit einem Passwort geschützt ist. Da aber Crawler nicht jede Seite oft erfassen, kann sich dieser Prozess auch verzögern.

URL Parameter Tool

URL-Parameter geben die Möglichkeit, geringfügig abweichende Seitenvarianten auszuspielen. Ein Beispiel könnten hierbei folgende URLs darstellen:

- https://kleider.com/produkte/damen?category=dresses&color=green

- https://kleider.com/produkte/damen?category=dresses&color=red

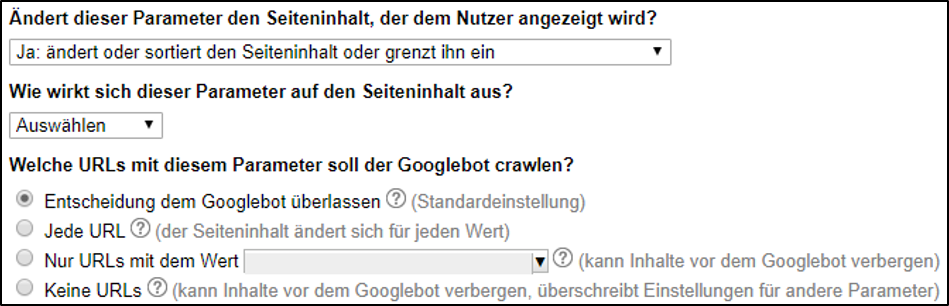

In diesem Beispiel handelt es sich um das identische Produkt. Lediglich die Produktfarbe unterscheidet sich. Um das mehrfache Indexieren dieser Seiten zu verhindern, ist es förderlich, wenn über das URL Parameter Tool der Google Search Console mehr Informationen über diese Parameter bereitgestellt werden. Dies verhindert gleichzeitig das Auftreten von Duplicate Content. In unserem Beispiel könnte nun im URL Parameter Tool die Einstellung „Ja: ändert oder sortiert den Seiteninhalt oder grenzt ihn ein“ ausgewählt werden.

Hier habt Ihr als Webmaster nun die Möglichkeit, zwischen vier Möglichkeiten auszuwählen, wie der Googlebot sich verhalten soll. Zudem solltet Ihr zusätzliche Informationen über die Parameter bereitstellen, indem Ihr beispielsweise angebt, ob der Parameter einer Produktsortierung dient.

Des Weiteren kann es auch Parameter geben, die überhaupt keinen Einfluss auf den Seiteninhalt haben. Ein gängiges Beispiel wären hier die sogenannten Session-IDs.

- https://kleider.com/produkte/damen?category=dresses&color=green?sessionid=123

- https://kleider.com/produkte/damen?category=dresses&color=green?sessionid=12

In diesem Fall sollte Ihr die Einstellung „Nein: Hat keinen Einfluss auf den Seiteninhalt (Beispiel Nutzungsverfolgung)“ auswählen. In diesem Fall crawlt der Googlebot nur die URL ohne die dazugehörigen Parameter.

Generell sollte das Tool nicht bei duplizierten Inhalten angewendet werden, die keine Parameter in den URLs beinhalten. In diesem Fall kommt ein Canonical Tag zum Einsatz.

Google rät zudem dazu, das Tool nur bei folgenden Voraussetzungen anzuwenden:

- Die Website hat mehr als 1.000 Seiten.

- Es kann eine erhöhte Anzahl von duplizierten Seiten im Index beobachtet werden, die sich lediglich durch verschiedene URL-Parameter unterscheiden.

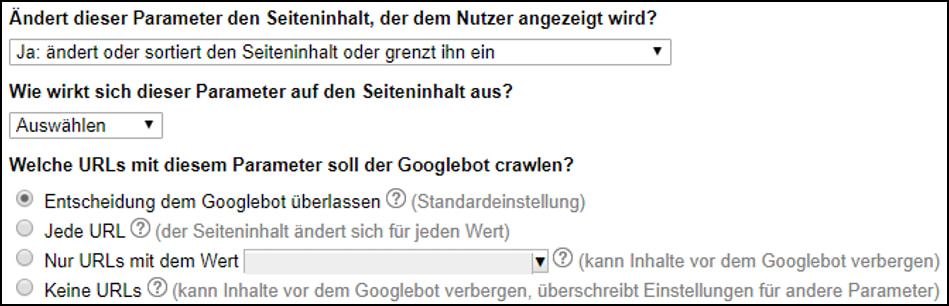

Was bedeutet dies nun hinsichtlich einer Deindexierung von Seiten? Google muss zunächst die durchgeführten Einstellungen verarbeiten. Bereits indexierte Seiten mit den jeweiligen Parametern müssen also erneut gecrawlt werden, bis eine anschließende Deindexierung durchgeführt wird. Folglich kann dies wiederum viel Zeit in Anspruch nehmen, da nicht genau gesagt werden kann, wann der Googlebot die jeweiligen Seiten crawlt. Als Präventionsmaßnahme gegenüber einem überfüllten Index mit Duplicate Content eignet sich das Tool aber sehr. In erster Linie dient das Tool zur Crawling- und nicht zur Indexsteuerung.

Fazit

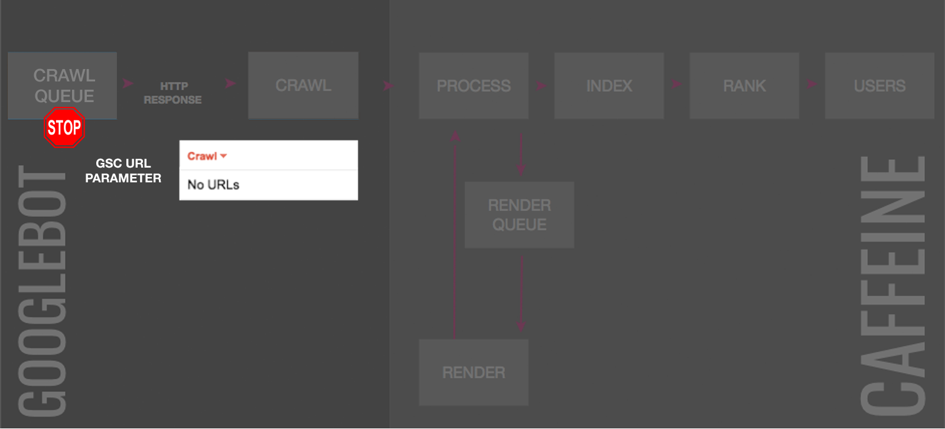

Teil eins und zwei zu dem Thema Indexbereinigungen haben gezeigt, dass es sehr viele Möglichkeiten gibt und wie diese angewendet werden. Zum Abschluss wollen wir noch einmal mit einer sehr gelungenen Übersichtsgrafik von Search Engine Journal abschließen, die auch die Entfernungsmöglichkeiten unseres ersten Teils beinhalten. Wir wünschen erfolgreiches Seitenentfernen.

Weiterführende Links

- So identifiziert Ihr eine Indexaufblähung

- Indexbereinigung (Teil 1) – So entfernt Ihr Seiten aus dem Index

- Finding Index Bloat: 9 Ways to Deindex Pages from Google

Google News

- Starke Ranking-Schwankungen bei Google: Mit Beginn dieser Woche haben mehrere Webmaster über stark schwankende Rankings berichtet. SEO-Südwest hat beispielsweise einige Social-Media-Kommentare über ein vermeintliches Google-Update von Website-Betreibern zusammengefasst und eingeordnet. Am 13. Februar meldete sich erstmals Google zu diesen teilweise sehr intensiven Schwankungen. Entgegen vieler Vermutungen, dass die Schwankungen auf ein großes Google-Update zurückzuführen sind, hat Google selbst lediglich darauf verwiesen, dass nahezu jeden Tag algorithmische Updates durchgeführt werden. Dies erklärt in unseren Augen aber nicht wirklich die starken Schwankungen. Es bleibt abzuwarten, ob Google eventuell ein weiteres Statement abgibt.

Sometimes, a particular update might be broadly noticeable. We share about those when we feel there is actionable guidance for content owners. For example, when our Speed Update happened, we gave months of advanced notice and advice….https://t.co/Nwi8I9rooP

— Google SearchLiaison (@searchliaison) November 12, 2019

- CSS-Ressourcen-Limit wird bei AMP-Seiten angehoben: Dies gab der Google-Mitarbeiter Weston Ruter über Twitter bekannt. Gemäß eines Blogposts wird das bisherige Limit von 50KB auf 75KB erweitert. Ende Februar soll die Änderung durchgeführt werden.

⚡️ WordPress AMP plugin v1.4.0 stable is now available for updating and installation via https://t.co/mDeydLvHv3: https://t.co/njtMjjzcBL

— Weston Ruter (@westonruter) October 31, 2019

Full changelog for this release: https://t.co/Q4BNw1tKC2

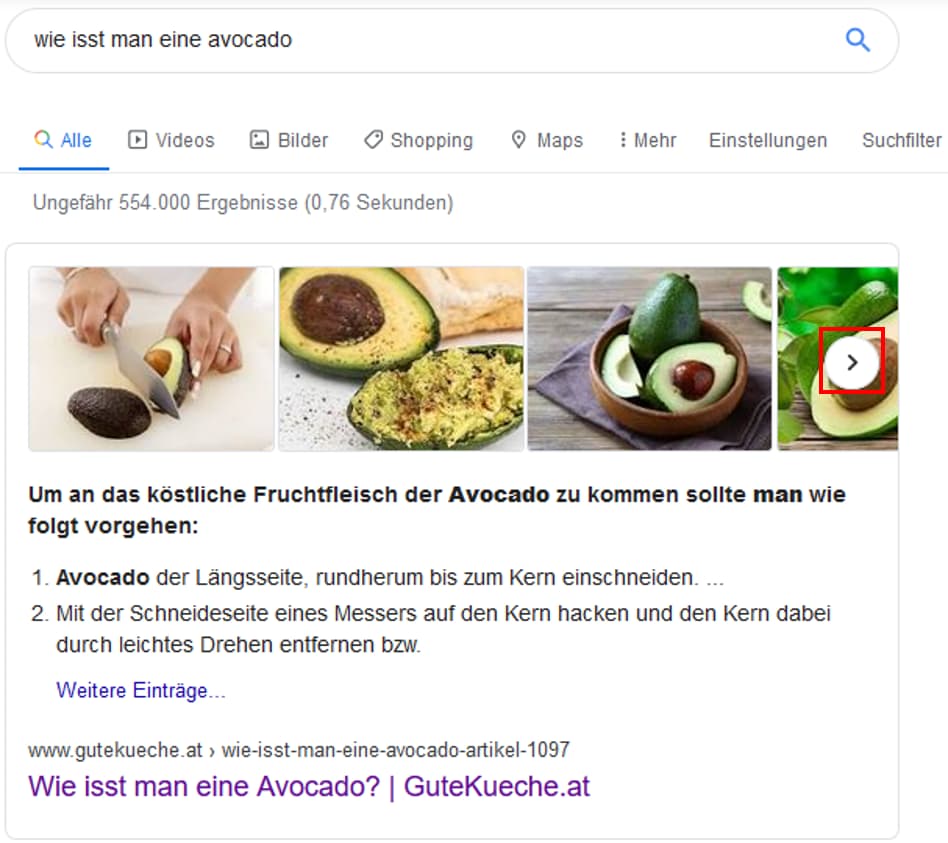

- Bilderkarussell nun auch bei Featured Snippets eingeführt: In der letzten Zeit hat es viele Änderungen bezüglich Featured Snippets gegeben. Nun gibt es eine weitere. Wie das Portal Seroundtable berichtete, werden nun noch mehr Bilder bei Featured Snippets angezeigt. Der Screenshot zeigt, dass wir diese Einführung auch bei deutschen Suchergebnisseiten von Google feststellen konnten.

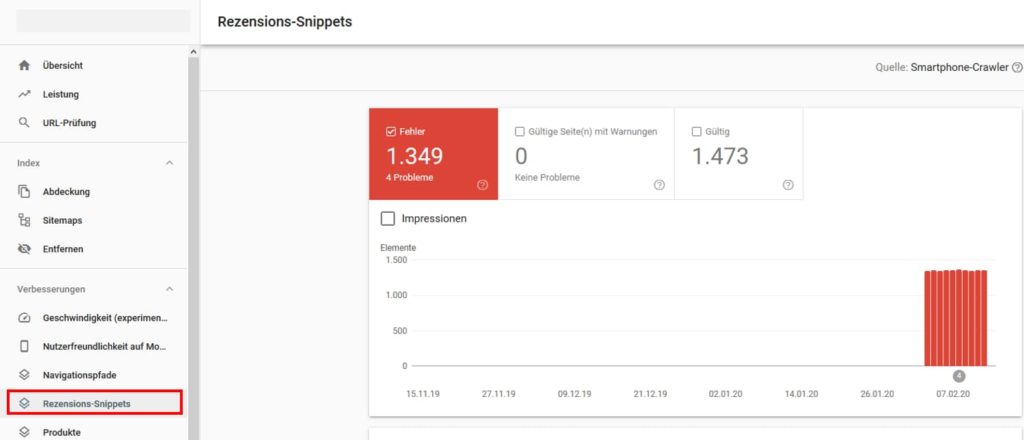

- Neuer Bericht für Rezension-Snippets in der Google Search Console: Mittels strukturierter Daten kann die Wahrscheinlichkeit für das Abbilden eines Rezension-Snippets in den SERPs erhöht werden. Daten zur Ausspielung dieser Rich Snippets findet Ihr jetzt in dem Bereich „Verbesserungen“ und zeigt Webmastern beispielsweise an, wenn Markup fehlerhaft hinterlegt ist.

Vermischtes

- YoastSEO Premium Analysis: Wer schon öfters mit Yoast gearbeitet hat, kennt es. Man versucht so viele grüne Markierungen zu bekommen, wie es geht, damit der Text bestens auf die Keywords optimiert ist. Allerdings wurde die Keywords nur in der exakt vorgegeben Schreibweise von Yoast erkannt. Mit der neuen Yoast SEO Premium Analysis werden auch veränderte Schreibweisen wie Mehrzahl oder Vergangenheitsform erkannt, um einen möglichst natürlichen Text schreiben zu können. Mehr zu dem Tool erfahrt Ihr auf dem Yoast Blog.

No more rewriting your sentences to make sure the SEO analysis picks up on your focus keyphrase? The (English and German) analysis in Yoast SEO Premium recognizes word forms, like plural/singular!

— Yoast (@yoast) February 10, 2020

And: more languages on the way. Learn more in this post. https://t.co/exIgDabXlc

- 8 Instagram Trends für 2020: Wenn Ihr noch auf der Suche nach Ideen für Eure Instagram Stories seid, dann findet Ihr auf dem Hubspot Blog die acht Instagram Trends, welche Ihr auf jeden Fall im Blick behalten solltet. Bei den Trends wird ein klarer Einfluss von TikTok deutlich, denn es werden vermehrt Video-Content und Voice-Over-Inhalte gepostet.

- Zuschauerzahlen des linearen Fernsehens gehen drastisch zurück: Laut einer Studie aus dem UK sollen die Zuschauerzahlen des linearen Fernsehens in den nächsten fünf Jahren um 21 Prozent zurückgehen. Hierbei soll vor allem die junge Zielgruppe starke Abgänge haben. Auf horizont.de könnt Ihr weitere Informationen zu der Studie lesen.

- Baut Logos und Icons in Eure Instagram Story ohne Extra-App :Diese Woche haben wir noch einen weiteren Guide für Euch, diesmal von allfacebook.de. Dort bekommt Ihr eine Anleitung, wie Ihr Logos und Icons in Eure Instagram Story einbauen könnt, ohne dafür eine andere App herunterladen zu müssen. Viel Spaß beim Verzieren Eurer Stories.

Unsere Tipps der Woche

- 10 Tipps, mit denen Ihr mehr Follower auf Pinterest bekommt: Pinterest erfreut sich immer größerer Beliebtheit und ist auch hier in Deutschland bei den Social-Media-Plattformen kaum noch wegzudenken. Das Search Engine Journal hat einen Guide mit 10 Tipps verfasst, wie Ihr Euer Pinterest-Profil verbessern und Eure Follower-Anzahl steigern könnt.

- Technisches SEO-Rätsel Hidden Keywords: Für alle Freunde des technischen SEOs gibt es ein neues Online-Rätsel von Propellernet. Bei dem Spiel Hidden Keywords müsst Ihr mithilfe Eures SEO-Wissens 20 versteckte Keywords aufspüren. Wir finden eine sehr witzige Spielerei, welche auch die erfahrensten SEOs auf die Probe stellt.

Our SEO team built a puzzle: https://t.co/2JgZBW48w6. We’re sorry.

— Propellernet (@Propellernet) February 7, 2020

Wir wünschen Euch ein schönes und erholsames Wochenende!

Janek und die SEO-Trainees