In Googles Hilfsdokument sind DuckDuckGo und Ecosia für Standardsuchmaschinen aufgenommen worden und gelten in Analytics nun als organische Quellen. Dies ist uns bei unserer Recherche für das Thema „organische Quellen im Referral Traffic“ aufgefallen. Bislang haben wir keine Meldungen seitens Googles oder anderen Medien über diese Neuheit gelesen. Diese Änderung hat es gemäß der WayBackMachine von archive.org am 5. Juli gegeben. In unserem Wochenrückblick KW 26 haben wir in unserem Top-Thema aufgearbeitet, dass Analytics-Daten bzw. die Standardeinstellungen der Datensammlung generell hinterfragt werden sollten. Nun wollen wir uns mit Euch ein wenig den Referral-Kanal im Detail anschauen und worauf Ihr hinsichtlich einer validen Datengrundlage achten solltet. Natürlich haben wir auch wie immer die aktuellen Google News für Euch.

Was ist Referral-Traffic in Analytics und wie könnt Ihr „Spam“ erkennen?

„Referral“, aus dem Englischen für „Verweis“, wird in Analytics gewertet, wenn eine andere Domain in Form eines Links auf Eure Domain verweist. Dies ist aber nur im Idealfall so. Standardmäßig zählen auch viele Suchmaschinen in den Referral Traffic hinein, da Google diese schlichtweg nicht als Suchmaschinen erkennt. Rein technisch gesehen, macht diese Kategorisierung als Referral Traffic auch durchaus Sinn, weil Suchmaschinen ja auch nichts anderes tun als Domains zu verlinken. Webmaster können die Standardeinstellung von Google Analytics verändern, um eine Unterscheidung vorzunehmen.

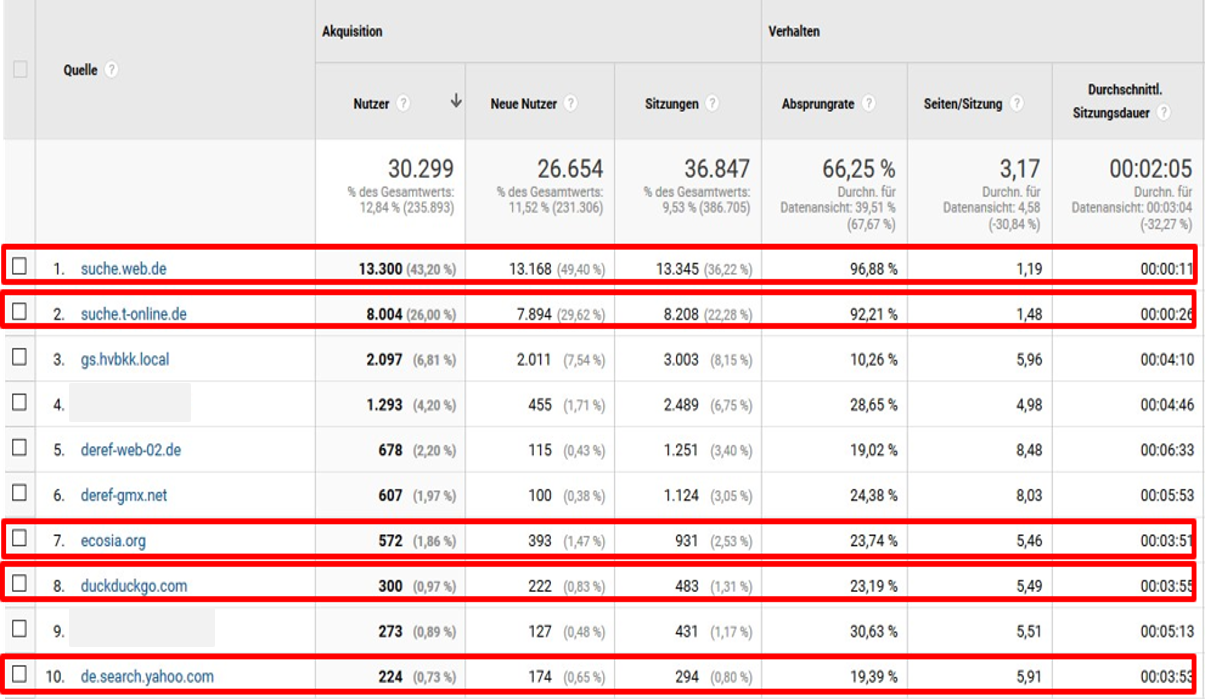

Gängige Beispiele sind in der Vergangenheit immer DuckDuckgo.com, Ecosia.org und einige mehr gewesen. Besonders lokale Suchmaschinen wie beispielsweise Metager und die T-Online-Suche sind häufig betroffen. Folglich kann die Aussagekraft Eurer Daten dadurch verzerrt werden, da es sich bei diesem Traffic ja eben nicht nur um Links anderer Domains handelt, sondern der Klick durch eine organische Suchintention zustande gekommen ist. Dies gilt es zu bereinigen.

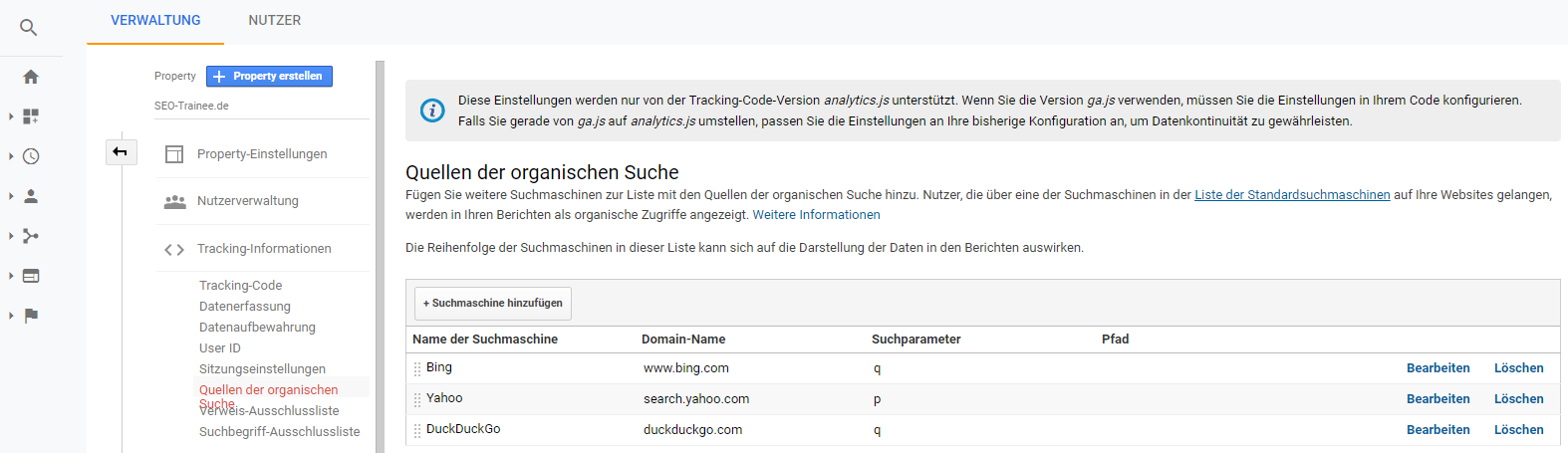

Suchmaschinen in den Property-Einstellungen hinzufügen

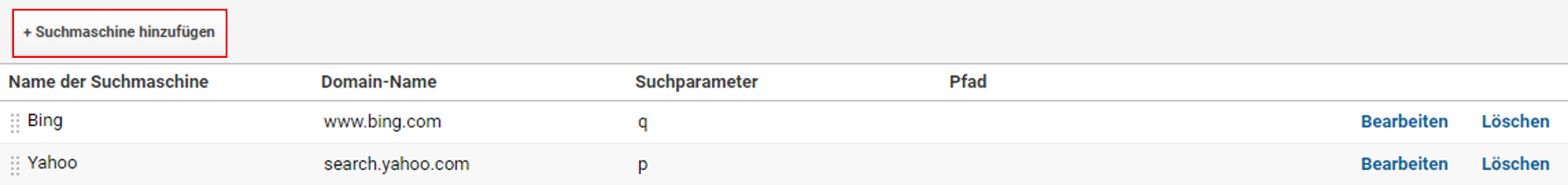

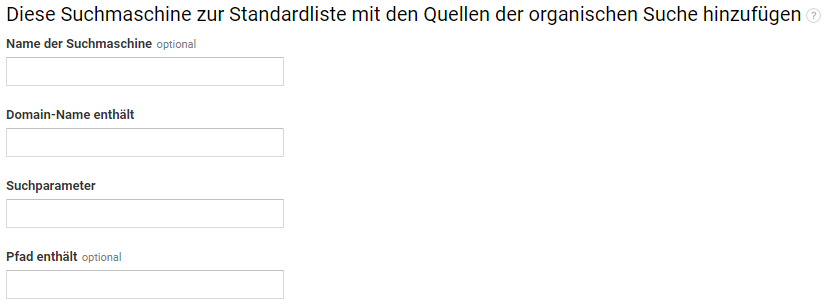

An dieser Vorgehensweise könnt Ihr Euch orientieren, wenn Ihr analytics.js für Euer Tracking verwendet. Öffnet Eure Property-Einstellungen bei Google Analytics. Klickt dann auf „Trackinginformationen“ und im Anschluss auf „Quellen der organischen Suche“. Schließlich könnt Ihr auf „Suchmaschinen hinzufügen“ die Datengrundlage des Organic Traffics anpassen.

Es erscheint ein Feld, bei welchem Ihr zwei Pflichtfelder über die neue organische Quelle ausfüllen müsst.

- Domain-Name enthält: Hier sollte schlicht die URL der jeweiligen Suchmaschine angegeben werden.

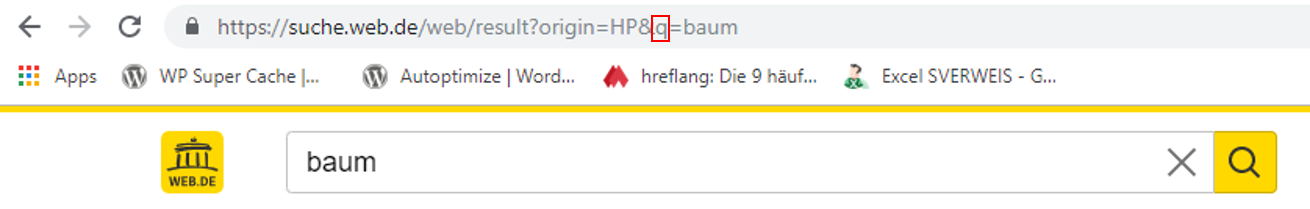

- Suchparameter: Wird eine Suchanfrage über eine beliebige Suchmaschine durchgeführt, wird das eingegebene Keyword über einen Suchparameter gespeichert. Dieser Parameter sollte hier angegeben werden.

Änderungen in Google’s Default-Liste für Suchmaschinen

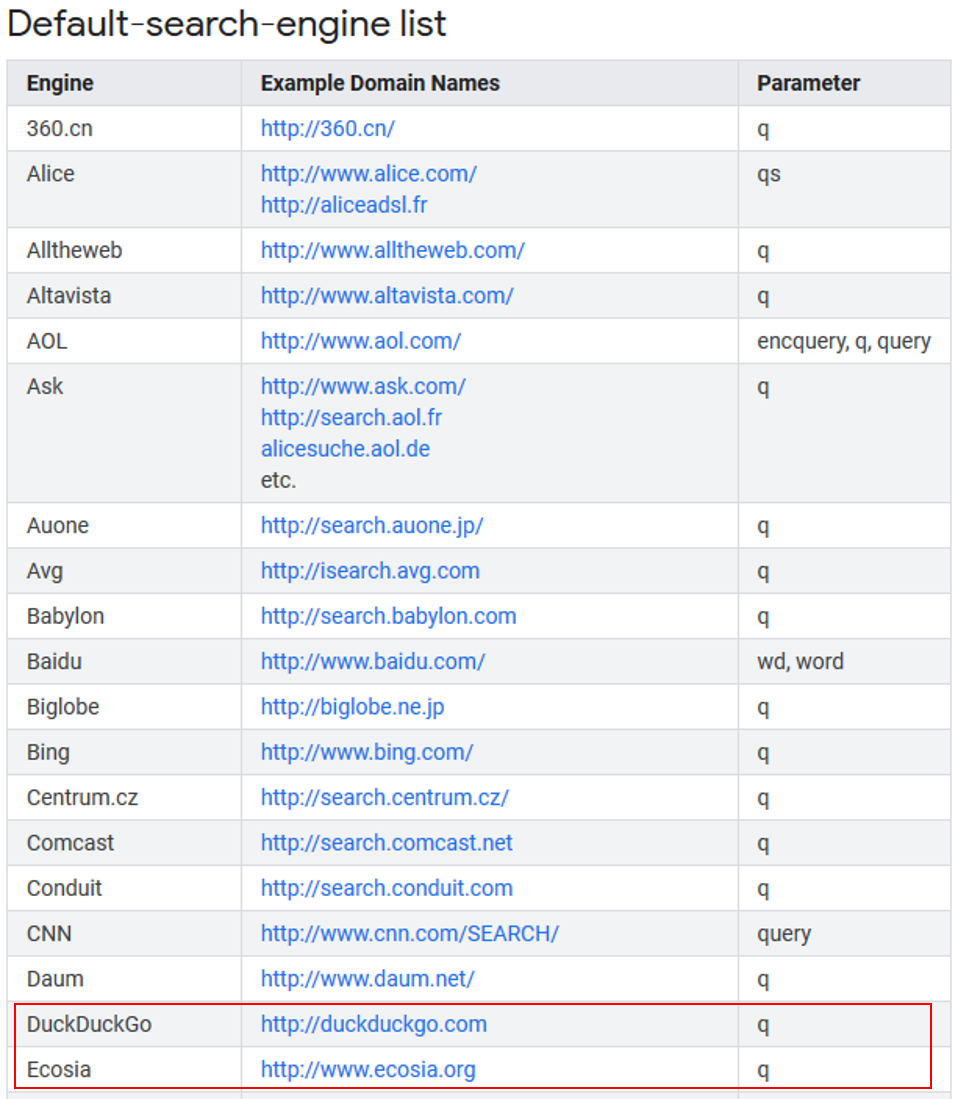

In einem Hilfsdokument von Google könnt Ihr Suchmaschinen finden, die in Analytics standardmäßig als organische Traffic-Quelle gewertet werden.

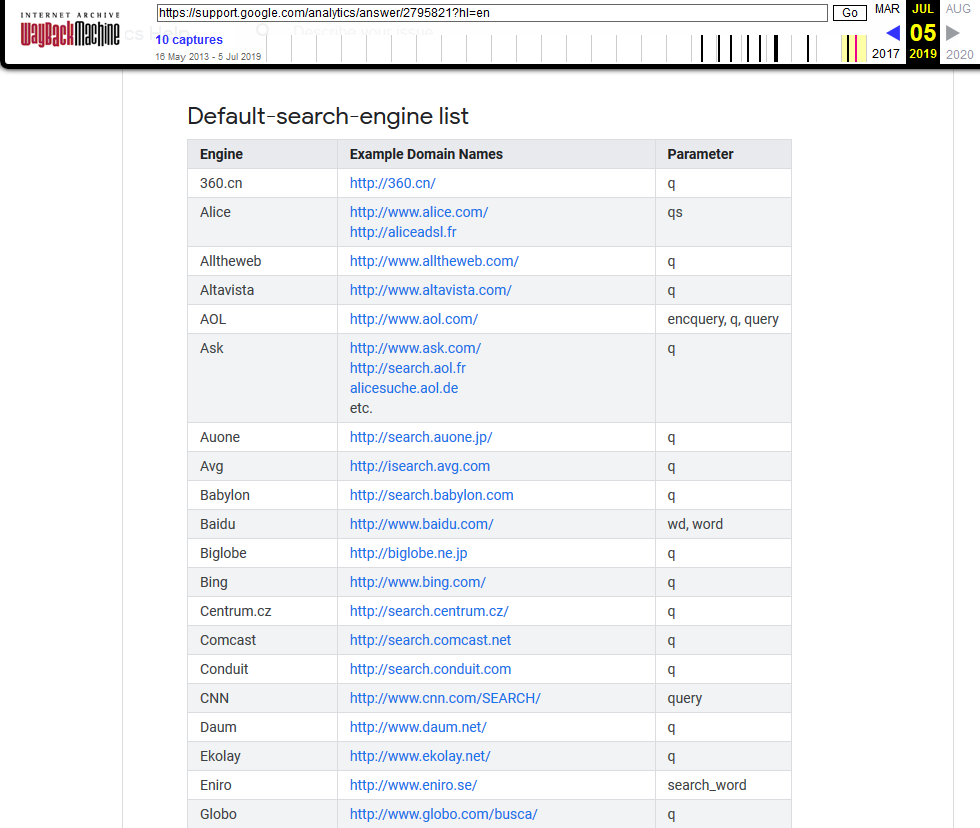

Bei unserer Recherche ist uns aufgefallen, dass mittlerweile die Suchmaschinen DuckDuckGo und Ecosia in dieser Liste enthalten sind. Wir haben die Veränderung mit der WayBackMachine nochmals rekonstruiert. Die Suchmaschinen sind seit dem 05. Juli in dem Hilfsdokument enthalten. Die deutsche Version des Hilfsdokuments beinhaltet DuckDuckGo bislang jedoch nicht.

Fazit

Die erste Grafik von unserem Top-Thema ist folglich eine veraltete Datenansicht. (siehe oben) DuckDuckGo und Ecosia sollten künftig nicht mehr im Referral Traffic von Google Analytics auftauchen.

Nichtsdestotrotz solltet Ihr Euren Referral-Kanal genauer unter die Lupe nehmen. Sind Suchmaschinen hier zu finden, die vielleicht sogar einen wesentlichen Traffic-Anteil dieses Kanals ausmachen, solltet Ihr hier unbedingt Anpassung vornehmen, um die Daten korrekt interpretieren zu können.

Google News

- Google-Statement zu Noindex-Meta-Tags in Robots.txt: In einem Twitter-Post von dem SEO-Experten Dave Ashworth wird deutlich, dass Google es ernst meint mit dem Entfernen von Noindex-Meta-Tags aus der Robots.txt. In unserem Wochenrückblick KW 27 haben wir darauf hingewiesen, dass das Robots Exclusion Protocol offiziell am 1. September in das IEFT aufgenommen wird. Darüber hinaus wird der Support unter anderem von der Noindex-Regelung, die Google zudem nie offiziell bestätigt hatte, abgeschafft. Nun hat Google damit angefangen, Webmastern Benachrichtigungen zu schicken, wenn Noindex-Meta-Tags in der jeweiligen Robots.txt vorhanden sind. John Mueller relativiert allerdings ein wenig. In einem Twitter-Post macht er deutlich, dass kein Schaden entsteht, wenn Noindex-Meta-Tags nicht aus der Robots.txt entfernt würden. Es bringt aber eben auch keine Vorteile.

Google schickt Webmastern Benachrichtigungen, wenn Noindex-Meta-Tags in der Robots.txt vorhanden sind. ©Dave Asherworth - Statement von John Mueller zum Thema Links: In der neuen Videoreihe #AskGoogleWebmasters hat John Mueller zu folgender Nutzerfrage Feedback gegeben: „Does linking to other websites help or hurt SEO?“ Mueller bestätigte, dass dies eine sehr gute Möglichkeit sei, Nutzern mehr Inhalte zur Verfügung zu stellen. Zudem erklärte der Webmaster Trends Analyst von Google, welche Verlinkungsarten negative Folgen für SEO haben können. Schaut Euch die Folge an, um zu erfahren, um welche Arten es sich handelt. Um nicht von den negativen SEO-Folgen solcher Links betroffen zu sein, empfiehlt Mueller, das Nofollow-Attribut einzusetzen. Es verhindert, dass bei spammigen Links Linkjuice weitergegeben wird. In der Regel halten sich Suchmaschinen-Crawler an dieses Attribut.

- Text sollte bei Kategorieseiten von Onlineshops bedachtsam eingesetzt werden: Mueller äußerte sich in einem Webmaster-Hangout, dass ausschließlich sinnvoller Kategorie-Content auf Kategorieseiten von Onlineshops platziert werden sollte. Google verwirrt es demnach, wenn zusätzlich informationsorientierte Keywords verwendet werden. Der transaktionsorientierte Hintergrund von Kategorien müsse für Suchmaschinen eindeutig sein.

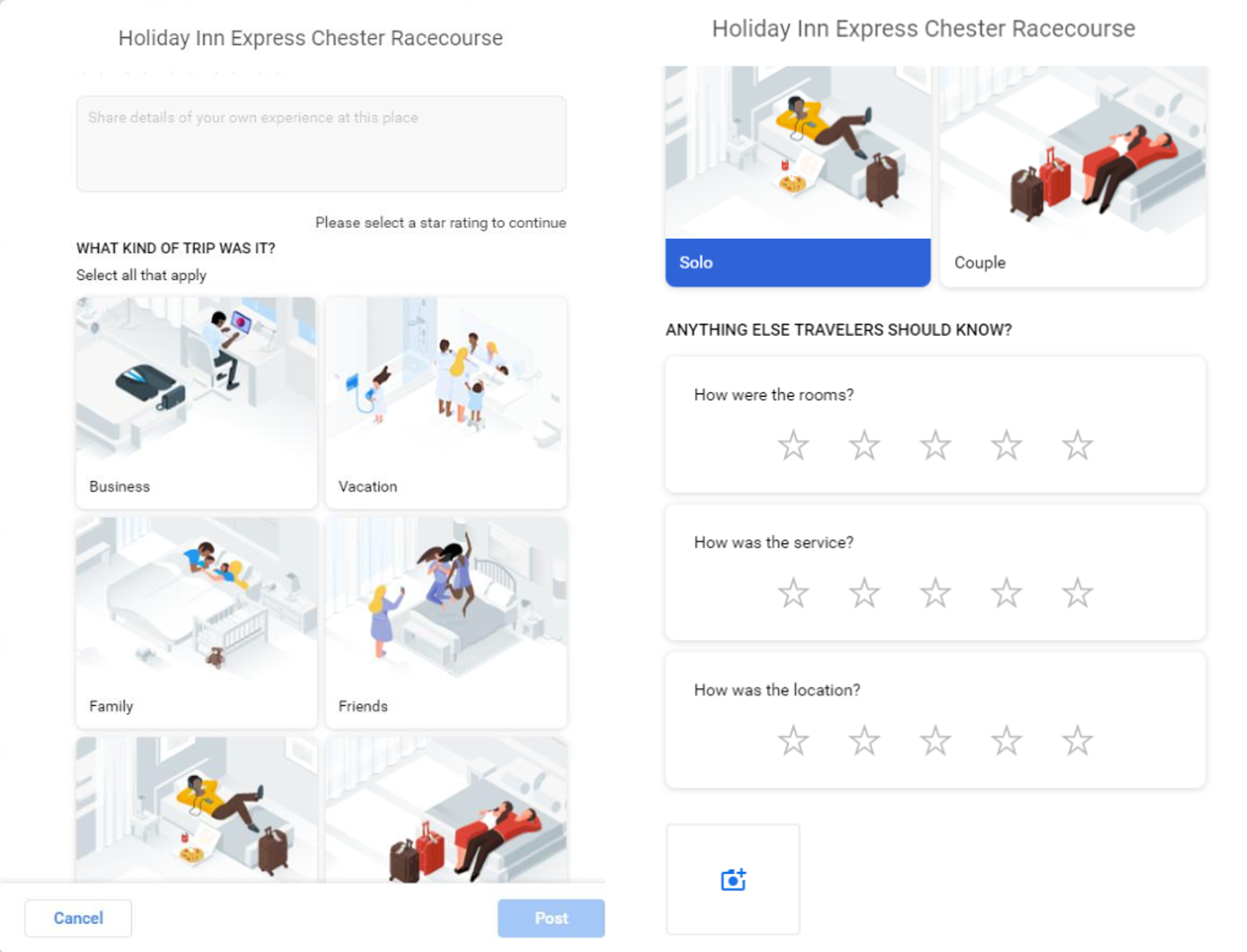

- Google testet erweiterte Bewertungsfunktionen für Hotels: Dies ging aus einer Twitter-Meldung von Tim Capper, Local SEO Consultant von Google My Business, hervor. Demnach wird getestet, ob Bewertungen für einzelne Nutzer oder beispielsweise auch für Paare sinnvoll sind. Ein weiterer Aspekt ist der Anlass des Hotelbesuchs. Auf diese Weise könnten Hotels sehr viel über Ihre Zielgruppe und gegebenenfalls auch über das Abstimmungsverhalten von Gästen herausfinden.

So sehen die neuen Bewertungsfunktionen aus, die aktuell in Google Maps getestet werden. ©Tim Capper - Es kann bis zu einem Monat dauern, bis Sitelink Search Boxes in den SERPs erscheinen: Dies ging ebenfalls aus dem bereits erwähnten Webmaster-Hangout hervor. John Mueller bestätigte an dieser Stelle, dass es nach der Einrichtung der Markups (JSON-LD, Mikrodaten) gegenüber anderen Arten von strukturierten Daten vergleichsweise lange dauern kann, bis diese in den SERPs tatsächlich sichtbar würden.

- GA: Tracking für Apps und Websites ab sofort in einer Property möglich: Russel Ketchum, Group Product Manager bei Google Analytics, hat in einem Blogbeitrag die Neuheit vorgestellt. Es wird nun künftig möglich sein, Analytics-Daten für Apps und Websites in einer Property zusammenzufassen. Zuvor ist dies ausschließlich getrennt voneinander möglich gewesen. Erfahrt in dem Beitrag, wie Ihr diese Tracking-Variante einrichten könnt, welche Vorteile es mit sich bringt und welche speziellen Ansichten es gibt.

Vermischtes

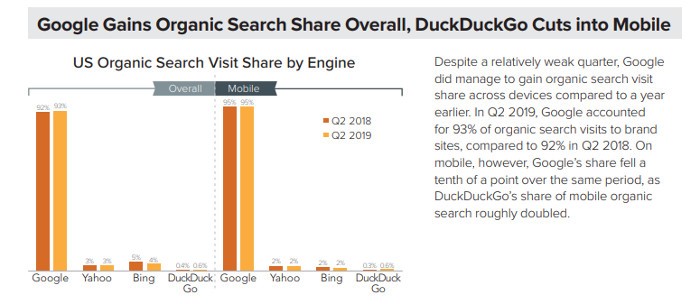

- Der Merkle-Report rund um Online Marketing des zweiten Quartals ist da: Die Studie ist sehr umfang- sowie facettenreich. Daten zu folgenden Themen werden ausgewertet: Paid Search, Organic Search, Social, Amazon Ads und Display & Paid Social. In der eingebetteten Grafik könnt Ihr einen kleinen Vorgeschmack der Studie bekommen. Ladet die Studie herunter, um die spannenden Insights zu erhalten.

Nur DuckDuckGo konnte als einzige Suchmaschine bei Search-Anteilen auf mobilen Endgeräten wachsen. ©Merkle - Mehr Werbung in der Facebook-Suche: Matt Southern berichtet auf Search Engine Journal darüber, dass ab Dezember 2019 ausgewählte Unternehmen das erste Mal Anzeigen in der Suche von Facebook platzieren können. Um welche Unternehmen es sich handelt, bleibt offen. Matt Southern bezieht sich bei seinen Aussagen auf verschiedene Twitter-Posts wie beispielweise von Steven Johns, digitaler Marketing Consultant. Lest den Artikel, um zu erfahren, welche Rahmenbedingungen für diese neue Art von Ads bisher bekannt sind.

- Nutzerdaten werden durch eingebundene Facebook-Likes übermittelt: Der EuGH legte fest, dass Webmaster für die Daten mitverantwortlich sind, die durch eingebundene Like-Buttons ohne weitere Interaktion an soziale Netzwerke übermittelt und erhoben werden. Heise online berichtet darüber, dass aus diesem Grund Website-Betreiber dazu verpflichtet sind, Seitenbesucher über diesen Umstand vor einer Seiteninteraktion darüber zu informieren und eine Zustimmung einzuholen. Zu den erhobenen Nutzerdaten gehört Folgendes: IP-Adresse, Browser-Kennung und Datum sowie Uhrzeit des Website-Aufrufs. Auch Nicht-Mitglieder werden getrackt. Webmaster sollten aus diesem Grund eine sogenannte Zwei-Klicklösung verwenden, sodass erst wenn der Nutzer auf Social-Icons klickt, auch Daten an soziale Netzwerke übermittelt werden. Nutzer können sich übrigens auch selbst vor dieser Art von Tracking schützen. Die Electronic Frontier Foundation (EFF) bietet dafür einen sogenannten Privacy Badger für Chrome, Firefox und Opera an.

Unser Tipp der Woche

- Barry Schwarz interviewt Rand Fishkin: Auf Searchengineland ist mittlerweile der zweite Teil des Interviews von Barry Schwarz mit Rand Fishkin, Gründer von MOZ und SparkToro, veröffentlicht worden. In dem Interview wird unter anderem über die Studie von SparkToro gesprochen, die vor kurzem sogar in den Gerichtsräumen einer Google-Anhörung von dem Kongressabgeordneten Cicilline zur Sprache gekommen ist. In dieser Studie geht es unter anderem darum, dass Google seine eigenen Produkte in Search bevorzugt darstellt. Schaut Euch das Video an, um mehr über die Gedanken der beiden SEO-Experten zu erfahren.