Wir haben nach Ostern eine weitere kurze Woche hinter uns, doch das interessiert die Welt der SEO News nicht! Als Ostermontagsei bringt uns Google neue Funktionen im Keyword Planner, außerdem gibt es eine spannende Studie zur robots.txt und jede Menge vermischte Nachrichten von Twitter, YouTube und Co. Also, bringt euch schnell auf den neuesten Stand!

Wettbewerbsvergleich im Keyword Planner

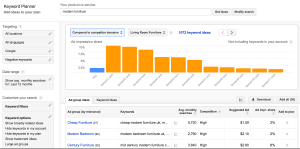

Eine untypisch leise verkündete Meldung aus dem Hause Google ließ alle fleißigen Nutzer des Google AdWords Keyword Planner hellhörig werden. Der Google-Osterhase brachte am Montag ein neues Feature in das für Keyword-Recherchen und -Analysen sehr beliebte Tool. Ab sofort lässt sich mit dem Keyword Planner auch ein direkter Vergleich der eigenen Website zur Konkurrenz ziehen.

Dabei wird die eigene Keyword-Abdeckung bzw. der Anteil an möglichen Ad-Impressionen mit denen anderer Mitbewerber verglichen. Dies können entweder die fünf Marktführer der Branche oder direkte Konkurrenten sein. Dies zeigt vor allem das zweite von Google mitgelieferte Screenshot-Beispiel schön:

Google empfiehlt den Webmastern, sich auf Keyword-Kategorien zu konzentrieren, bei denen der eigene Anteil an Ad-Impressionen im Vergleich zu anderen gering ist. Die Anzeige des direkten Vergleichs mit den Mitbewerbern hilft ihnen zu entscheiden, an welcher Stelle sich Keyword-Erweiterungen am meisten lohnen. Bei der Einführung neuer Produkte kann die Konkurrenzübersicht beispielsweise hilfreich sein, um sich in neuen Keyword-Feldern schnell zurechtzufinden und relevante Keywords zu identifizieren. Die Neuerung ergänzt die bisherigen Funktionen, nach Ideen für Keywords zu suchen und Suchvolumina für Keyword-Listen oder Anzeigengruppen abzurufen. Google bietet Webmastern mit der Erweiterung des Tools ein wichtiges Feature an, dessen Dienst sie sich bisher bei anderen Anbietern holen mussten.

Gerichtsurteile aus dem letzten Jahr, die uns heute noch beschäftigen

Wer als Person, Marke oder Unternehmen in der Online-Öffentlichkeit steht, muss sich auch stets mit rechtlichen Vorgaben und Pflichten auseinandersetzen, die in Rechtsstreits an deutschen oder europäischen Gerichtshöfen immer neu definiert werden. Dies trifft vor allem auch auf den SEO-Bereich zu. In seinem Gastartikel auf OnPage.org greift Rechtsanwalt Dr. Marc Laukemann fünf spannende und überraschende Gerichtsurteile aus dem vergangenen Jahr auf, deren Auswirkungen sich auch über dieses Jahr hinaus bemerkbar machen werden.

- Right to be forgotten vor dem Europäischen Gerichtshof: Ein spanischer Staatsbürger war verärgert, als Suchmaschinengigant Google ihn negativ in den Suchergebnissen darstellte, und forderte die Löschung dieser Daten. Sich seiner Sache sicher, weigerte sich Google und trat zur Grundsatzentscheidung vor

den Europäischen Gerichtshof. Dieser gab jedoch dem Spanier Recht. Seitdem müssen Einträge, die veraltete Informationen enthalten bzw. bestimmten Anforderungen entsprechen, auf Antrag hin gelöscht werden. Dies gilt allerdings nur für das Auftauchen in den Google-SERPs, der eigentliche Inhalt der angezeigten Website bleibt bestehen.

den Europäischen Gerichtshof. Dieser gab jedoch dem Spanier Recht. Seitdem müssen Einträge, die veraltete Informationen enthalten bzw. bestimmten Anforderungen entsprechen, auf Antrag hin gelöscht werden. Dies gilt allerdings nur für das Auftauchen in den Google-SERPs, der eigentliche Inhalt der angezeigten Website bleibt bestehen. - Urheberrecht bei Videos: Verantwortungsbewusste Website-Betreiber kümmern sich um die Wahrung des Urheberrechts. Dies war bis zum Urteil des EuGhs im letzten Jahr bei der Einbettung von Videos allerdings noch nicht vollständig geklärt. Seitdem ist es ohne Verletzung des Urheberrechts gestattet, Videos externer Seiten via Framing-Technik auf der eigenen Seite einzubauen. Beim Framing liegen die Inhalte noch auf dem externen Server, was ausschlaggebend für diese Entscheidung war. Das Herunterladen von Videos auf den eigenen Server und eine anschließende Weiterverwendung ist und bleibt allerdings weiterhin verboten.

- Dienstverträge für SEOs: Für Agenturen, die SEO-Leistungen anbieten und oftmals mit zahlungsfaulen Auftraggebern zu tun hatten, war das Urteil des Oberlandesgerichts Köln Anfang letzten Jahres entscheidend. Dies besagte, dass SEO-Anbieter in einigen Online-Marketing-Bereichen einen sogenannten Dienstvertrag mit Kunden abschließen können, der keinen „Erfolg“ garantiert, sondern ein Aktivwerden. Dies war vor allem für die SEOs wichtig, deren Kunden Rechnungen mit Berufung auf nicht erbrachte „Erfolge“ nicht zahlen wollten.

- Gebrauch von Marken-Keywords: Das Oberlandesgericht Frankfurt fällte im April 2014 eine abschließende Entscheidung hinsichtlich des Gebrauchs von fremden Marken als Keywords in Google AdWords. Seitdem ist es jedem untersagt, fremde Markennamen als Keywords, für die man selbst ranken will, zweckzuentfremden.

- Double Opt In Emails: Auch wenn das Oberlandesgericht München zuvor eine andere Einschätzung gab, entschied der Gegenpart in Celle, dass E-Mails mit Double Opt In nicht unzulässig seien. Wenn der Empfänger sich nach einer E-Mail mit Double Opt In weiterhin darauf beruft, keine Einwilligung erteilt zu haben, ist er in der Bringschuld und trägt die Darlegungslast.

Spannende Urteile, die uns in der SEO-Welt auch noch in diesem Jahr und darüber hinaus beschäftigen werden. Im Artikel von OnPage.org findet ihr zu jedem Urteil wichtige Hinweise!

Ich hab gesagt: draußen bleiben! – Wie Suchmaschinen gesperrte Inhalte doch indexieren

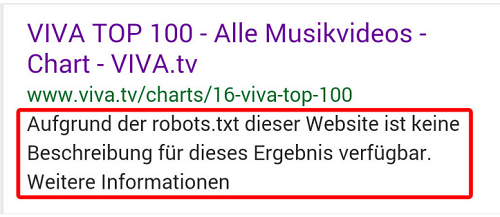

Inhalte vor der Indexierung von Suchmaschinen sperren? – Klar, das geht mit der robots.txt. Die Robots.txt-Datei bietet Webmastern die Möglichkeit, der Suchmaschine mitzuteilen, welche Seiten oder Verzeichnisse vom Suchmaschinen-Bot gecrawlt beziehungsweise nicht gecrawlt und indexiert werden sollen. In den Suchergebnissen erkennt man einen solchen Inhalt daran:

Doch wie können Webmaster sicher sein, dass dies auch der Fall ist und sich Google & Co. und auch die sozialen Netzwerken daran halten? Diesen Test hat Pascal Horn auf nblogs.de gemacht und sich viel Mühe gegeben, seine Ergebnisse und Learnings in übersichtlichen Tabellen mit uns zu teilen. Sein Ziel war dabei herauszufinden, wie die Suchmaschinen Google, Bing und Yahoo! gesperrte Inhalte vielleicht doch in ihren Index aufnehmen und unter welchen Bedingungen dies geschieht. Er verwendet dabei in verschiedenen Tests Blogbeiträge als Testobjekte. Als Testkriterien hat er dabei z.B. die gezielte Suche nach Keyword-Kombinationen, die in den gesperrten Inhalten auftauchen, oder auch die Einbindung eines Google Analytics Tracking Code in die gesperrten Inhalte verwendet.

Seine Ergebnisse dabei sind sehr interessant: Lediglich Suchmaschinengigant Google hält sich in allen Fällen an den robots.txt-Befehl und crawlt die Inhalte nicht. Bing und Yahoo! allerdings ignorieren hingegen in manchen Fällen diese Anweisung. Aber auch Facebook und Google+ versagen: Relativ schnell stellte der Autor fest, dass sich die sozialen Netzwerke generell nicht an aktuelle robots.txt-Dateien halten. Allerdings arbeiten sie auch nicht mit Bots im klassischen Sinne und überprüfen die Inhalte nicht auf eine eventuelle Aussperrung per robots.txt.

Eine Gesamtübersicht der Ergebnisse von Pascal seht ihr unten, viele weitere interessante Learnings und anschauliche Beispiele findet ihr in seinem ausführlichen Artikel! Vielen Dank für deine Arbeit, Pascal! 😉

Online Marketing News Worldwide

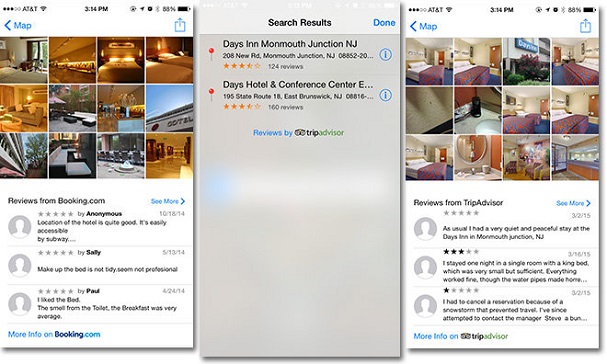

Wie SearchEngineLand diese Woche berichtete, aktualisierte Apple vor kurzem seine Bewertungsquellen im hauseigenen Maps-Service bei lokalen Suchanfragen in Orten, die sich vor allem außerhalb der USA befinden. Bisher wurden in diese Ergebnisse nur Bewertungen von yelp aufgenommen, diese wurden jetzt durch Reviews von TripAdvisor und booking.com erweitert. Dabei wird TripAdvisor vor allem bei Bewertungen zu Restaurants und booking.com bei Hotel-Reviews genutzt. Die neuen Quellen scheinen die Yelp-Ergebnisse allerdings bisher nur zu ergänzen, nicht zu ersetzen.

Vermischtes

- Telefonnummern im AdWords-Konto: Google wird seinen werbenden Webmastern ab Juni nur noch gestatten, mit Telefonnummern zu werben, die im Google-AdWords-Konto hinterlegt sind. Dies geschieht in erster Linie, um den Zusammenhang zwischen einer Website und dem jeweiligen AdWords-Konto herzustellen. Dass es sich dabei aber eher um vordergründige Sicherheit handelt, berichten die Internetkapitäne auf ihrem Blog-Beitrag.

- Mehr Platz beim Twittern: Begeisterte Retweeter konnten in dieser Woche aufatmen, denn ihre Beschwerden wurden erhört. Twitter kündigte in dieser Woche die Neuerung für Retweets an, die zukünftig nicht mehr zur 1:1-Übernahme einer Nachricht verpflichtet, sondern ein Einbetten des Tweets in eigene Gedanken ermöglicht. Außerdem löst sich Twitter beim Zitieren von der 140-Zeichen-Vorgabe und bietet seinen Usern 116 Zeichen mehr Raum. Twitter selbst zeigt, wie das bald funktionieren soll:

Say more with revamped quote Tweet! Rolling out on iPhone and web, coming soon to Android. https://t.co/Bcl3E859ne pic.twitter.com/fioAPPi0nW

— Twitter (@twitter) 6. April 2015

- FAQ-Bereich im Blog: Einen einfachen, aber doch oft übersehenen Blogger-Tipp gibt es in dieser Woche von den Experten von blogprojekt.de. Wie ihr mit einem FAQ-Bereich nicht nur eure User glücklich macht, indem ihr ihnen Antworten auf immer wiederkehrende Fragen liefert, sondern auch selbst davon profitiert, lest ihr im Artikel nach. Vom Aufbau bis hin zu Pflege der FAQs findet ihr hier nützliche Hinweise.

- Content-Marketing-Konzert: „Der Reiz der neuen Marketing-Form liegt in der Orchestrierung unterschiedlicher Kanäle“, so beschreiben Christoph Steinhardt und Judith Schröder im Interview mit dem PR-Journal die Herausforderung von Content Marketing. Was man mit Content Marketing eigentlich erreichen sollte und was sich Kunden, aber auch Anbieter davon erhoffen, lest ihr im spannenden Interview nach!

- Veränderte In-Depth-Artikel-Darstellung: Google nahm in dieser Woche Veränderungen in de Suchergebnissen bei In-Depth-Artikeln vor. Zum einen werden diese nicht mehr von den anderen Ergebnissen abgetrennt, zum anderen werden die Snippets nicht mehr durch Bilder angereichert. SEOlytics gelang es, einen aussagekräftigen Schnappschuss dieser SERP-Veränderungen zu machen:

Seems Google is testing „embedded“ in-depth articles – look like organic now. cc @rustybrick @dr_pete pic.twitter.com/mrQvuoWy9j— SEOlytics (@SEOlytics) 9. April 2015

- „City Pages“ bei der lokalen Suche: Wie wir vor einigen Wochen berichteten, kündigte Google das verstärkte Vorgehen gegen „Doorway Pages“ an. Im Hinblick auf die lokale Suche nimmt dies Einfluss auf die lange Zeit betriebenen „City Pages“. Was sich hinter diesem Prinzip verbirgt und wie Webmaster den Betrieb hinsichtlich Googles erhobenem Zeigefinger handhaben sollten, lest ihr auf dem KennstDuEinen-Blog nach, und erhaltet eine sehr detaillierte Anleitung. Sehr lesenswert, finden wir!

- Werbefreies YouTube: Schon länger gab es Spekulationen, doch seit gestern ist es offiziell, dass YouTube seinen Usern bald eine werbefreie, aber kostenpflic

htige Plattform anbieten wird. Für 9,99 Dollar pro Monat sollen die Besucher werbefreien Zugriff auf alle Inhalte haben. Werbepartner, denen dadurch Umsatz wegzubrechen droht, sind verpflichtet, am neuen Programm teilzunehmen, sollen ihre möglichen Verluste allerdings durch Umsatzbeteiligungen ausgleichen können. Das berichtet der GoogleWatchBlog.

htige Plattform anbieten wird. Für 9,99 Dollar pro Monat sollen die Besucher werbefreien Zugriff auf alle Inhalte haben. Werbepartner, denen dadurch Umsatz wegzubrechen droht, sind verpflichtet, am neuen Programm teilzunehmen, sollen ihre möglichen Verluste allerdings durch Umsatzbeteiligungen ausgleichen können. Das berichtet der GoogleWatchBlog. - Von „Google Analytics“ zu „Universal Analytics“: Webmaster finden diese Woche eine hilfreiche Schritt-für-Schritt-Anleitung auf t3n, wenn sie planen, auf die neueste Version ihres Google-Analytics-Zugangs umzustellen. Bevor es zum automatischen Update von „Universal Analytics“ kommt, empfiehlt t3n ein serielles Update. Warum und wie das funktioniert, lest ihr im ausführlichen Artikel.

So, wieder alle up to date? Bevor ihr euch ins Wochenende verabschiedet, haben wir noch etwas zum Lachen von den OnlineMarketingRockstars für euch! Im Anschluss daran wünschen wir euch ein (hoffentlich) sonniges Wochenende! Bis nächste Woche, sagen

Sandra und die SEO Trainees

P.S.: Alle Serien-Fans unter euch wird diese Meldung erfreuen. Spoiler adé! 😉

3 Antworten

Ich möchte kurz nochmal auf den robots.txt-Test eingehen, weil ich bereits Tweet gesehen habe, die das Testergebnis falsch interpretiert haben und sich nur Google, aber nicht Bing und Yahoo! an die Anweisungen halten.

Dass versucht wird, auch gesperrte Inhalte in alle Indizes aufzunehmen ist richtig, auch bei Google. Im Test hatten Bing und Yahoo! zwei URLS direkt gecrawlt, trotz Verbots, das ist auch richtig. Allerdings könnten sie das zu einem so frühen Zeitpunkt getan haben, zu der sie die robots.txt noch nicht neu eingelesen hatten.

Per se zu sagen, Bing und Yahoo! halten sich nicht an die robots.txt finde ich etwas zu weit gegriffen. Eine entsprechende Notiz wird im Test auch immer wieder erwähnt: http://nblogs.de/seo-test-google-robots-txt-gesperrte-inhalte-5422/#fazitbing

Schöne Grüße

Pascal

Danke für den Hinweis, Pascal! Vielleicht waren wir da etwas zu verallgemeinernd 😉