Veranstaltungsvorbereitung, spannende Vorträge und jede Menge Networking auf der OMCap in Berlin. Da muss kaum noch Zeit bleiben, um sich durch die bunte Welt der Online-Marketing-Aktualitäten zu schlagen. Aber zum Glück gibt es ja unser wöchentliches Recap, das im gewohnt kompakten Format alle Neuigkeiten und lesenswerten Artikel der letzten Tage zusammenfasst. Top-Themen waren Erfolge und Machenschaften bei Facebook, Veränderungen nach dem erneuten US-Panda-Update sowie das gute alte Linkbuilding.

Die Omnipräsenz von Social Media, pardon, Facebook!

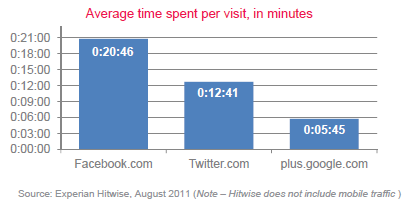

Facebook und Co. haben die Internetwelt erobert. So oder so ähnlich könnte das Resümee des „2011 Social Media Consumer Trend and Benchmark Reports“ lauten. Mittlerweile nutzen 91% aller erwachsenen US-Internetnutzer mindestens einmal im Monat Social-Media-Angebote, wobei zu diesen – neben Facebook, Twitter etc. – auch Video- und Foto-Sharing-Plattformen sowie Social-Bookmarking-Dienste zählen. Facebook dominiert den Social-Media-Bereich sowohl bei der Nutzungsfrequenz, als auch bei der Aufenthaltsdauer. Während im Juli 2008 nur knapp 20% aller Internetnutzer Facebook einen Besuch abgestattet haben, so waren es im Juli 2011 bereits 58%. Interessant ist auch die Gruppe der Best Ager (50+), wovon mittlerweile 40% als Facebook-affin gelten können. Der durchschnittliche Facebook-Besucher hält sich auf seiner Lieblingsplattform im Schnitt 20 Minuten auf. Twitter kommt lediglich auf eine Aufenthaltszeit von knapp 13 Minuten und Google+ ist Schlusslicht mit 5 Minuten. Was den Kreis der im Schnitt 130 Freunde anbelangt, so wird dieser immer mehr von Familienmitgliedern durchtränkt. Ganze 27% greifen auf Social Media zurück, um mit Geschwistern, 18% um mit ihren Kindern und 14% um mit ihren Eltern in Kontakt zu bleiben.

Tja, und was ist das Motto von Facebook? „Immer höher, immer besser!“ Nachdem schon in den letzten Wochen zahlreiche Veränderungen in der Timeline und im Profil bekanntgegeben wurden, gibt es seit dieser Woche auch einen integrierten Universal Übersetzer. Die Translations beruhen auf dem Übersetzer von Bing, maschinelle Schwächen sollen jedoch durch ein Crowdsourcing-Konzept ausgeglichen werden. Wie zdnet.de berichtet, kann jeder, der mit der ausgegebenen Übersetzung nicht zufrieden ist, eine eigene Version verfassen. Bekommt diese genügend Zuspruch von anderen Nutzern, dann wird sie bei zukünftigen Aufrufen die Bing-Variante ersetzen.

Da fragt man sich doch in diesem Zusammenhang, warum Facebook es nötig hat, Anwendungen von Google+ zu untergraben. Wie Erik von ring2.de nämlich festgestellt hat, wird bei Benutzung des neuen Facebook iPad Apps der Google+ Button im Webbrowser herausgefiltert. Nur der Facebook Button sowie das Twitter Icon werden eingeblendet. Absicht oder doch ein technischer Defekt?

Und das ist los bei Google

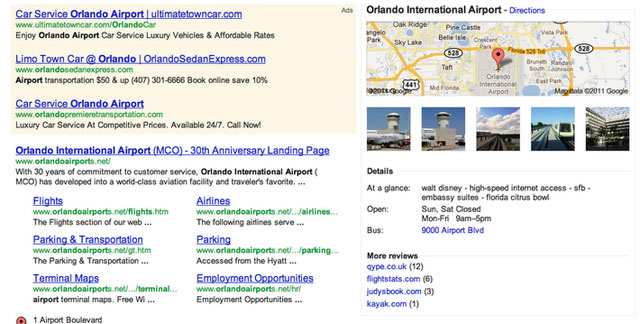

Nun gut, wenn Google+ ein wenig hinterherhängt, dann schauen wir uns mal an, was beim Suchmaschinengiganten sonst noch so passiert. Da sind zunächst einmal Experimente mit den Google-Maps-Einblendungen in den SERPs. Seroundtable.com berichtet von Beobachtungen, wobei die Karte bei dem Suchbegriff „Orlando International Airport“ mit Bildern und weiteren Details einen Großteil der rechten Seite einahm. Die Google-Adwords-Anzeigen waren komplett verschwunden (vgl. Grafik). Es deutet somit immer mehr darauf hin, dass Google an einem anderen Darstellungsformat arbeitet, wobei auch den Anzeigen ein neuer Bereich zugeordnet wird. Erinnerungen an Tests mit Ads im organischen Bereich und Spekulationen über eine Aufhebung der Paginierung rücken hierdurch wieder ins Rampenlicht.

Für weitere Aufregung sorgte die offizielle Veröffentlichung von Google Pagespeed. Nach längerem Betastadium und eher komplizierten Aufrufmöglichkeiten über Firefox-Plugins und andere Webseiten, ist das Tool nun für jedermann unter https://developers.google.com/pagespeed/ frei zugänglich. Das Besondere daran? Nun, das Tool integriert ebenso die Daten von Yahoo Yslow und findet auf diese Weise mehr Fehler. Wie Julian von seokratie.de feststellte, ist aber auch die Tatsache, dass Google einem höchstpersönlich sagt, was es von der Ladegeschwindigkeit der Seite hält, ein einmaliger Trumpf.

Linkbuilding-Methoden auf dem Prüfstand

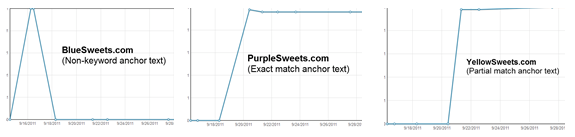

Diese Woche war, wie kaum eine andere, geprägt von äußerst lesenswerten Artikeln zum Thema „Linkbuilding“. Den Anfang machte ein sehr aufschlussreiches Experiment von seomoz-Autor James Agate. Dieser wollte der Frage nachgehen, welche Linktexte auf lange Sicht zu einem erfolgreichen Ranking führen. Dazu setzte er drei Domains auf, die alle nach demselben Prinzip gestaltet waren, sich aber zwecks DC-Vermeidung in Text und Bild unterschieden. Für alle drei wählte er eine eigene Linkbuilding-Strategie. Bei der ersten Domain verlinkte er ausschließlich mit Non-Keywords wie „hier klicken“ und „dieser Artikel“, bei Nummer 2 fuhr er die gegenteilige Strategie und verlinkte mit dem exakten Begriff, für den die Domains ranken sollten. Bei Nummer 3 setzte er auf Keyword-Variationen. Interessant sind vor allem die Entwicklungen, die diese Domains durchmachten. Am Tag 2 rutschte die erste Domain mit den Non-Keyword-Begriffen gleich auf Platz 1, während die anderen noch nicht einmal in der Top 50 vertreten waren. Am vierten Tag änderte sich jedoch das Bild. Nummer eins verschwand wieder endgültig aus den Top 50 und dafür nahm Variante 3 mit den Keyword-Variationen den Platz ein. Die zweite Variante mit den Keywordlinks zog irgendwann nach und ordnete sich schließlich einen Platz dahinter ein. Graphisch lässt sich die Entwicklung der drei Domains folgendermaßen darstellen:

Was lernen wir aus diesem Experiment? Non-Keyword-Links sind vielleicht wichtig für den Linkmix und ein natürliches Profil, aber sie führen nicht zu einem guten Ranking. Keyword-Variationen im Linktext sind auf lange Sicht die beste Lösung.

Andere Faktoren eines guten Linkprofils fasste Tim auf seowizz.net zusammen. So schlug er u.a. vor, Google Suggest für das Auffinden von Keyword-Varianten zu benutzen, mindestens 30% Brand-Links zu haben (obwohl dieses natürlich auch branchenabhängig ist), Blekko für das Kontrollieren der Länderverteilung zu gebrauchen und Site-Wide-Links höchstens „brand-based“ zu etablieren, da diese immer noch mit sträflichem Linkkauf in Verbindung gebracht werden.

Um mal die SEO-Gemeinde voten zu lassen, welche Faktoren einen guten Backlink ausmachen, führt seo-united.de gerade eine spannende Umfrage durch. Bisher (Freitag, 11 Uhr) führen die folgenden drei Eigenschaften das Ranking an:

- Der Inhalt der linkgebenden Seite ist themenrelevant. (64% der Votes)

- Der Content der linkgebenden Seite ist qualitativ hochwertig. (62% der Votes)

- Der Link ist nicht mit einem NoFollow/einer Maskierung versehen. (54%)

Dmoz jedenfalls ist kein guter Linkgeber mehr und wurde von Google zurückgestuft. Gründe dafür sind in der Art und Weise, nach der Artikel aufgenommen werden, in korrupten Editoren und der Tatsache, dass viele Kategorien gar nicht mehr gepflegt werden, zu sehen.

Freud und Leid durch Rankingveränderungen

Was man tun kann, wenn die Webseite Rankings verliert, fasst uns Björn Tantau, bezugnehmend auf eine Videobotschaft von Matt Cutts, zusammen. Empfehlenswert sei es demnach, erst einmal zu prüfen, ob die Seite nicht durch die robots.txt o.Ä. komplett von der Indexierung ausgeschlossen ist bzw. die Rankingverluste auch in anderen Suchmaschinen nebst Google zu beobachten sind. Ist dieses nicht der Fall, dann kann man wohl sichergehen, dass der Fehler nicht auf der eigenen Seite zu lokalisieren ist. Jetzt eignet sich das Checken der Nachrichtenbox in den Webmaster Tools, um festzustellen, ob Google eine Message hinterlassen hat. Bei anhaltender Ratlosigkeit lohnt ein Blick in das Webmaster Forum, da eventuell der Austausch mit anderen Webmastern zu der Erkenntnis führt, dass eine Algorithmusanpassung stattgefunden hat. Schließlich sei es noch möglich, einen Wiederaufnahmevertrag zu stellen. Auch wenn die Umsetzung dessen bis zu 6 Monate dauern kann, würde es jetzt angeblich Infos von Google zum eigentlichen Problem hageln. Aha. 🙂

Vielleicht lohnt aber auch ein darauf Hoffen, dass Google die Algorithmusveränderung wieder zurücknimmt, wie jetzt beim letzten Panda-Update in den USA geschehen. Wie bei searchmetrics.com im Blog zu lesen war, haben beim letzten Update 80-90% aller Domains ihre alte Sichtbarkeit zurückgewonnen. Weitere Domains waren sogar in der Lage, ihre ursprünglichen Werte noch einmal zu übertreffen.

Nun ja, dass die ganze Materie kein einfaches Unterfangen ist, rechtfertigt in jedem Fall das Dasein von SEO-Agenturen, welche dringend gut ausgebildete Nachwuchskräfte brauchen. In diesem Zusammenhang sei noch einmal auf das Interview mit Patrick Klingberg bei webschorle.de hingewiesen, bei dem er in anschaulicher Weise unser Traineeprogramm beschreibt.

Ein paar Ankündigungen in eigener Sache

Letztendlich wollen wir noch den Gewinner der wunderbaren Zukunftsreise zum ConventionCamp küren. Das Los hat entschieden und unsere Kristallkugel sieht bereits Torsten Rammrath ins All fliegen. Wir sind gespannt, ob sich deine sehr genaue Vision von der Zukunft erfüllen wird.

Wer jetzt kein Ticket für das ConventionCamp ergattern konnte, der interessiert sich vielleicht für die Search Conference, welche in verschiedenen Städten Deutschlands am 10.11.2011 stattfindet und sich an Online-Marketing-Leiter, Online-Marketing-Manager, SEO/SEM-Verantwortliche, E-Commerce-Leiter und Geschäftsführer aus mittelständischen bis Großunternehmen aller Branchen richtet. Auf den eintägigen Konferenzen erhalten alle Teilnehmer einen kompakten Überblick über die aktuellen Trends. Sie hören spannende Case Studies, aktuelle Studien und Vorträge zu Linking-Strategien, Keywordauswahl, SEO & Social Media Marketing, Google Universal Search & Co.

Wer jetzt kein Ticket für das ConventionCamp ergattern konnte, der interessiert sich vielleicht für die Search Conference, welche in verschiedenen Städten Deutschlands am 10.11.2011 stattfindet und sich an Online-Marketing-Leiter, Online-Marketing-Manager, SEO/SEM-Verantwortliche, E-Commerce-Leiter und Geschäftsführer aus mittelständischen bis Großunternehmen aller Branchen richtet. Auf den eintägigen Konferenzen erhalten alle Teilnehmer einen kompakten Überblick über die aktuellen Trends. Sie hören spannende Case Studies, aktuelle Studien und Vorträge zu Linking-Strategien, Keywordauswahl, SEO & Social Media Marketing, Google Universal Search & Co.

SEO-Trainee.de ist Partner der Search Conference. Profitiert von Sonderkonditionen und besucht die Veranstaltung zum Preis von € 189,- zzgl. MwSt.! Einfach Rabattcode „PROseo11Hseo“ bei der Anmeldung angeben.

Das war’s auch schon von uns. Wir wünschen allen Online-Marketing-Interessierten ein erholsames Wochenende!

Eure Kerstin und die SEO-Trainees

3 Antworten

Vielen Dank für den Gewinn!!! Ich freue mich sehr und hoffe auf Bestätigung meiner Visionen 😀

Und vielen Dank für den interessanten Wochenrückblick. Wieder wertvolle hinweise zu aktuellen Themen. Wie in der Wissenschaft sollte öfter mal die Primärquelle herangezogen werden 😉

„Dmoz jedenfalls ist kein guter Linkgeber mehr und wurde von Google zurückgestuft. Gründe dafür sind in der Art und Weise, nach der Artikel aufgenommen werden, in korrupten Editoren und der Tatsache, dass viele Kategorien gar nicht mehr gepflegt werden, zu sehen.“

Kein guter Linkgeber mehr? Quatsch.. Matt Cutts sagt lediglich, Google wird die Daten des DMOZ nicht weiterhin für das Google Directory verwenden, das hat aber nix damit zu tun, dass das DMOZ abgestraft worden wäre 😉

Einfach mal das Video auf http://googlewebmastercentral-de.blogspot.com/2011/10/zahlen-mehrere-links-von-einer-seite.html anschauen oder die Description lesen.

Grüße

Pascal

Hallo Pascal,

vielen Dank für dein Feedback. Da lohnt es sich, wenn man der Ursprungsquelle auf den Grund geht. Die Schlussfolgerung, dass wenn Google die Dmoz-Daten nicht mehr für das Google Directory verwendet, Google Dmoz als Empfehlungsseite auch weniger schätzt, war vielleicht zu weit geschossen. Die PageRank-Vererbung etc. ist dann wohl immer noch interessant.

Viele Grüße und ein schönes Wochenende